使用场景

用于图像和文本的联合理解和生成任务。

在聊天机器人中结合图像理解提供更丰富的用户体验。

作为多模态数据处理的后端模型,支持各种智能应用。

产品特色

提供多种视觉编码器选择,如 EVA-CLIP、SigLIP。

支持多种语言主干网络,包括 Llama-3-8B、Phi-1.5 等。

通过精选数据源构建更丰富的训练数据。

Bunny-v1.0-3B 模型在多语言环境下表现优异。

Bunny-Llama-3-8B-V 模型基于 Llama-3,展示出卓越的性能。

支持在 HuggingFace、ModelScope 和 wisemodel 平台上查找更多细节。

提供了针对中文问答能力的模型,如 Bunny-v1.0-3B-zh 和 Bunny-v1.0-2B-zh。

使用教程

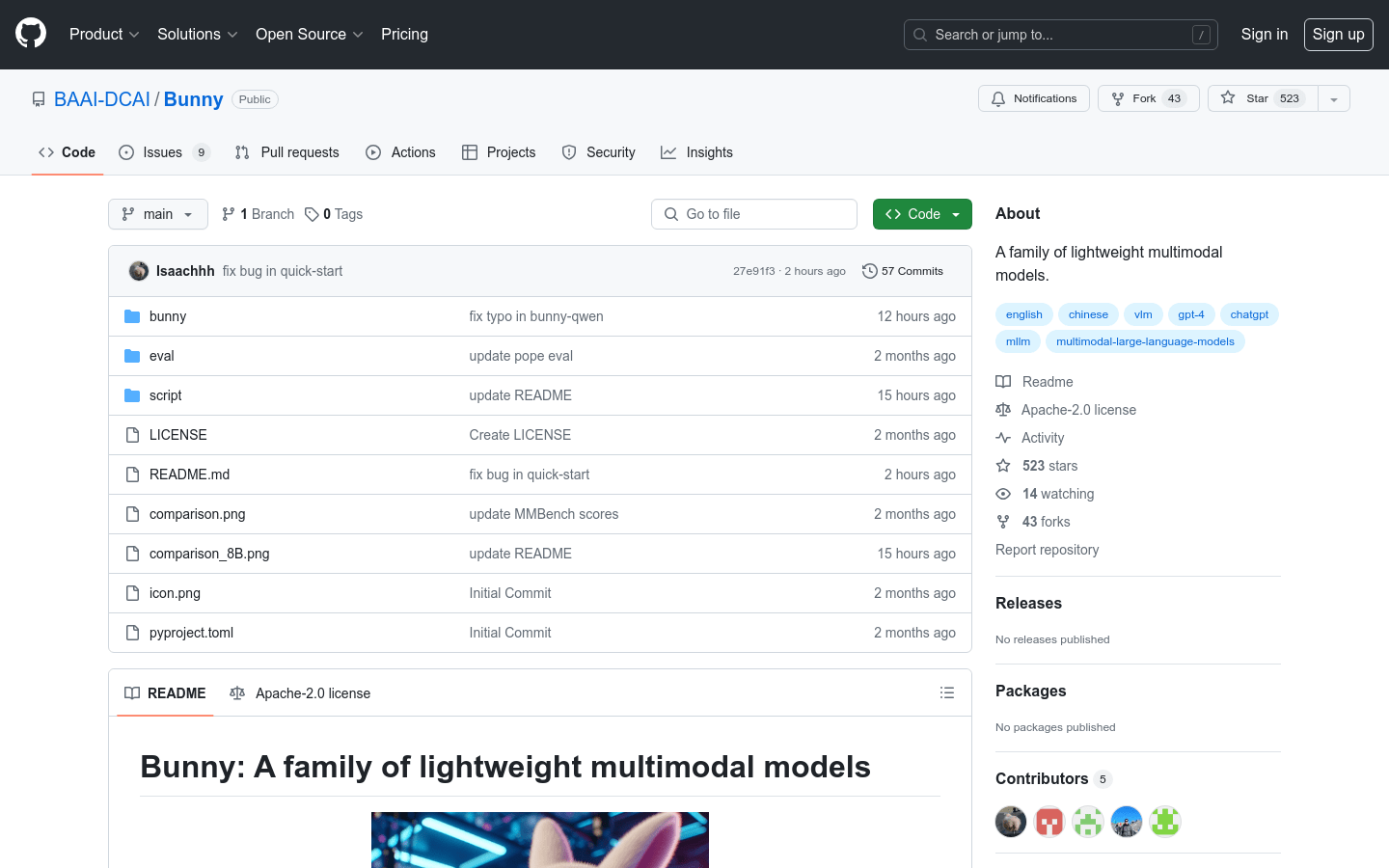

步骤1:访问 Bunny 的 GitHub 页面以获取更多信息。

步骤2:根据需要选择合适的模型版本进行下载。

步骤3:安装必要的依赖,如 torch 和 transformers。

步骤4:使用提供的代码片段或脚本进行模型的预处理和训练。

步骤5:通过 Gradio Web UI 或 CLI 进行模型的交互和推理。

步骤6:根据具体应用场景调整模型参数以获得最佳性能。