使用场景

使用Mamba进行Temporal Action Localization以提高动作识别的准确性。

集成Video Temporal Grounding模型以增强视频内容的交互式分析。

利用Video Mamba Suite进行Long-form Video Question-Answer任务,提升视频问答系统的智能度。

产品特色

视频时间建模:用于时间动作定位、时间动作分割、视频密集字幕生成等任务。

跨模态交互:实现视频时间定位和高亮检测等交互式任务。

视频时间适配器:支持零样本/微调多实例检索和微调动作识别。

空间-时间建模:提供零样本/微调多实例检索和微调动作识别功能。

模型动物园:包含多种预训练模型,如TimeSformer-B、CLIP-400M、Ego4D-4M等。

使用教程

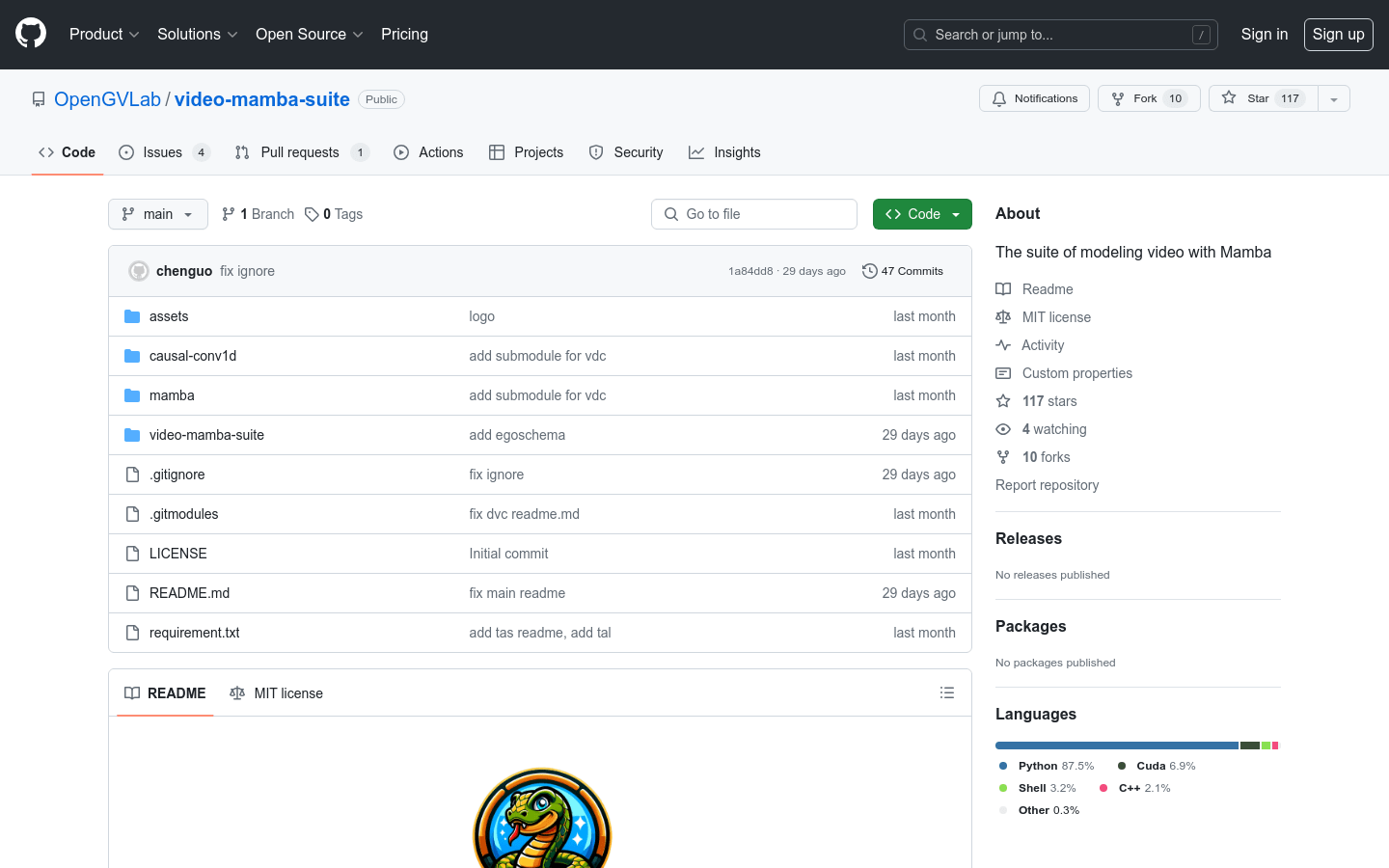

步骤1:克隆Video Mamba Suite的代码库到本地。

步骤2:创建并激活Python 3.9环境。

步骤3:安装PyTorch及相关依赖库。

步骤4:根据requirements.txt安装其他必要的Python库。

步骤5:进入causal-conv1d和mamba目录,分别运行setup.py进行开发环境设置。

步骤6:根据具体任务的文件夹中的安装指南进行操作。

步骤7:运行相关脚本或命令,开始使用Video Mamba Suite进行视频理解任务。