使用场景

使用VILA进行视频内容的自动标注和分析。

在教育平台中集成VILA,提供图像和视频的智能解读功能。

将VILA应用于智能安防系统,进行实时视频监控和异常行为检测。

产品特色

视频理解能力:VILA-1.5版本提供了视频理解功能。

多模型尺寸:提供3B/8B/13B/40B四种模型尺寸。

高效部署:通过AWQ量化的4bit VILA-1.5模型,可在多种NVIDIA GPU上高效部署。

上下文学习:在交错图像-文本预训练期间不冻结LLM,促进上下文学习。

标记压缩:通过标记压缩技术扩展视频帧数,提升模型性能。

开源代码:包括训练代码、评估代码、数据集和模型检查点在内的所有内容均已开源。

性能提升:通过特定技术手段,如重新混合文本指令数据,显著提升VLM和纯文本性能。

使用教程

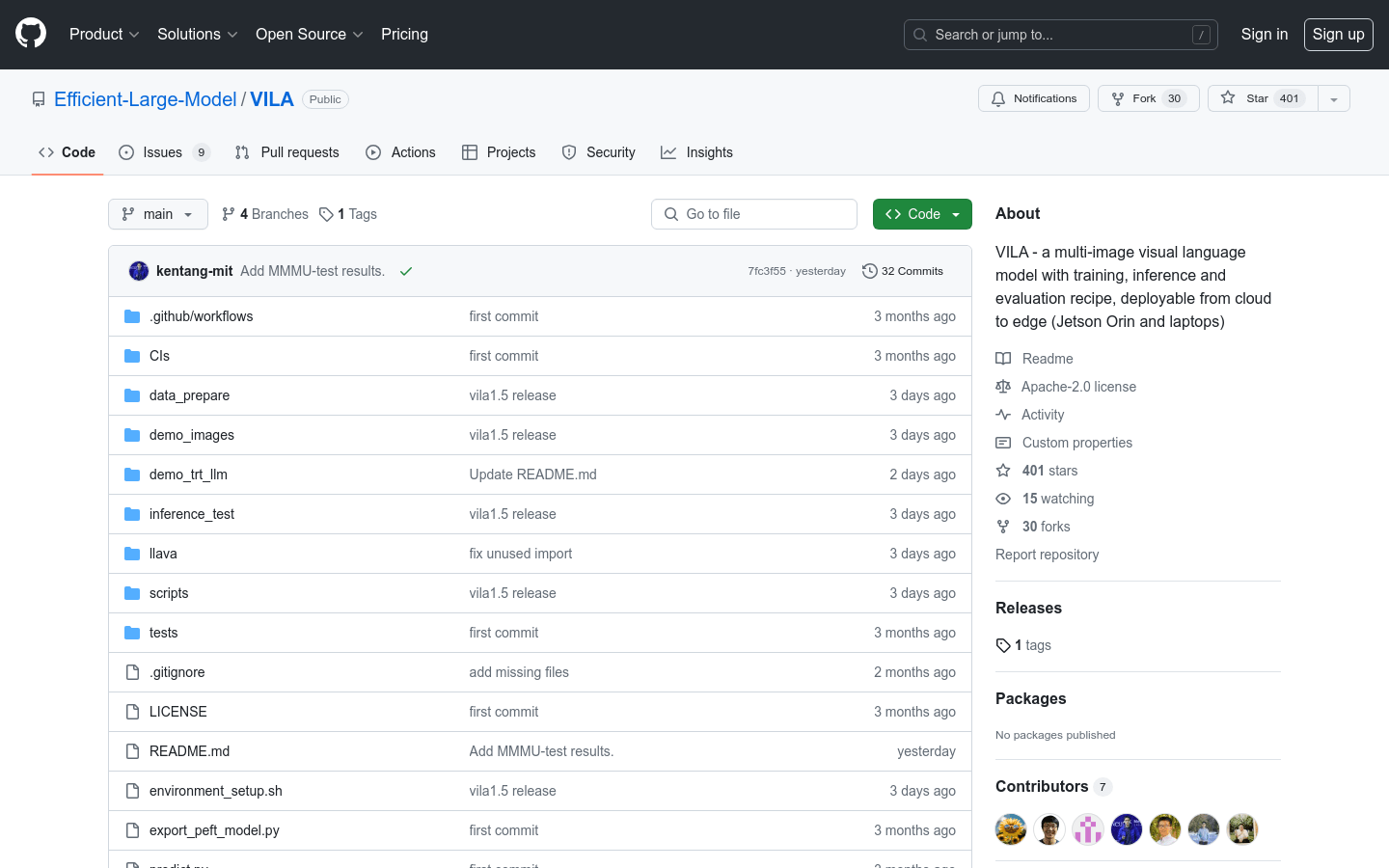

步骤1:访问VILA的GitHub仓库页面以获取项目代码。

步骤2:根据仓库中的指南安装必要的环境和依赖。

步骤3:下载并配置VILA的预训练模型。

步骤4:使用提供的训练脚本对VILA进行进一步的训练或微调,以适应特定的应用场景。

步骤5:利用推理脚本对新的图像或视频数据进行处理,获取模型输出。

步骤6:根据应用需求,将模型输出整合到最终的产品或服务中。