使用场景

用于开发能够理解长篇文章的自动助理

在商业智能中分析和预测市场趋势

作为聊天机器人的后端,提供更丰富的对话内容

产品特色

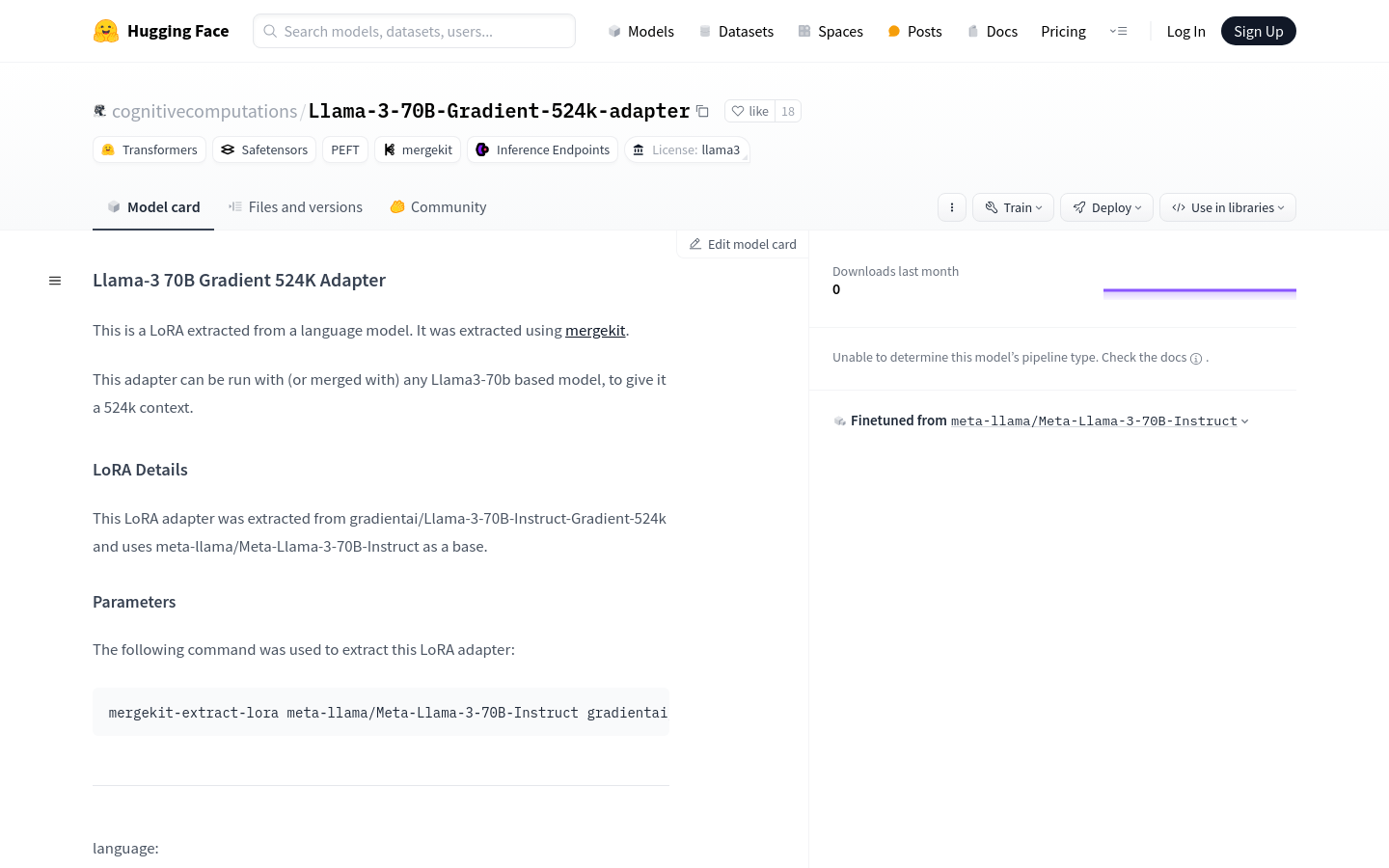

使用LoRA技术扩展上下文长度至524K

基于Gradient AI Team的Llama-3-70B-Instruct-Gradient-524k模型

利用meta-llama/Meta-Llama-3-70B-Instruct作为基础模型

通过NTK-aware插值和RingAttention库进行高效训练

在Crusoe Energy的高性能L40S集群上进行训练

生成长文本上下文以增强模型性能

在UltraChat数据集上进行微调以提升对话能力

使用教程

步骤1: 下载并安装适配器所需的Llama-3-70B基础模型

步骤2: 使用mergekit工具将LoRA适配器与基础模型合并

步骤3: 根据需要调整模型参数,如RoPE theta和序列长度

步骤4: 在高性能计算集群上进行模型训练

步骤5: 使用生成的模型进行文本生成或其他相关任务

步骤6: 对模型进行评估和测试,确保其符合应用需求