使用场景

评估一个语言模型在情感分析任务上的表现

比较两个不同模型在文本生成任务中的优劣

作为开发新语言模型时的测试基准

产品特色

绝对评分:根据给定的指令、参考答案和评分标准,输出1到5的分数

相对评分:基于给定的指令和评分标准,评估两个响应,输出'A'或'B'以表示更好的响应

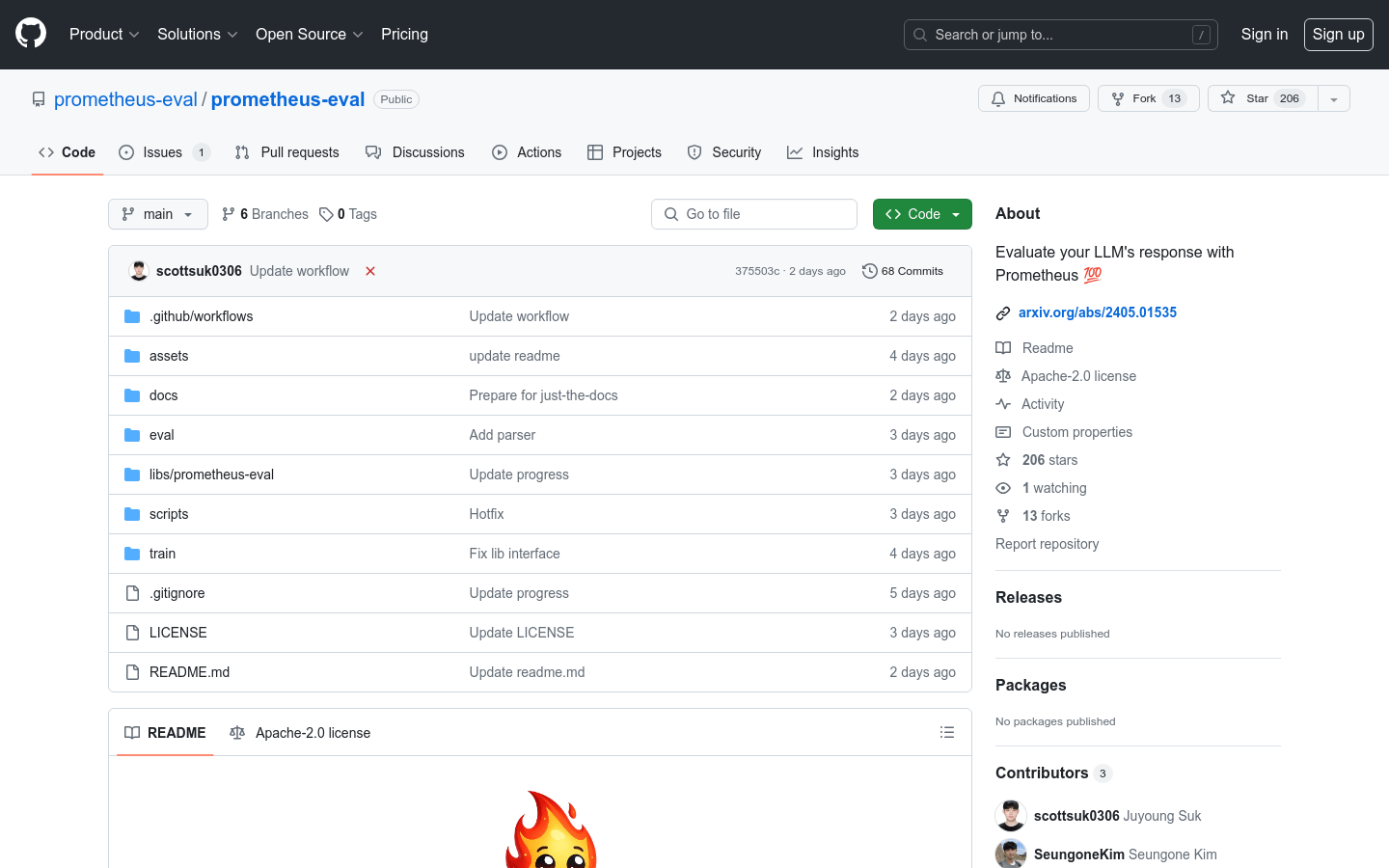

支持直接从 Huggingface Hub 下载模型权重

提供 Python 包 prometheus-eval 用于简化评估过程

包含训练 Prometheus 模型或在自定义数据集上微调的脚本

提供评估数据集,用于训练和评估 Prometheus 模型

支持在消费者级 GPU 上运行,减少资源需求

使用教程

步骤1:安装 Prometheus-Eval Python 包

步骤2:准备评估所需的指令、响应和评分标准

步骤3:使用绝对评分或相对评分方法进行评估

步骤4:根据输出的分数或等级,分析模型表现

步骤5:根据评估结果调整和优化语言模型