使用场景

在搜索引擎中对搜索结果进行排序,提高检索相关性

在推荐系统中对推荐列表进行优化,提升用户体验

在问答系统中对候选答案进行排序,提供更准确的回答

产品特色

支持多种排序模型,如Cross Encoder Reranker和LLM Reranker

对长文档友好,支持最大长度截断和切分取最大分值的处理逻辑

易于扩展,新排序模型的集成只需继承basereranker并实现特定函数

提供了统一的接口,简化了不同模型的推理过程

支持微调任意开源的RAG检索模型

提供了详细的使用教程和测试案例,方便用户学习和对齐原有推理框架

使用教程

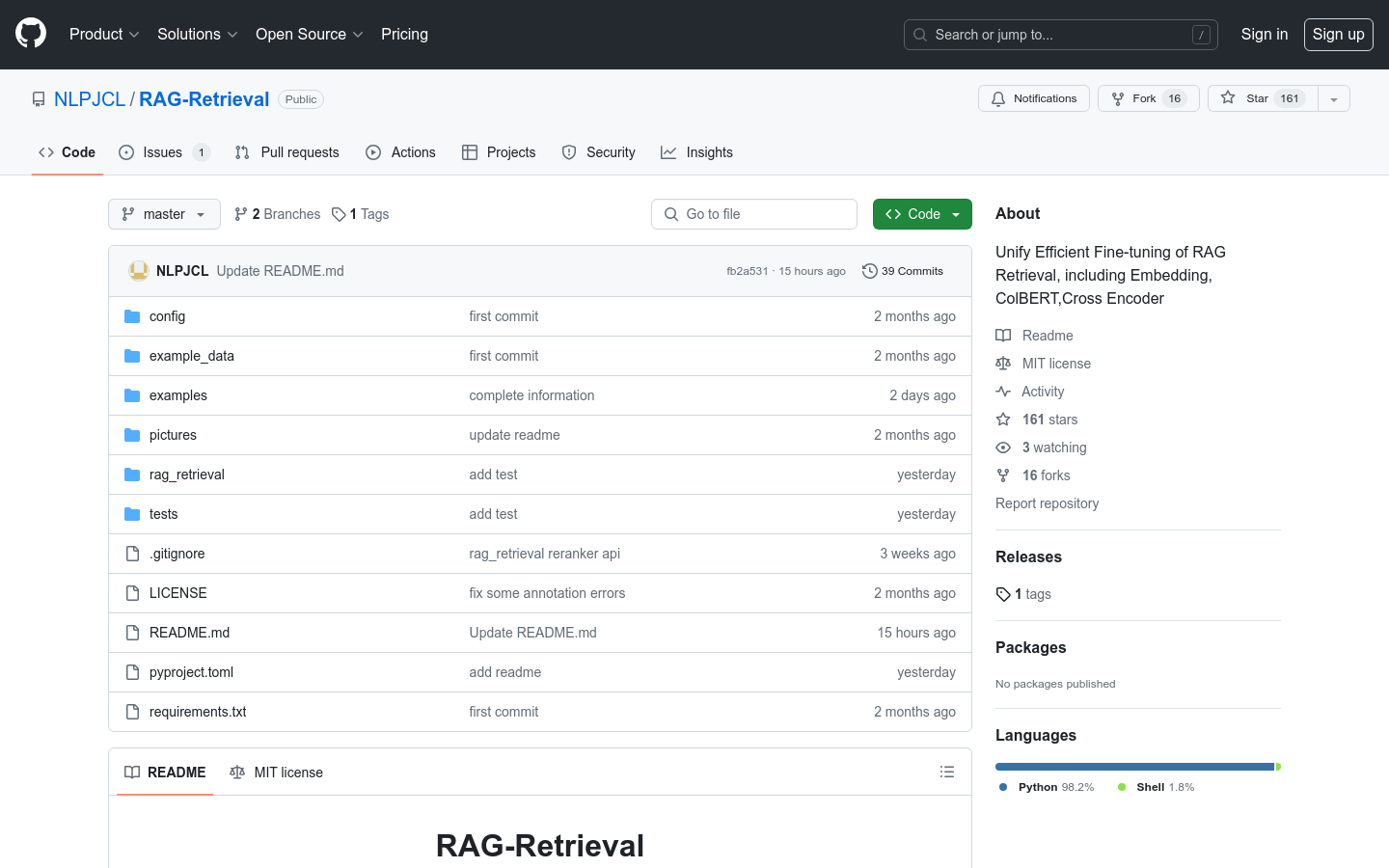

步骤1:访问RAG-Retrieval的GitHub页面并下载代码

步骤2:根据系统环境手动安装与本地CUDA版本兼容的torch

步骤3:通过pip安装rag-retrieval库

步骤4:根据需要选择并配置支持的Reranker模型

步骤5:使用rag-retrieval库进行模型的推理或微调

步骤6:根据提供的测试案例验证模型性能

步骤7:集成到具体应用中,进行实际的检索和排序任务