使用场景

使用 TensorDock 的 GPU 云服务进行大规模的神经网络训练。

利用 TensorDock 的容器托管服务部署机器学习模型。

通过 TensorDock 的 CPU 云服务进行复杂的科学计算和数据分析。

产品特色

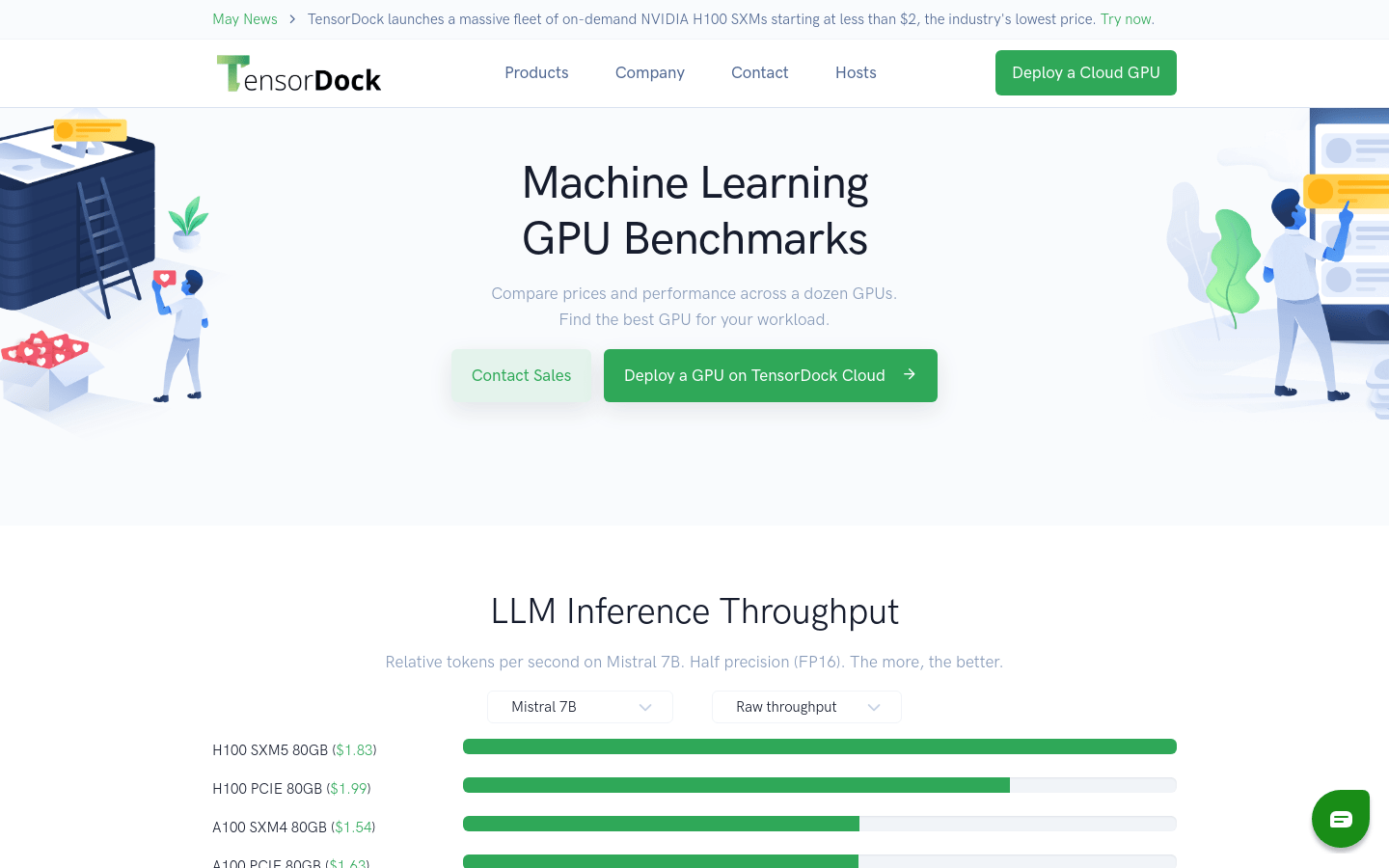

提供 NVIDIA H100 SXMs 等高性能 GPU 服务器

支持深度学习、AI 和渲染工作负载

全托管容器托管服务,包含 OS 级监控和负载均衡

自动扩展功能,适应不同的工作负载需求

提供 Intel Xeon 和 AMD EPYC 处理器的 CPU 云服务

GPU 云服务具有成本效益,适合科学计算和高性能计算工作负载

提供详细的 GPU 性能基准测试,帮助用户选择最合适的 GPU

使用教程

步骤1:访问 TensorDock 官网并注册账户。

步骤2:根据工作负载需求选择合适的 GPU 或 CPU 服务器。

步骤3:部署所需的服务器或容器,并进行配置。

步骤4:上传所需的数据和应用程序到 TensorDock 提供的云服务中。

步骤5:开始运行深度学习模型训练、AI 模型推理或渲染工作。

步骤6:利用 TensorDock 的监控工具实时跟踪服务器性能和资源使用情况。

步骤7:根据需要调整资源配置,优化工作负载性能。