使用场景

使用Gemma 2B - 10M Context生成《哈利波特》系列书籍的摘要

在教育领域中,为学术论文自动生成概要

在商业领域,为产品描述和市场分析自动生成文本内容

产品特色

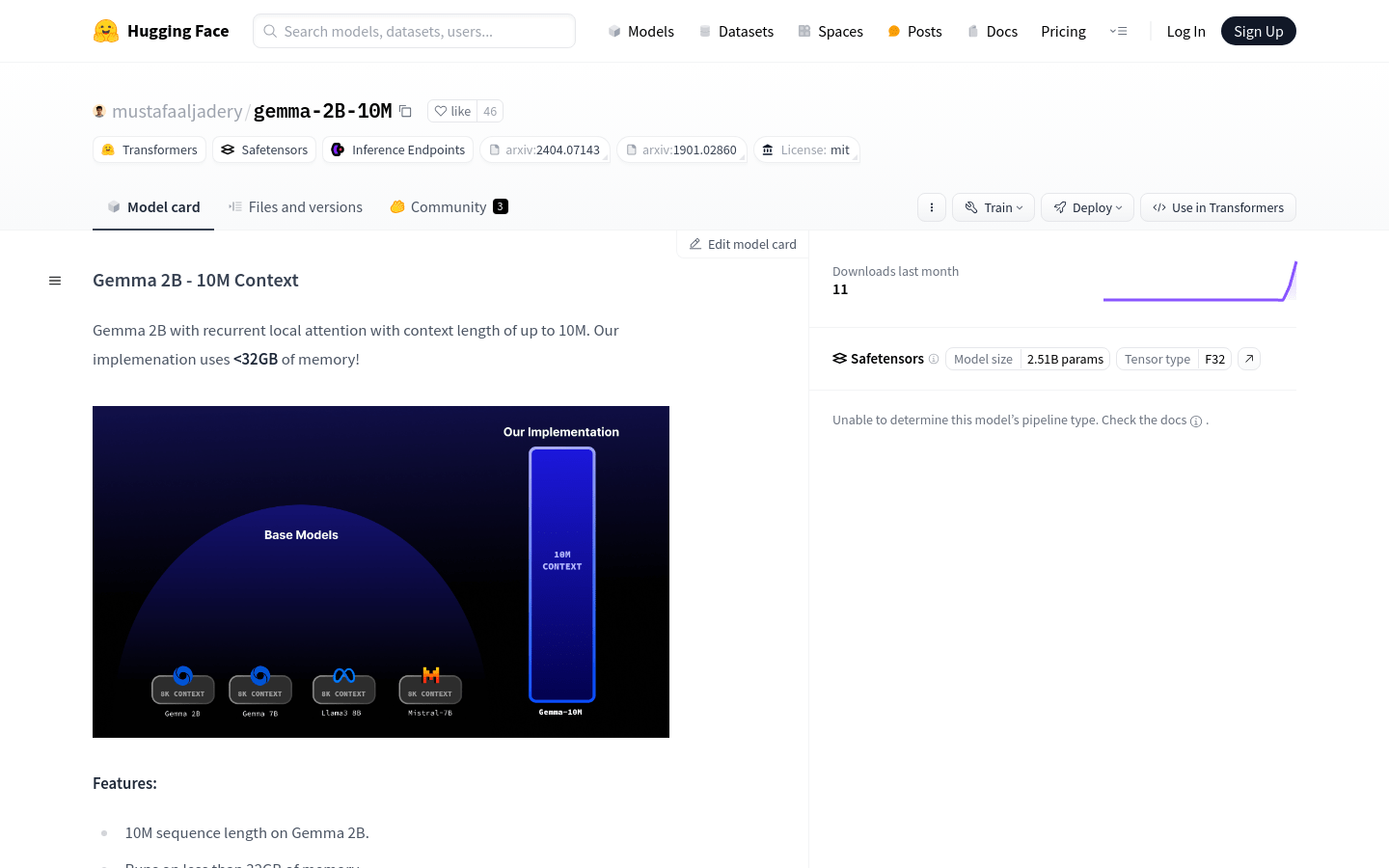

支持10M序列长度的文本处理能力

在低于32GB内存下运行,优化资源使用

专为CUDA优化的原生推理性能

循环局部注意力实现O(N)内存复杂度

200步早期检查点,计划训练更多token以提升性能

使用AutoTokenizer和GemmaForCausalLM进行文本生成

使用教程

步骤1: 安装模型,从huggingface获取Gemma 2B - 10M Context模型

步骤2: 修改main.py中的推理代码以适应特定的提示文本

步骤3: 使用AutoTokenizer.from_pretrained加载模型的分词器

步骤4: 使用GemmaForCausalLM.from_pretrained加载模型并指定数据类型为torch.bfloat16

步骤5: 设置提示文本,例如'Summarize this harry potter book...'

步骤6: 在不计算梯度的情况下,使用generate函数生成文本

步骤7: 打印生成的文本以查看结果