使用场景

用户可以在浏览器中直接运行Phi-3 WebGPU进行文本生成

研究人员可以利用Phi-3 WebGPU进行语言模型的本地测试和分析

开发者可以集成Phi-3 WebGPU到自己的网页应用中,提供智能交互功能

产品特色

本地数据处理,保护用户隐私安全

WebGPU加速,处理速度超过20t/s

模型缓存,避免重复下载

支持在浏览器中直接运行AI模型

英文回答效果令人满意

中文回答存在一些幻觉现象

使用教程

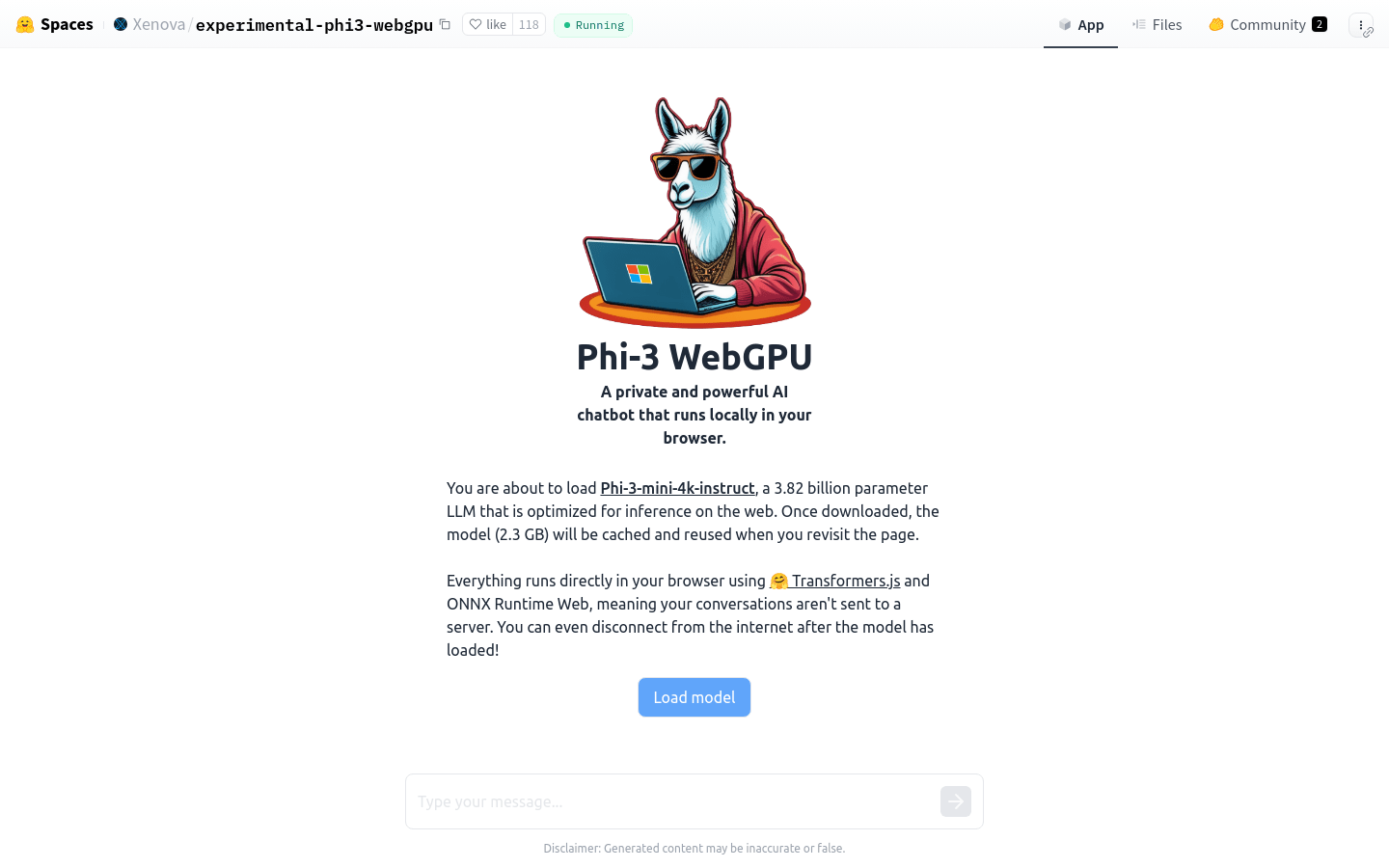

访问Phi-3 WebGPU的体验地址

等待模型文件自动下载(首次运行需要下载2.3GB的模型文件)

在本地浏览器中输入需要处理的文本或指令

获取Phi-3 WebGPU处理后的结果

根据需要调整输入参数,优化输出结果

利用模型缓存功能,提高重复使用效率