使用场景

研究人员使用LLM Comparator比较不同模型在特定科学问题上的回答质量。

开发者利用该工具测试和优化自己的语言模型。

学生通过比较不同模型的回答来学习机器学习和自然语言处理的相关知识。

产品特色

输入问题或提示,获取多个模型的回答

比较不同模型在理解问题和生成文本方面的表现

分析模型回答的准确性和一致性

支持多种语言模型,包括但不限于GPT、BERT等

提供可视化界面,方便用户操作和比较

支持用户自定义模型参数,进行个性化比较

使用教程

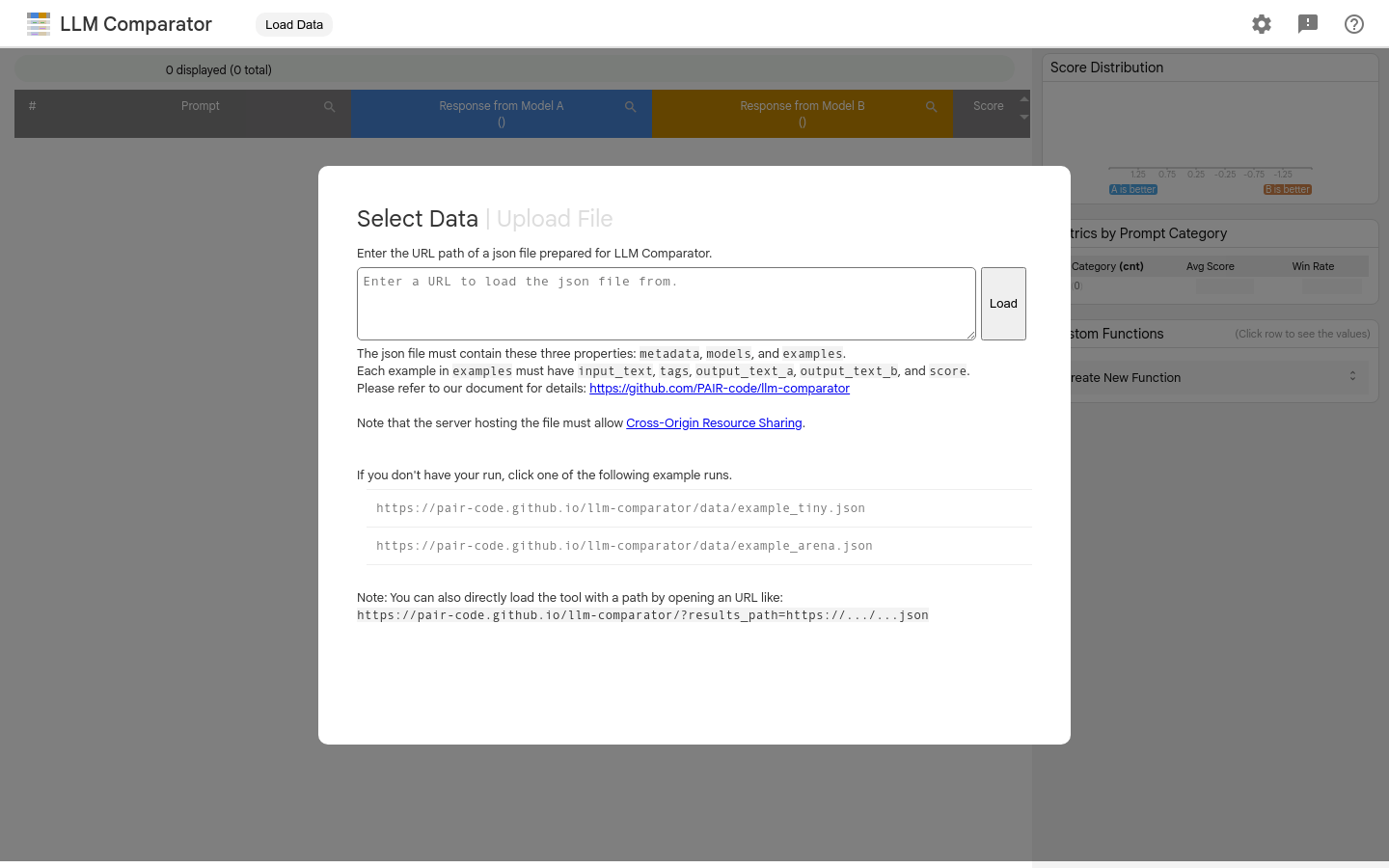

访问LLM Comparator的网站链接。

在界面中输入你想要比较的问题或提示。

选择你想要比较的语言模型。

提交问题,等待模型生成回答。

查看并比较不同模型的回答,分析它们的性能。

根据需要调整模型参数,进行进一步的比较。