使用场景

使用YaFSDP进行7B至70B参数规模的语言模型预训练。

在64至256个设备上应用YaFSDP进行模型训练,以提高效率。

利用YaFSDP进行2048至8192个token序列的模型训练。

产品特色

支持大规模语言模型的高效预训练。

优化了内存和通信操作,提高了训练效率。

提供了详细的使用示例,包括因果预训练和监督微调。

基于NVIDIA PyTorch图像构建,集成了必要的补丁库。

支持自定义事件通知,便于开发者根据需要接收更新。

在A100 80G集群上进行了性能评估,确保了框架的高性能。

使用教程

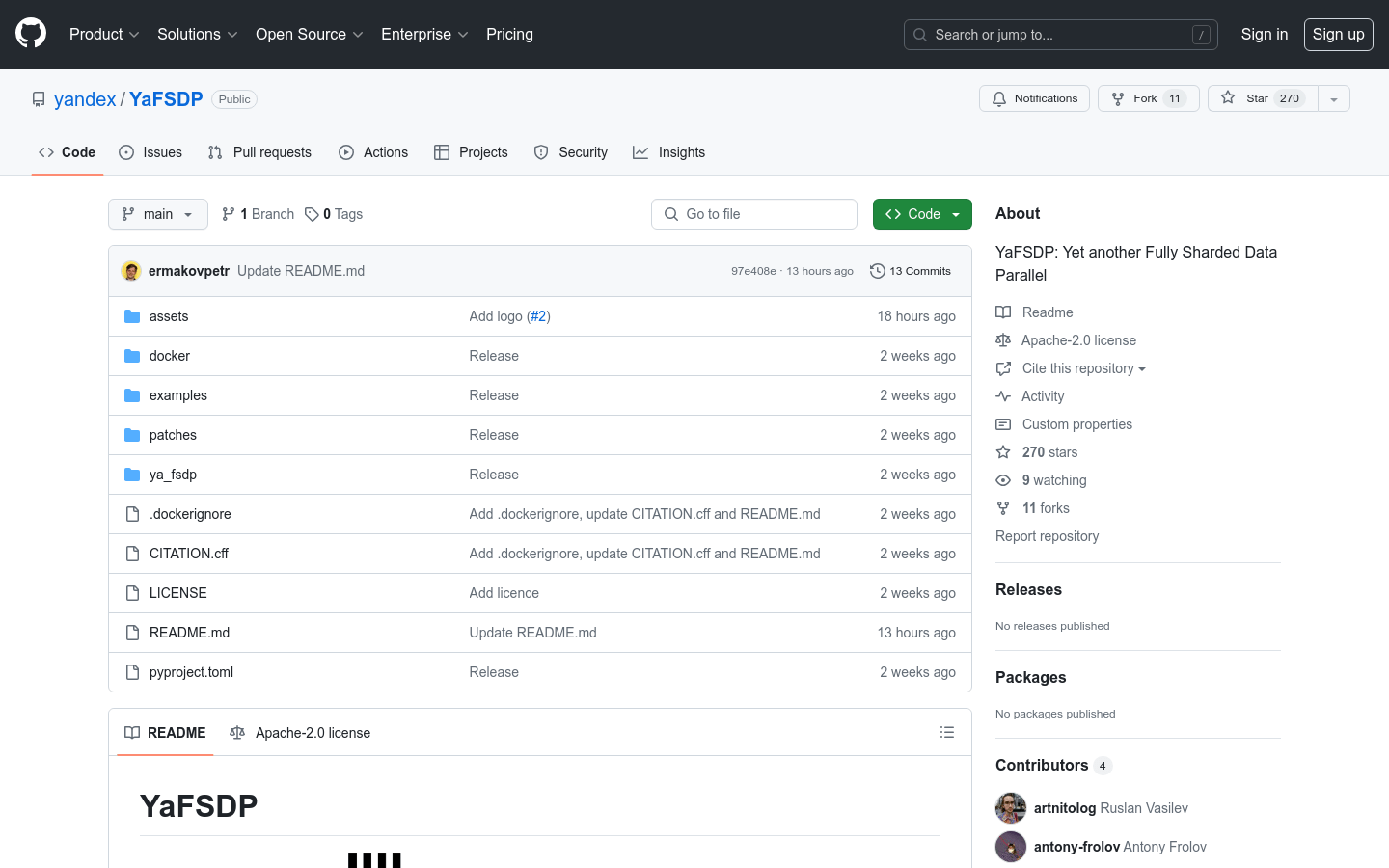

1. 克隆YaFSDP的GitHub仓库到本地环境。

2. 根据示例文件夹中的指导文档设置Docker环境。

3. 运行docker/build.sh脚本来构建所需的Docker镜像。

4. 根据具体的训练需求,选择合适的示例脚本进行模型训练。

5. 监控训练过程中的内存和通信开销,确保系统稳定运行。

6. 根据需要调整YaFSDP的配置参数,优化模型训练性能。