使用场景

研究人员使用该模型在自然语言理解任务中提高了模型的预测速度。

开发者利用模型进行代码生成,加快了开发流程。

教育机构采用该技术在教学中向学生展示语言模型的高级应用。

产品特色

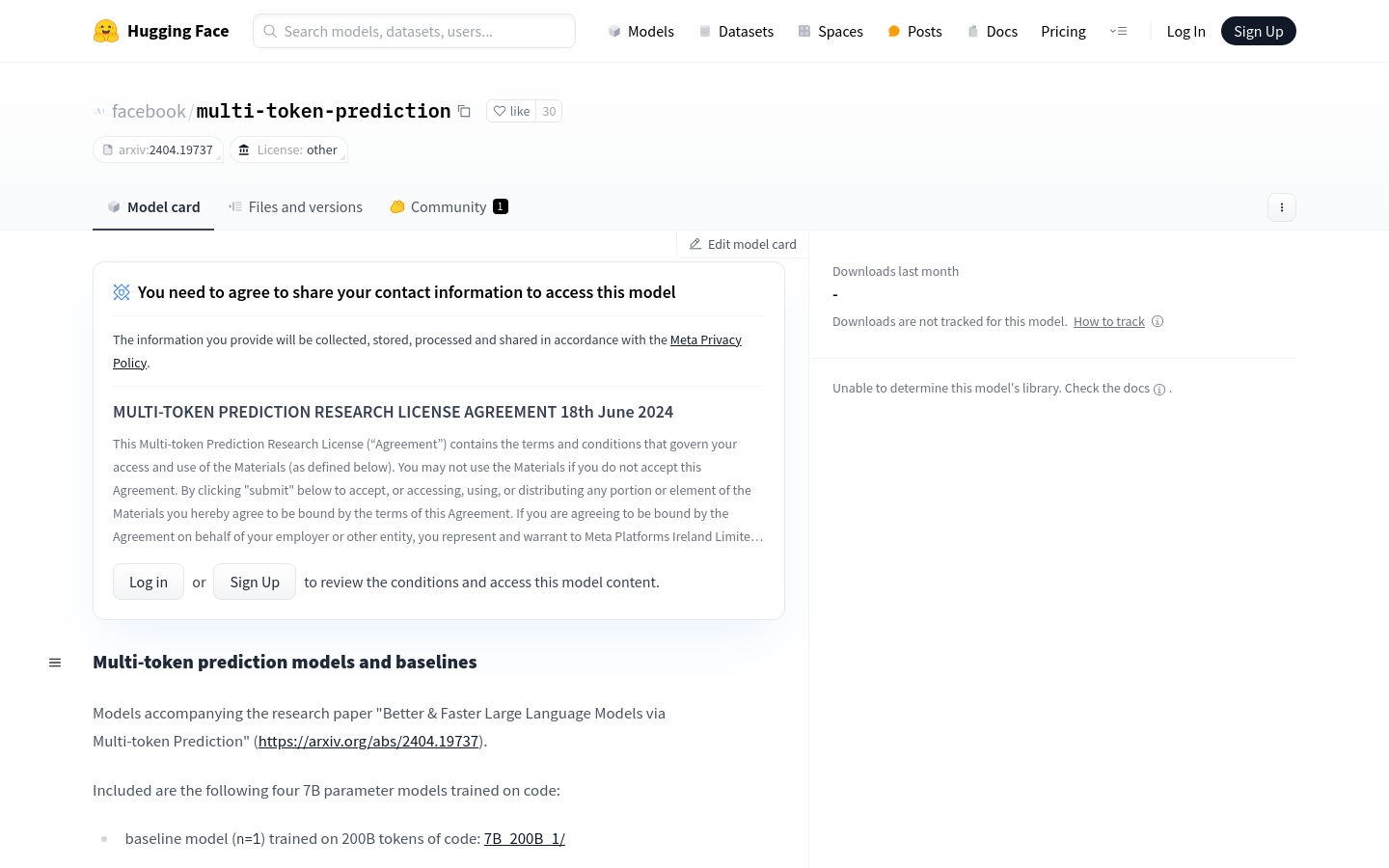

支持非商业研究用途的语言模型训练与推理

提供基于代码的7B参数模型,经过200B和1T tokens的训练

兼容Llama格式的Pytorch状态字典,方便模型部署与使用

支持额外预测头以忽略标准自回归推理

提供Tokenizer以处理模型输入

遵循LLaMA Acceptable Use Policy,确保材料的合理使用

使用教程

1. 安装必要的依赖库,包括torch, fairscale, fire和sentencepiece。

2. 下载并解压模型的checkpoint目录,例如7B_200B_4。

3. 使用Tokenizer对输入数据进行编码。

4. 加载模型并配置模型参数,准备进行推理或训练。

5. 根据需要设置forward()函数的return_all_heads参数,以决定是否返回所有预测头的输出。

6. 运行模型进行推理或训练,并根据输出结果进行后续处理。

7. 遵守Acceptable Use Policy,确保模型使用符合规定。