使用场景

使用LLM Compiler优化编译器生成的中间代码,减少最终程序的体积。

利用LLM Compiler的反编译功能,将汇编代码转换为LLVM IR,便于进一步分析和优化。

在开发过程中,通过LLM Compiler预测不同优化选项对代码大小的具体影响,选择最优的优化策略。

产品特色

预测LLVM优化对代码大小的影响

生成最小化代码大小的最佳优化序列

从x86_64或ARM汇编代码生成LLVM IR

在单个GPU上提供低延迟服务的7B参数模型

提供最佳结果的13B参数模型

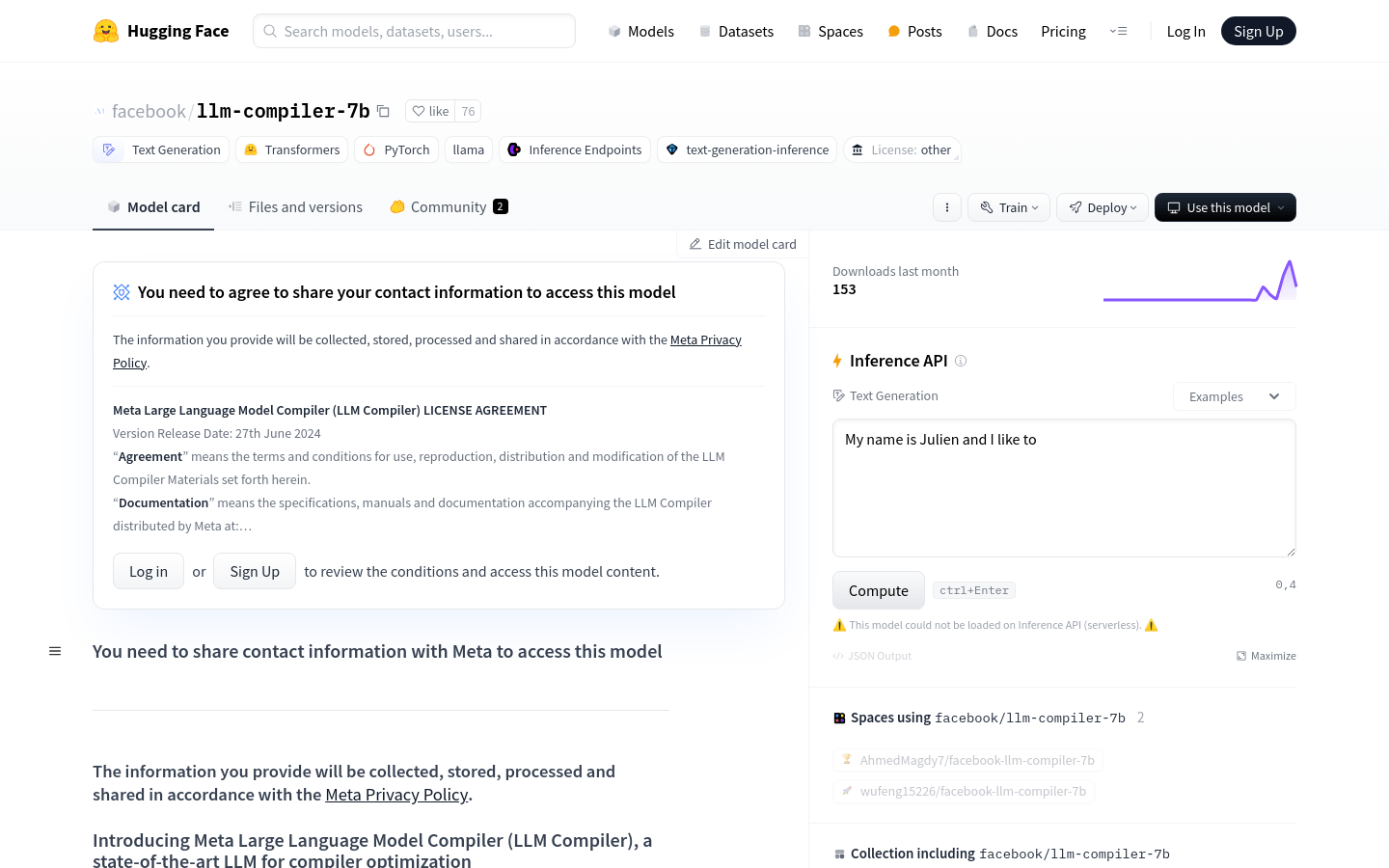

遵循Meta许可和可接受使用政策

使用教程

安装必要的库,如transformers。

导入AutoTokenizer和pipeline相关模块。

使用AutoTokenizer从预训练模型加载分词器。

设置pipeline参数,包括模型、设备映射和生成文本的参数。

调用pipeline生成文本,传入待优化的代码片段。

分析生成的文本,获取优化建议或转换后的代码。