使用场景

使用Gemma模型生成关于机器学习的诗歌

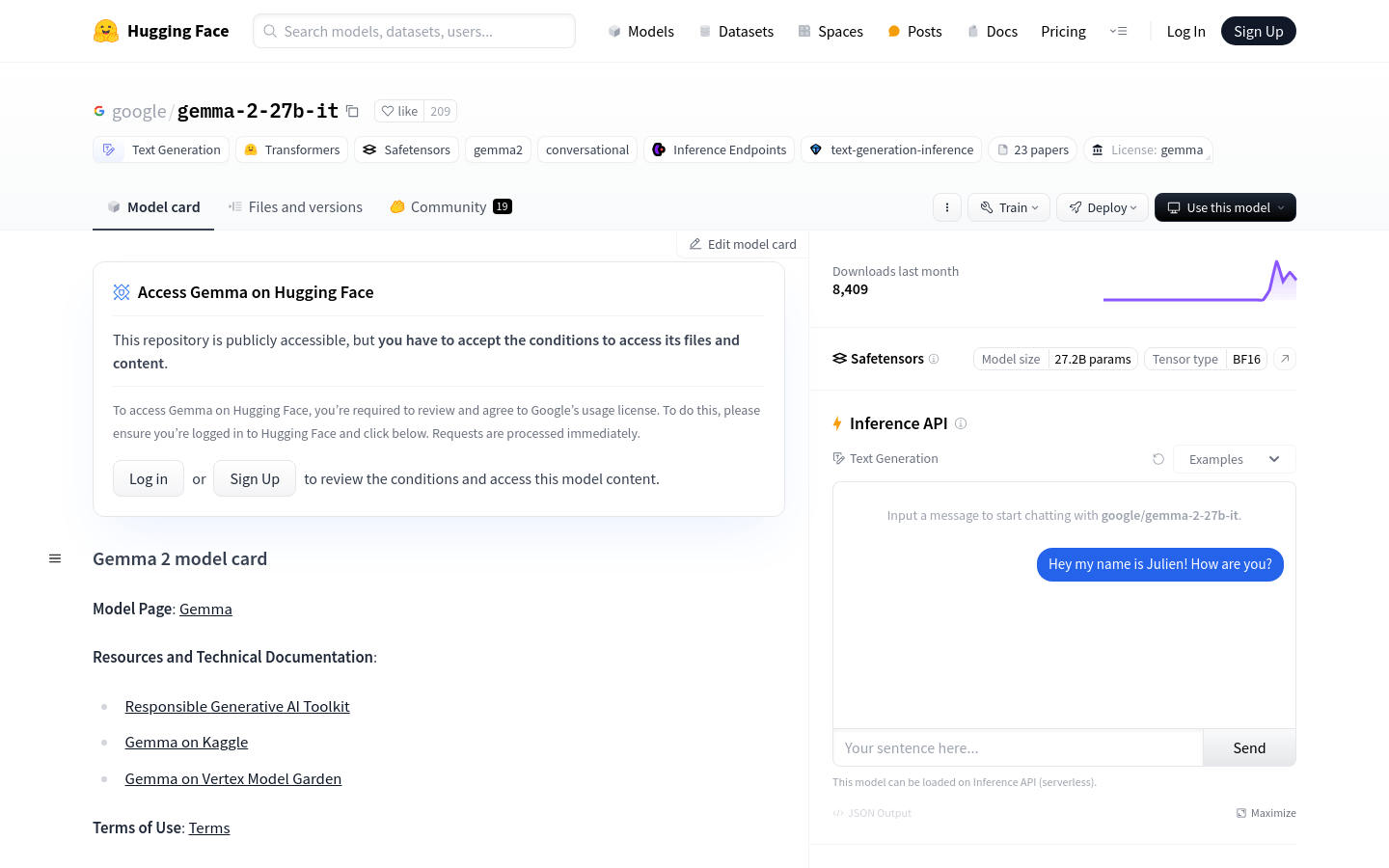

作为聊天机器人的后端,提供对话式的文本生成服务

在教育领域,辅助学生进行编程语言的学习或提供编程问题的解答

产品特色

支持多种文本生成任务,包括问答、摘要和推理

适用于资源有限的环境,如笔记本电脑和桌面

开放权重,适用于预训练变体和指令调整变体

支持在GPU上运行,且支持不同精度配置,包括bfloat16、float16和float32

提供了量化版本,通过bitsandbytes库支持8位和4位精度

支持使用Flash Attention 2优化模型的运行效率

使用教程

首先,确保安装了必要的库,如transformers和accelerate。

使用AutoTokenizer和AutoModelForCausalLM从transformers库导入模型和分词器。

根据需要设置模型的精度和设备映射。

定义输入文本并使用分词器将其转换为模型可接受的输入格式。

调用模型的generate方法生成文本输出。

使用tokenizer的decode方法将输出的token序列转换回可读文本。