使用场景

在自然语言处理任务中,使用FlashAttention加速BERT模型的训练。

在大规模文本生成任务中,利用FlashAttention减少GPT模型的内存占用。

在机器翻译或语音识别项目中,通过FlashAttention提高模型的运行效率。

产品特色

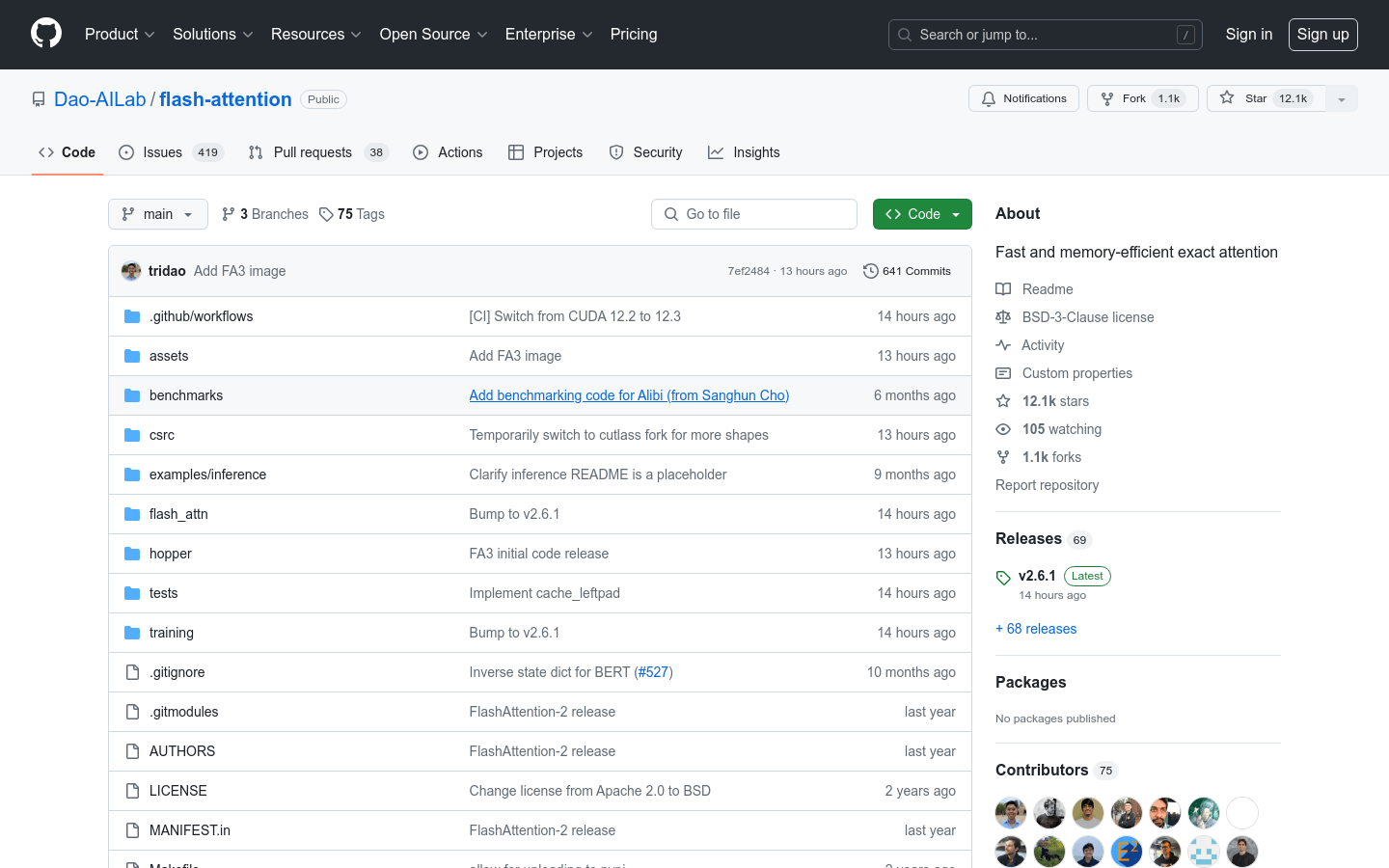

支持多种GPU架构,包括Ampere、Ada和Hopper。

提供数据类型fp16和bf16的支持,针对特定GPU架构优化。

实现了可扩展的头维度,最高支持256。

支持因果注意力和非因果注意力,适应不同的模型需求。

提供了简化的API接口,便于集成和使用。

支持滑动窗口局部注意力机制,适用于需要局部上下文信息的场景。

使用教程

1. 确保系统安装了CUDA 11.6及以上版本以及PyTorch 1.12及以上版本。

2. 克隆FlashAttention的代码库到本地环境。

3. 进入hopper目录,使用python setup.py install安装FlashAttention。

4. 设置PYTHONPATH环境变量,指向安装路径。

5. 使用pytest -q -s test_flash_attn.py运行测试,验证安装是否成功。

6. 在自己的项目中引入FlashAttention,按照API文档进行模型的集成和使用。