使用场景

使用MInference在单个A100 GPU上实现1M上下文的快速推理。

结合Hugging Face的模型和MInference进行高效的文本生成任务。

在ICML'24会议上展示MInference 1.0的性能和应用案例。

产品特色

动态稀疏注意力模式识别:通过分析确定每个注意力头属于的稀疏模式。

在线稀疏索引近似:动态计算注意力,使用最优的自定义内核。

支持多种解码型大型语言模型:包括LLaMA风格模型和Phi模型。

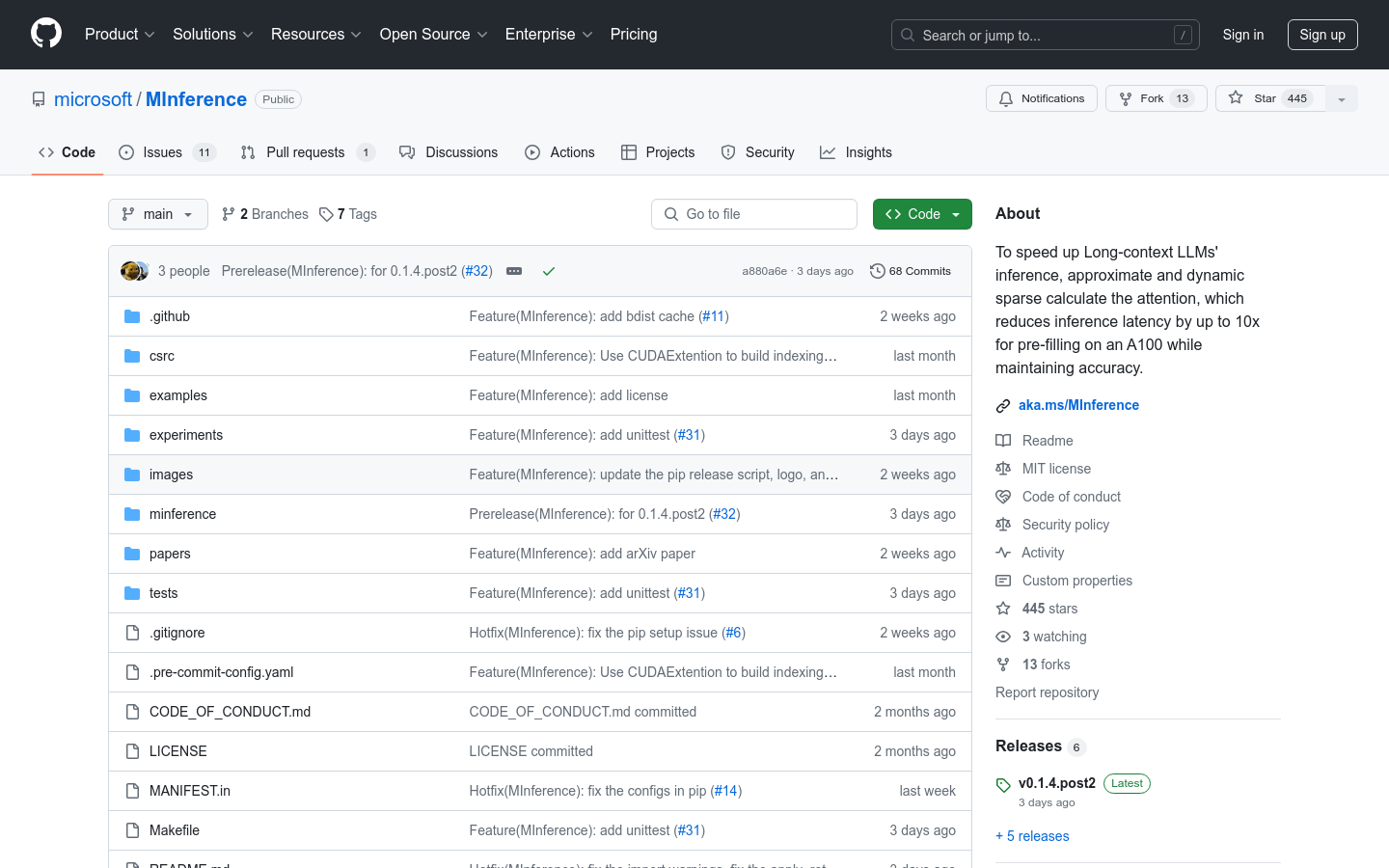

简化安装过程:通过pip命令快速安装MInference。

提供丰富的文档和示例:帮助用户快速上手和应用MInference。

持续更新和社区支持:适应更多模型,不断优化性能。

使用教程

1. 安装必要的依赖,包括Torch和FlashAttention-2。

2. 使用pip安装MInference。

3. 根据所使用的模型框架(如Hugging Face的transformers或vLLM),导入MInference模块并应用到模型上。

4. 通过MInference模块对模型进行patch,以利用动态稀疏注意力特性。

5. 运行推理任务,享受加速带来的性能提升。

6. 参考MInference提供的示例和实验,进一步探索和优化使用方式。