使用场景

用于生成高质量的多语言文本,如新闻文章、博客文章等

在编程领域,辅助生成代码或文档

在教育领域,辅助学生理解和生成自然语言文本

产品特色

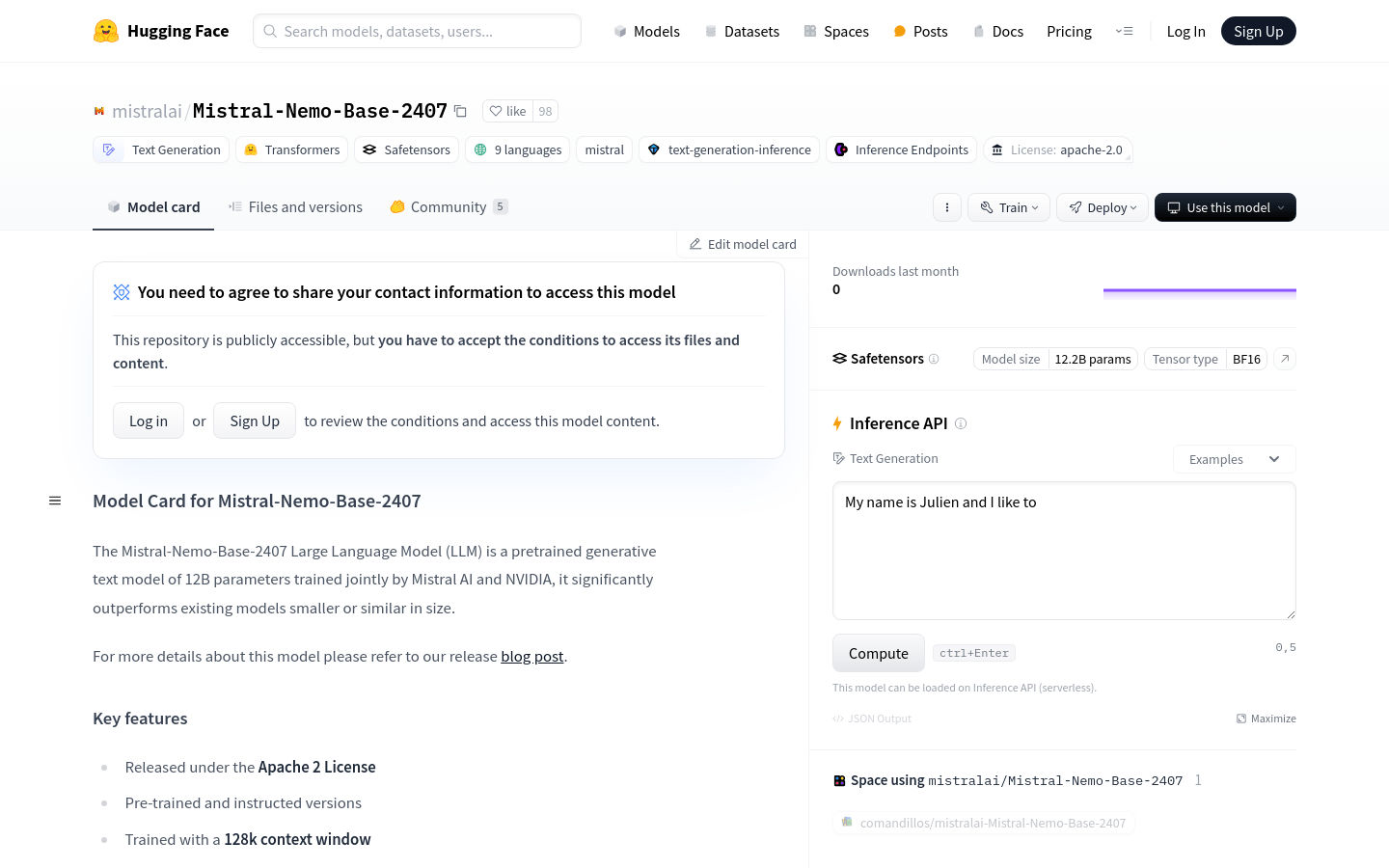

支持多种语言和代码数据的文本生成

128k上下文窗口训练,提升文本理解和生成能力

预训练和指令版本,满足不同应用需求

Apache 2.0许可证发布,使用灵活

模型架构包括40层、5120维、128头维,优化模型性能

在多个基准测试中表现出色,如HellaSwag、Winogrande等

支持多种框架使用,如mistral_inference、transformers、NeMo

使用教程

1. 安装mistral_inference:推荐使用mistralai/Mistral-Nemo-Base-2407与mistral-inference。

2. 下载模型:使用Hugging Face Hub的snapshot_download函数下载模型文件。

3. 安装transformers:如果需要使用Hugging Face transformers生成文本,需要从源代码安装transformers。

4. 使用模型:通过AutoModelForCausalLM和AutoTokenizer加载模型和分词器,输入文本并生成输出。

5. 调整参数:与之前的Mistral模型不同,Mistral Nemo需要较小的温度,推荐使用0.3。

6. 运行演示:安装mistral_inference后,环境中应可用mistral-demo CLI命令。