使用场景

研究人员使用 Meta Llama 3 进行语言模型的学术研究,探索其在语言理解、生成等方面的能力。

开发者利用 Meta Llama 3 为聊天应用提供智能对话功能,提升用户体验。

企业通过 Meta Llama 3 进行文本分析,辅助决策制定和市场预测。

产品特色

支持从8B到70B参数规模的多种预训练模型

提供指令调优功能,提升模型在特定任务上的表现

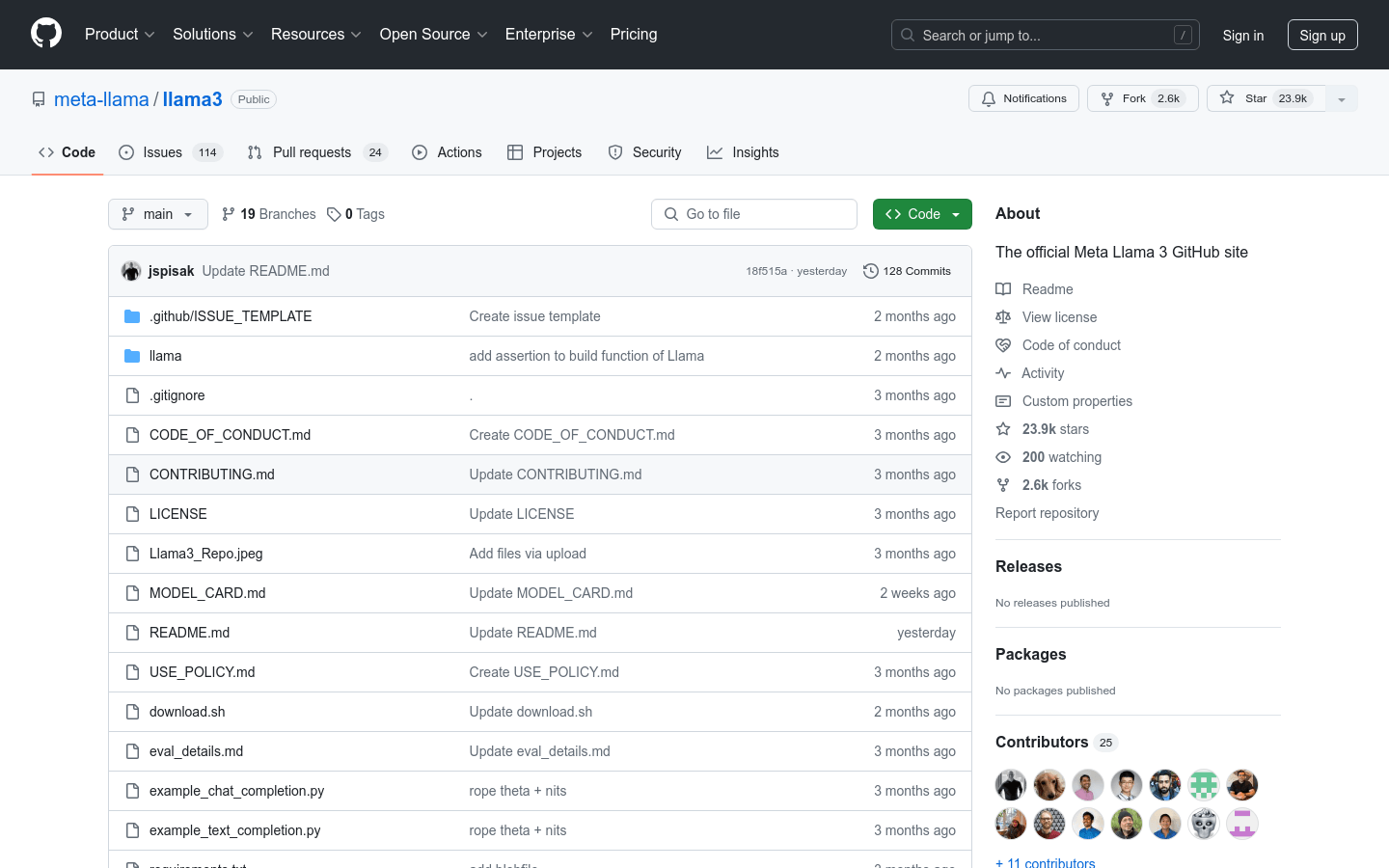

通过 GitHub 仓库提供模型代码和权重下载

支持本地推理,用户可以在自己的设备上运行模型

提供详细的使用指南和示例代码,方便用户快速上手

模型支持模型并行(MP)技术,适应不同硬件配置

模型支持序列长度高达8192个token,满足复杂任务需求

使用教程

1. 访问 Meta Llama 3 的 GitHub 仓库并克隆到本地环境。

2. 在克隆的仓库中运行 `pip install -e .` 安装所需的依赖。

3. 访问 Meta Llama 网站并注册以下载模型。

4. 收到下载链接的邮件后,运行 `download.sh` 脚本并输入邮件中的 URL 下载模型权重和分词器。

5. 确保下载的模型权重和分词器文件路径正确,运行示例代码进行本地推理。

6. 根据需要调整模型并行(MP)值、序列长度和批处理大小等参数,以适应不同的硬件配置和任务需求。

7. 通过阅读仓库中的文档和示例代码,进一步了解模型的使用和优化方法。