使用场景

研究人员使用lmms-finetune对LLaVA-1.5进行微调,以提高在特定视频内容分析任务上的性能。

开发者利用该代码库将Phi-3-Vision模型微调到新的图像识别任务中。

教育机构采用lmms-finetune进行教学,帮助学生理解大型多模态模型的微调过程和应用。

产品特色

提供统一结构的微调框架,简化集成和微调过程

支持全微调、lora、q-lora等多种微调策略

保持代码库的简洁性,便于理解和修改

支持多种类型的LMMs,包括单图像模型、多图像/交错图像模型和视频模型

提供详细的文档和示例,帮助用户快速上手

灵活的代码库,支持自定义和快速实验

使用教程

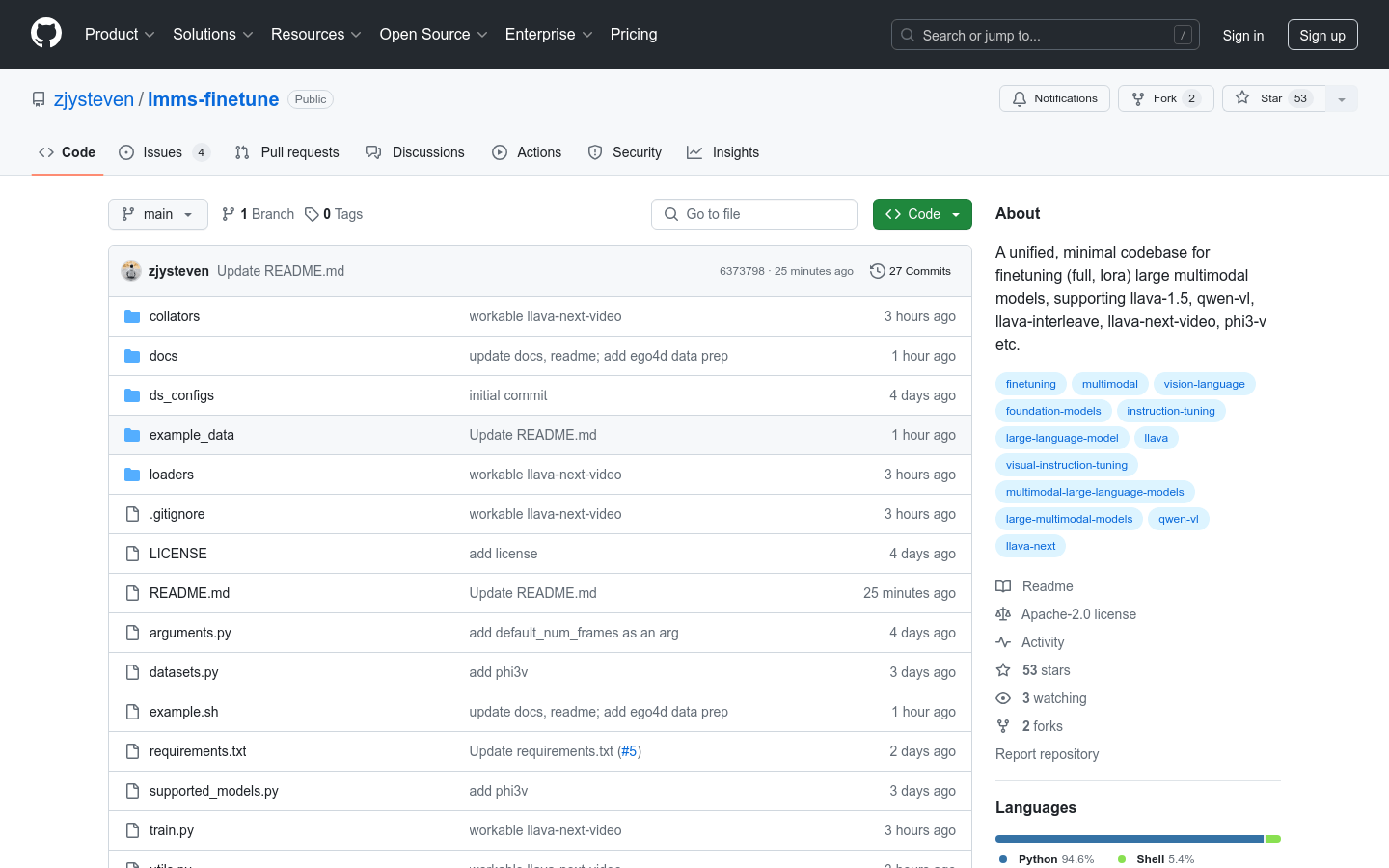

克隆代码库到本地环境:`git clone https://github.com/zjysteven/lmms-finetune.git`

设置conda环境并激活:`conda create -n lmms-finetune python=3.10 -y` 后 `conda activate lmms-finetune`

安装依赖:`python -m pip install -r requirements.txt`

根据需要安装额外的库,如flash attention:`python -m pip install --no-cache-dir --no-build-isolation flash-attn`

查看支持的模型列表或运行 `python supported_models.py` 来获取支持的模型信息

根据示例或文档修改训练脚本 `example.sh`,设置目标模型、数据路径等参数

运行训练脚本:`bash example.sh` 开始微调过程