使用场景

电影制作中使用EmoTalk3D生成具有情感表达的3D角色。

游戏开发者利用EmoTalk3D创建具有丰富表情的虚拟角色。

虚拟助手通过EmoTalk3D技术提供更自然的人机交互体验。

产品特色

情感内容分离编码器,解析输入语音中的内容和情感特征。

语音到几何网络(S2GNet),预测动态3D点云。

高斯优化和完成模块,建立标准外观。

几何到外观网络(G2ANet),基于动态3D点云合成面部外观。

渲染模块,将动态高斯渲染成自由视角动画。

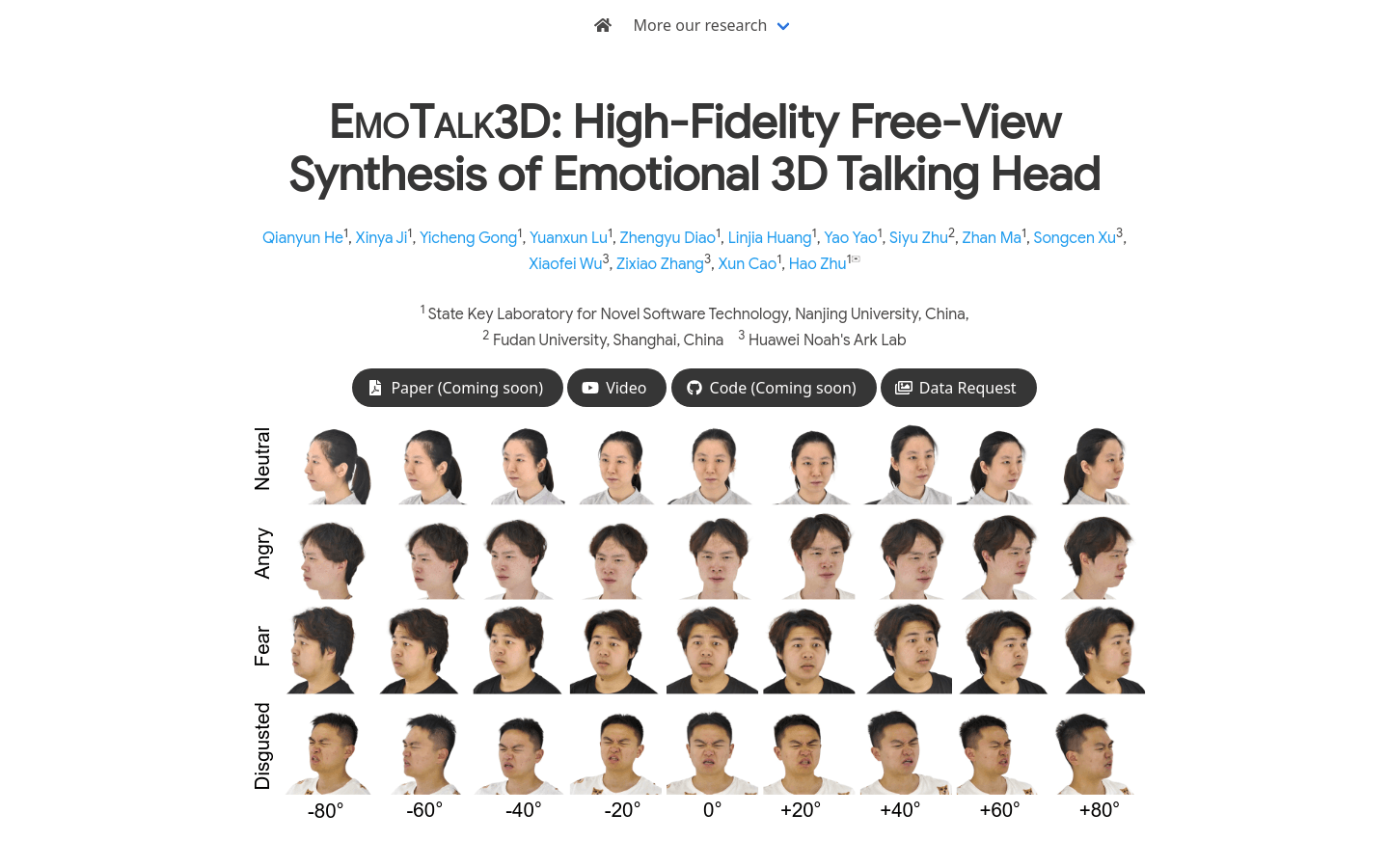

数据集EmoTalk3D,提供情感注释的多视角人头数据。

使用教程

1. 访问EmoTalk3D项目页面,了解项目背景和技术细节。

2. 下载并安装必要的软件和库,以运行EmoTalk3D模型。

3. 准备或获取音频输入,确保音频包含所需的情感表达。

4. 使用EmoTalk3D模型处理音频输入,生成3D几何序列。

5. 根据生成的3D几何数据,通过G2ANet合成面部外观。

6. 利用渲染模块将合成的外观渲染成动态的3D动画。

7. 根据需要调整模型参数,优化渲染效果和情感表达。