使用场景

开发者使用ComfyUI-GGUF在低端GPU上部署flux模型,实现资源优化。

研究人员利用GGUF量化技术,提升了模型在边缘设备上的性能。

教育机构在教授深度学习时,使用ComfyUI-GGUF作为案例,教授模型优化技巧。

产品特色

支持GGUF格式模型文件的量化

适用于transformer/DiT模型,如flux

允许在低端GPU上运行,优化资源使用

提供了自定义节点以支持模型量化

不包括LoRA / Controlnet等支持,因为权重已被量化

提供了安装和使用指南

使用教程

1. 确保ComfyUI版本支持自定义操作。

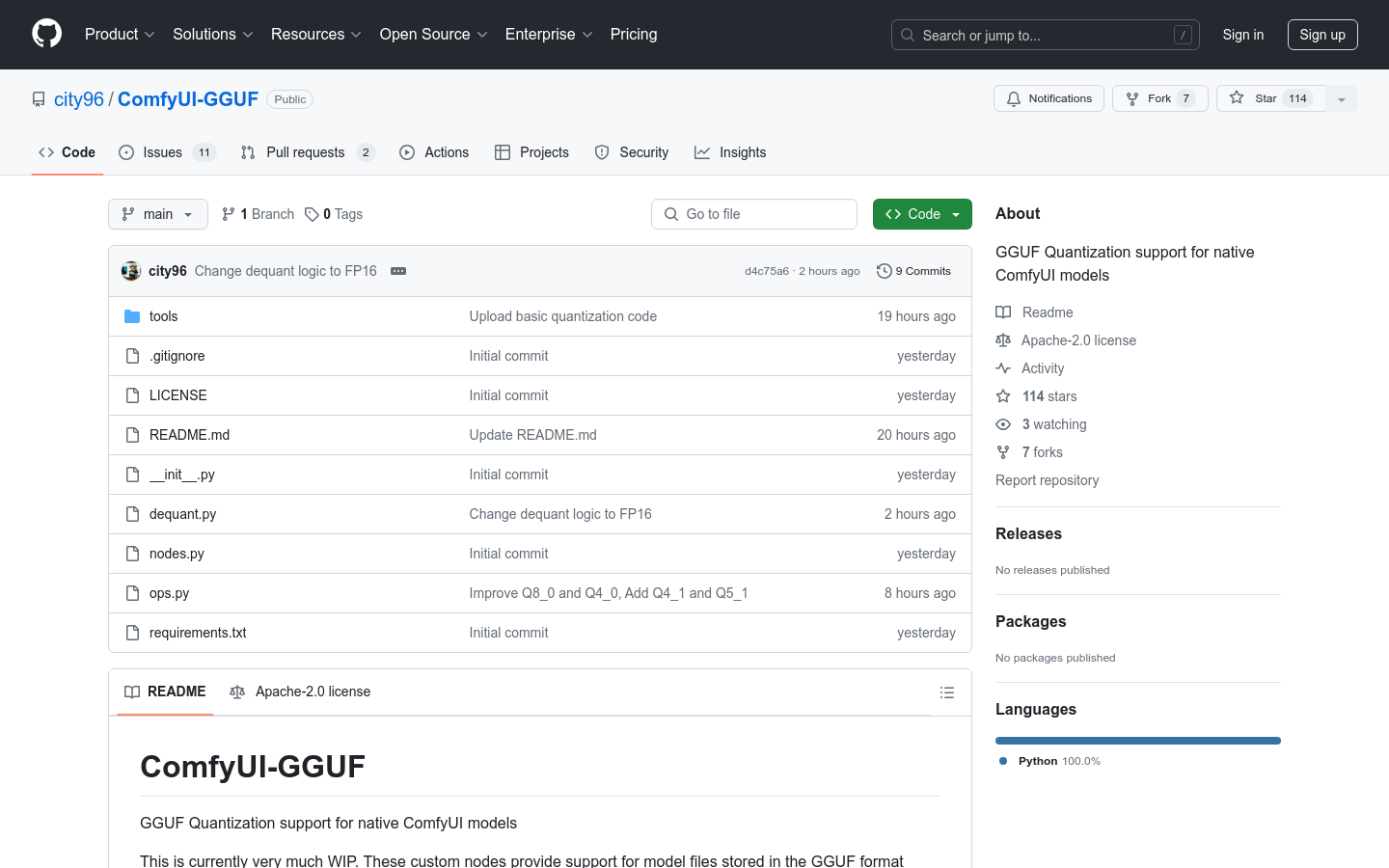

2. 使用git克隆ComfyUI-GGUF仓库。

3. 安装推理所需的依赖项(pip install --upgrade gguf)。

4. 将.gguf模型文件放置在ComfyUI/models/unet文件夹中。

5. 使用GGUF Unet加载器,该加载器位于bootleg类别下。

6. 根据需要调整模型参数和设置,进行模型训练或推理。