使用场景

在 Video-MME 基准测试中,Video-CCAM-14B 在 96 帧情况下的无字幕和有字幕成绩分别为 53.2 和 57.4。

Video-CCAM 在 VideoVista 上的评估中排名第二和第三,显示出其在开源 MLLMs 中的竞争力。

在 MVBench 上,使用 16 帧的 Video-CCAM-4B 和 Video-CCAM-9B 分别取得了 57.78 和 60.70 的成绩。

产品特色

在多个视频理解基准测试中具有优异的性能表现

支持短视频和长视频的分析

使用因果交叉注意力掩码技术提升视频-语言理解能力

源代码重写,简化部署过程

支持 Huggingface transformers 进行 NVIDIA GPU 上的推理

提供详细的教程和示例,便于学习和应用

使用教程

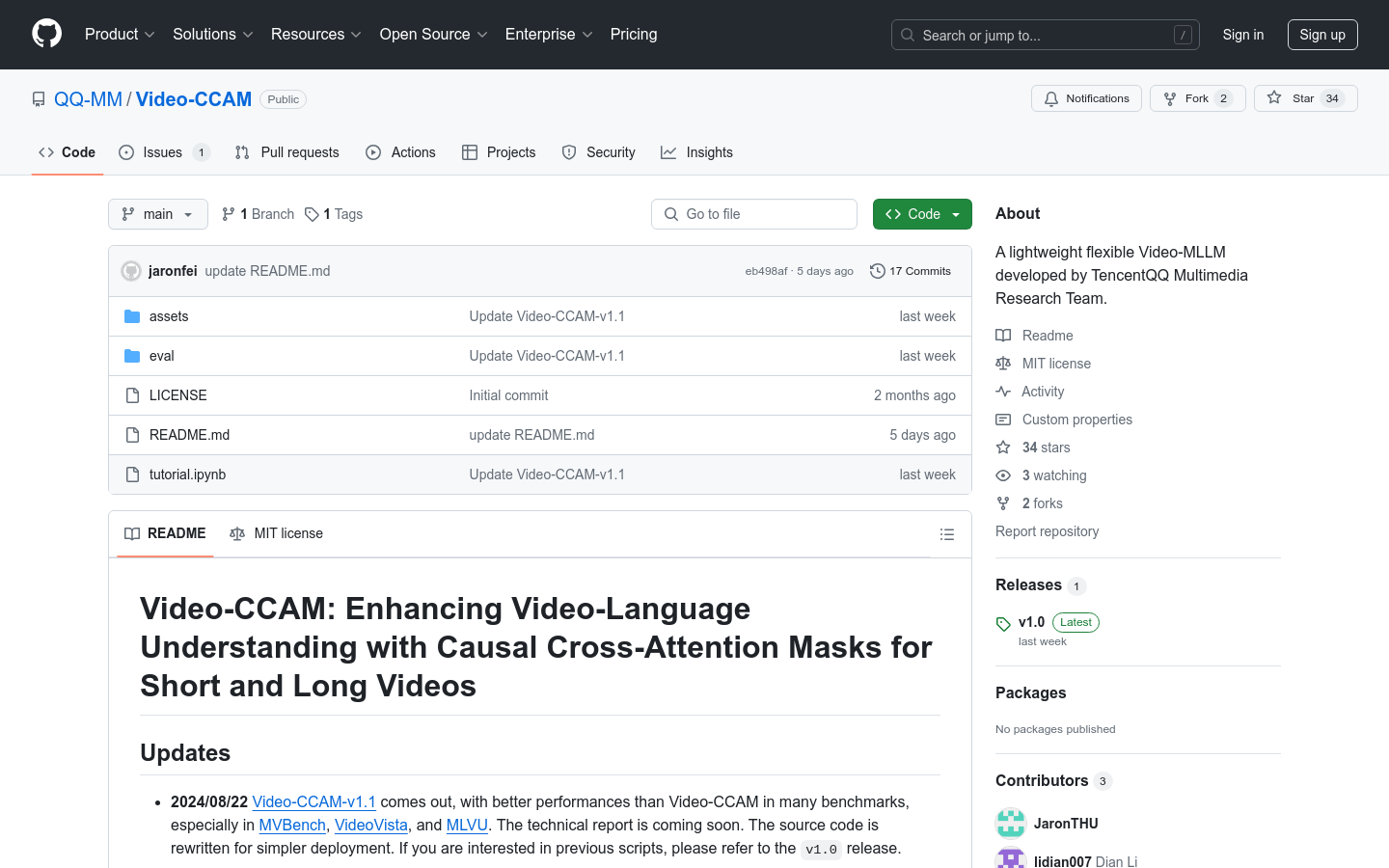

1. 访问 GitHub 仓库页面,了解 Video-CCAM 的基本信息和功能。

2. 阅读 README.md 文件,获取模型的安装和使用说明。

3. 根据 tutorial.ipynb 提供的教程,学习如何在 NVIDIA GPU 上使用 Huggingface transformers 进行模型推理。

4. 下载或克隆源代码,根据需要进行本地部署和测试。

5. 利用模型进行视频内容的分析和理解,根据实际需求调整参数和配置。

6. 参与社区讨论,获取技术支持和最佳实践。