使用场景

使用 DeepSeek-V2.5 生成快速排序算法的 C++ 代码

利用模型调用外部天气API获取特定城市的天气信息

在对话中询问模型问题,并获取结构化的 JSON 格式回答

产品特色

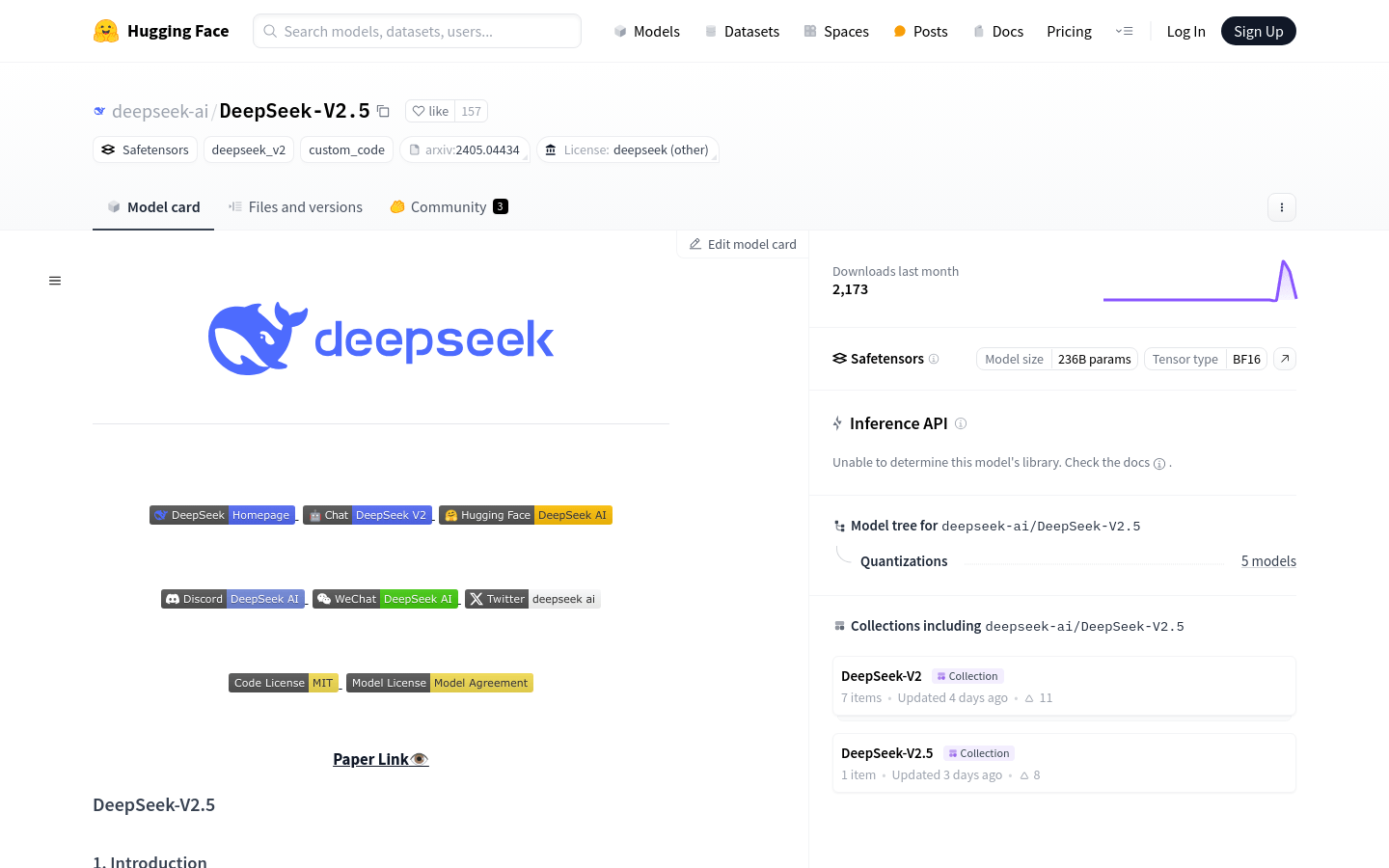

支持使用 Huggingface 的 Transformers 进行模型推理

推荐使用 vLLM 进行模型推理,以获得更好的性能

支持函数调用,模型可以调用外部工具增强其能力

支持 JSON 输出模式,确保生成有效的 JSON 对象

支持 FIM (Fill In the Middle) 补全,提供前缀和后缀,模型完成中间内容

使用教程

首先,确保你的环境中安装了 Huggingface 的 Transformers 库

导入必要的模块,如 torch、AutoTokenizer 和 AutoModelForCausalLM

使用 AutoTokenizer.from_pretrained 方法加载 DeepSeek-V2.5 模型

设置模型的生成配置,如最大新令牌数、停止令牌ID等

准备输入消息,使用 tokenizer 将消息转换为模型可理解的格式

调用模型的 generate 方法生成响应

将生成的响应解码成可读的文本格式