使用场景

视觉问题回答(VQA):用户可以上传图片并询问有关图像的问题,模型会给出答案。

文档视觉问题回答(DocVQA):模型可以理解文档的文本和布局,然后回答有关图像的问题。

图像描述:为社交媒体上的图片自动生成描述性文字。

图像-文本检索:帮助用户找到与他们上传的图片内容相匹配的文本描述。

产品特色

视觉识别:优化模型以识别图像中的对象和场景。

图像推理:使模型能够理解图像内容并进行逻辑推理。

图像描述:生成描述图像内容的文本。

回答有关图像的问题:理解图像并回答用户基于图像的问题。

支持多语言:虽然图像+文本应用仅支持英文,但模型在文本任务上支持英语、德语、法语、意大利语、葡萄牙语、印地语、西班牙语和泰语。

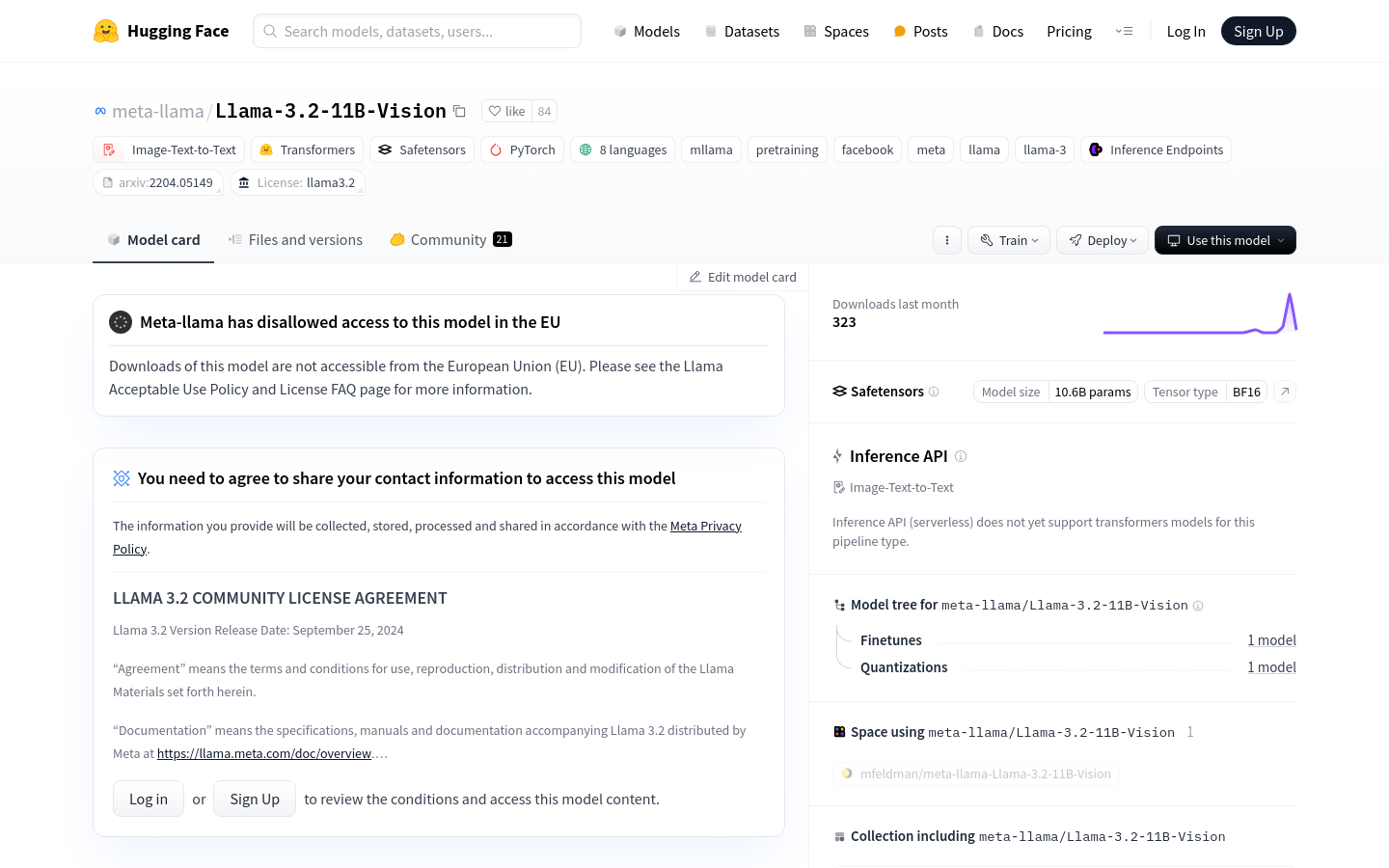

遵守社区许可协议:使用 Llama 3.2 社区许可协议进行规范。

负责任的部署:遵循 Meta 的最佳实践,确保模型的安全和有用性。

使用教程

1. 安装 transformers 库:确保已安装 transformers 库并更新到最新版本。

2. 加载模型:使用 transformers 库中的 MllamaForConditionalGeneration 和 AutoProcessor 类加载模型和处理器。

3. 准备输入:将图像和文本提示组合成模型可接受的输入格式。

4. 生成文本:调用模型的 generate 方法生成基于输入图像和提示的文本。

5. 输出处理:将生成的文本解码并展示给用户。

6. 遵守许可协议:在使用模型时,确保遵守 Llama 3.2 社区许可协议中的条款。