使用场景

开发者使用WebLLM快速测试和部署自定义语言模型。

数据科学家利用WebLLM在浏览器中进行语言模型的实验和研究。

AI爱好者使用WebLLM构建个性化的聊天机器人和虚拟助手。

产品特色

浏览器内推理:利用WebGPU进行硬件加速,实现浏览器内的语言模型操作。

OpenAI API兼容:无缝集成应用,支持JSON模式、函数调用、流式处理等。

模型支持:原生支持Llama、Phi、Gemma、RedPajama、Mistral、Qwen等模型。

自定义模型集成:支持MLC格式的自定义模型,提高模型部署的灵活性。

即插即用集成:通过NPM、Yarn或CDN轻松集成,提供全面示例和模块化设计。

流式处理和实时交互:支持流式聊天完成,增强聊天机器人和虚拟助手等交互应用。

Web Worker和Service Worker支持:通过将计算任务卸载到单独的工作线程或服务工作线程,优化UI性能和管理模型生命周期。

Chrome扩展支持:使用WebLLM构建基本和高级Chrome扩展,提供构建示例。

使用教程

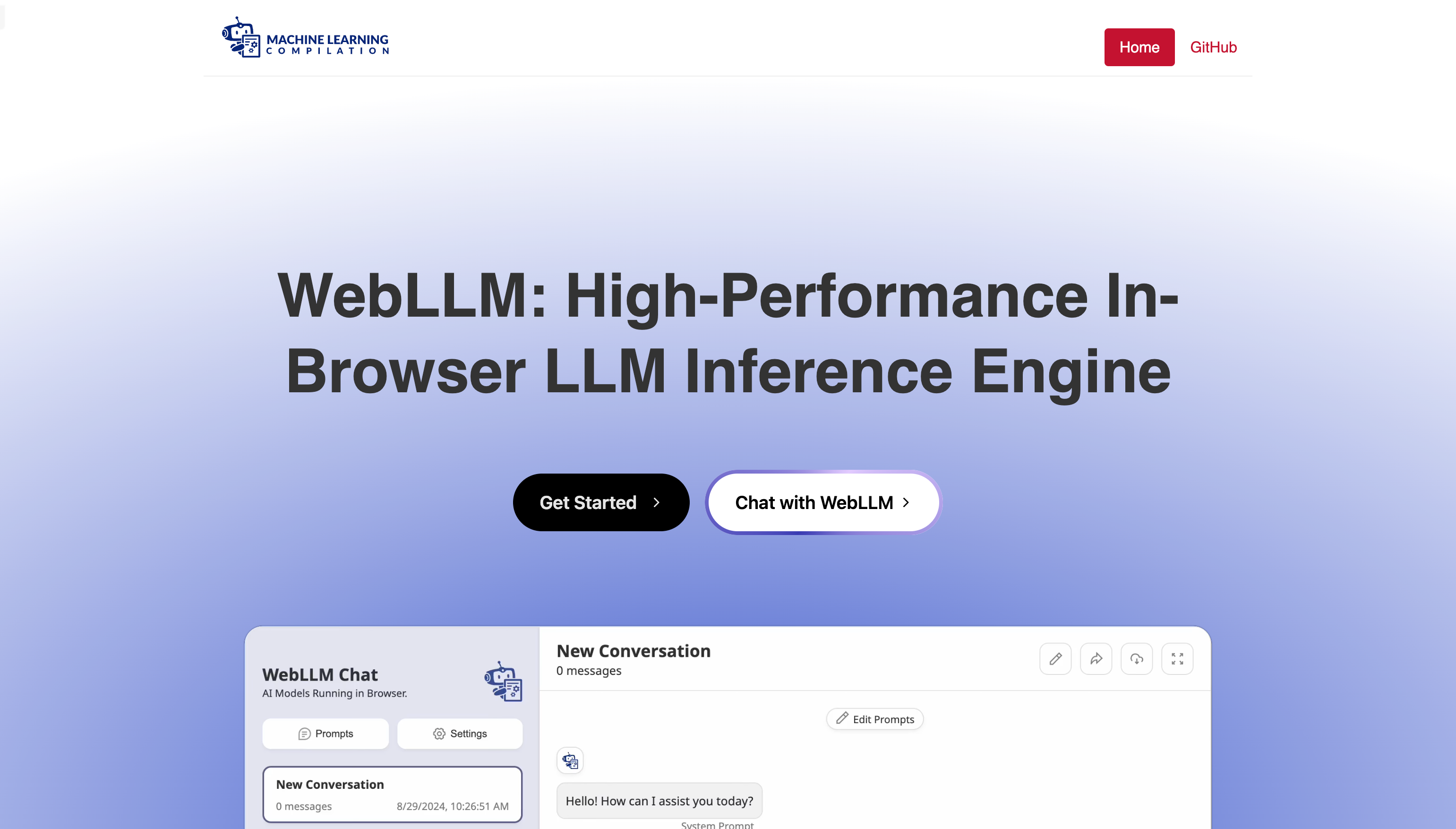

访问WebLLM官网:https://webllm.mlc.ai/。

阅读文档,了解如何集成WebLLM到你的项目中。

选择合适的语言模型进行集成。

使用NPM、Yarn或CDN将WebLLM添加到你的项目。

根据文档示例,编写代码以实现所需的AI功能。

测试和调整模型以满足特定需求。

部署到浏览器,开始使用WebLLM进行语言模型推理。