使用场景

音乐制作人利用UniMuMo根据文本描述生成音乐和舞蹈动作。

视频游戏开发者使用UniMuMo为游戏中的NPC生成同步的音乐和动作。

虚拟现实内容创作者使用UniMuMo为虚拟角色生成自然的动作和音乐反应。

产品特色

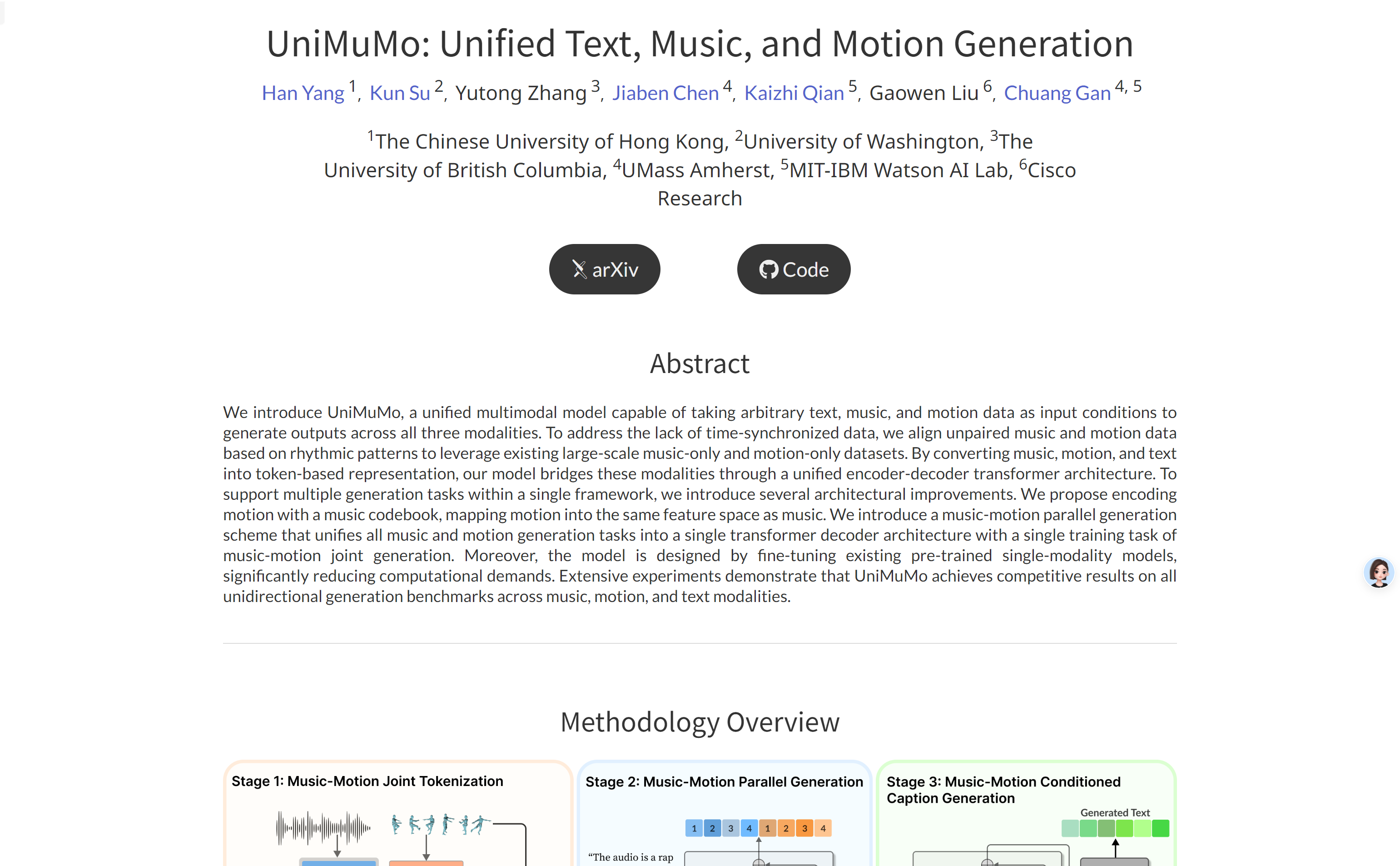

支持文本、音乐和动作数据的输入条件,生成跨模态的输出。

通过节奏模式对未配对的音乐和动作数据进行对齐,利用现有的大规模音乐和动作数据集。

采用统一的编码器-解码器转换器架构,将音乐、动作和文本桥接。

提出了音乐运动并行生成方案,将所有音乐和动作生成任务统一到单一的转换器解码器架构中。

通过微调现有的预训练单模态模型来设计模型,显著降低了计算需求。

在音乐、动作和文本模态的所有单向生成基准测试中都取得了有竞争力的结果。

使用教程

访问UniMuMo的在线演示页面。

阅读页面上的介绍,了解模型的功能和背景。

根据需要选择输入模态,如文本、音乐或动作。

输入具体的文本描述、音乐片段或动作数据。

提交输入数据,等待模型生成跨模态的输出。

查看生成的结果,如音乐、动作或文本描述。

根据需要调整输入数据或参数,重复生成过程以获得更满意的结果。