使用场景

研究人员使用该项目来测试和分析不同语言模型在特定任务上的表现。

开发者利用该项目的代码和工具来构建和评估自己的语言模型。

教育机构可能使用这个项目作为教学案例,帮助学生理解语言模型评估的复杂性。

产品特色

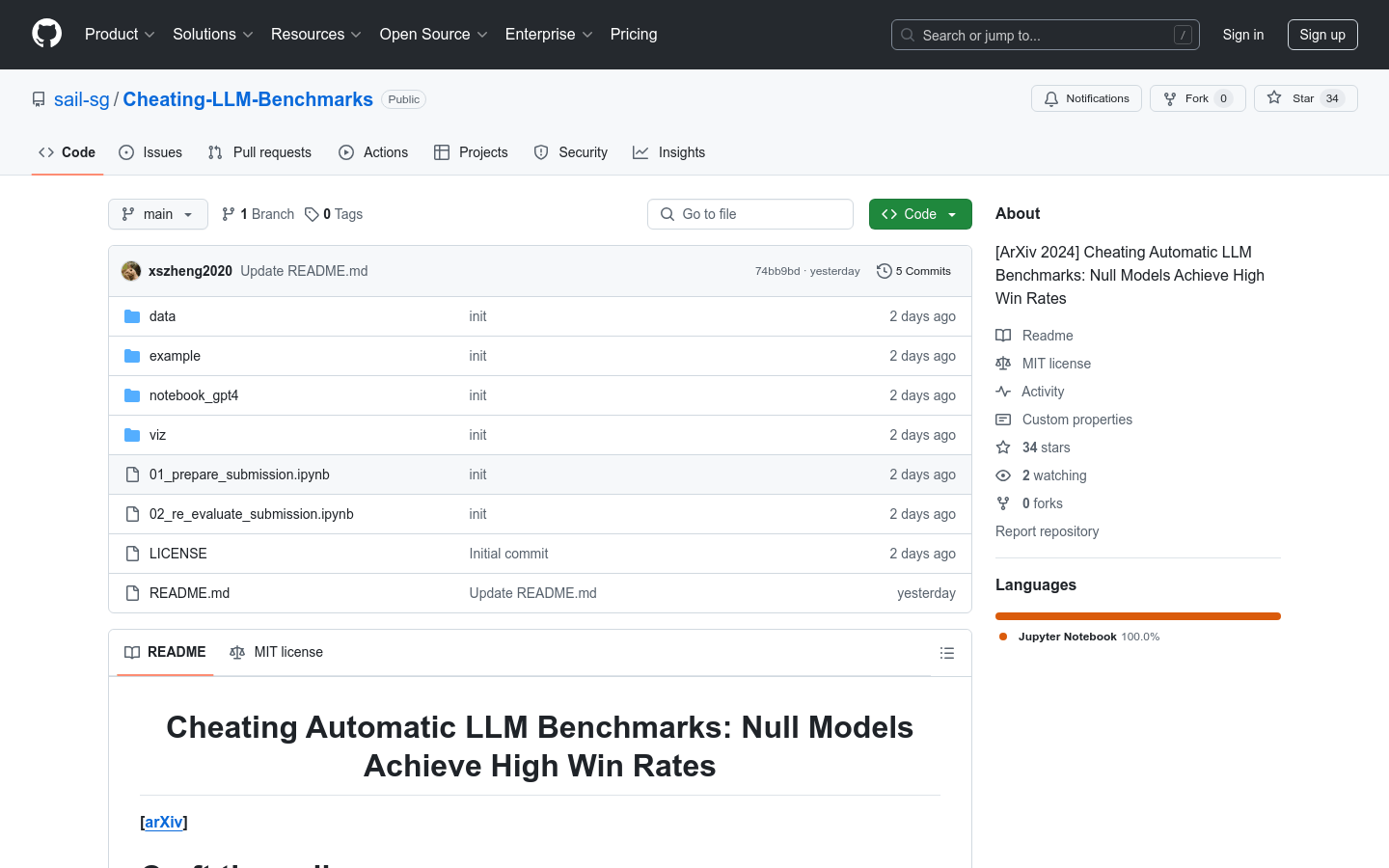

构建零模型以参与语言模型基准测试。

通过Jupyter Notebook提供实验步骤和代码。

使用AlpacaEval工具来评估模型输出。

计算并分析模型的胜率和标准误差。

提供详细的实验结果和分析数据。

支持对实验结果进行进一步的重新评估和分析。

使用教程

1. 访问项目GitHub页面并克隆或下载项目代码。

2. 安装必要的依赖项,如Jupyter Notebook和AlpacaEval。

3. 运行项目中的Jupyter Notebook文件,如'01_prepare_submission.ipynb',以构建零模型提交。

4. 使用AlpacaEval工具评估模型输出,按照项目中的指南设置环境变量并运行评估命令。

5. (可选)运行'02_re_evaluate_submission.ipynb'进行进一步的分析,计算胜率等统计数据。

6. 查看项目中的'README.md'和'LICENSE'文件,了解更多关于项目的使用和许可信息。