使用场景

在对话系统中的应用,生成流畅自然的对话回复

作为文本生成任务的基础模型,用于生成文章、故事等内容

在教育领域,用于生成教学材料或辅助学生学习写作

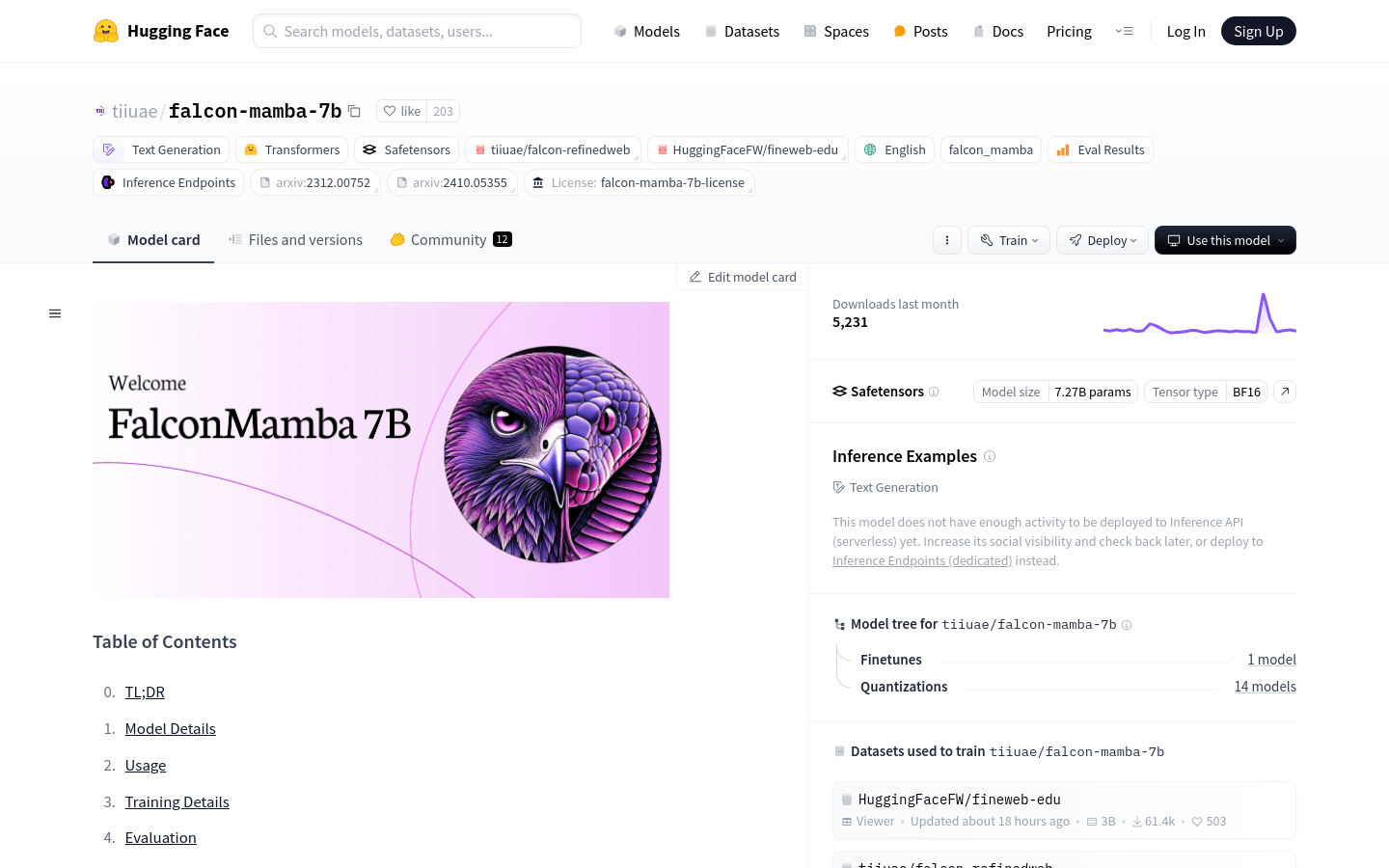

产品特色

支持在CPU和GPU上运行,包括使用torch.compile进行优化

支持多种精度设置,包括FP16和4-bit量化,以适应不同的性能和资源需求

基于Mamba架构,无长距离依赖限制,适用于处理长文本

在多个语言模型基准测试中表现优异,包括IFEval、BBH、MATH LvL5等

支持使用transformers库轻松集成到Python项目中

模型训练使用了3D并行策略和ZeRO优化技术,提高了训练效率和扩展性

提供了详细的模型卡片和使用说明,方便用户快速上手和部署

使用教程

1. 安装transformers库:使用pip install transformers命令安装

2. 导入模型和分词器:在Python代码中导入AutoTokenizer和AutoModelForCausalLM

3. 加载预训练模型:使用from_pretrained方法加载tiiuae/falcon-mamba-7b模型

4. 准备输入文本:定义需要模型生成文本的输入

5. 编码输入文本:使用分词器将输入文本转换为模型可以理解的格式

6. 生成文本:调用模型的generate方法生成文本

7. 解码生成的文本:使用分词器将生成的文本转换回可读的文本格式

8. 打印或使用生成的文本:将生成的文本用于后续的应用或研究