使用场景

使用vLLM库实现生产就绪的推理管道

在服务器/客户端设置中使用Ministral-8B进行聊天或问答

使用mistral-inference快速尝试或“感受”模型的性能

处理超过100k令牌的passkey检测任务

产品特色

支持128k上下文窗口和交错滑动窗口注意力机制

在多语言和代码数据上进行训练

支持函数调用

词汇量达到131k

在知识与常识、代码与数学以及多语言支持等方面的基准测试中表现优异

适用于聊天/竞技场(gpt-4o判断)中的复杂对话和任务处理

使用教程

1. 安装vLLM库和mistral_common库

2. 使用pip命令进行安装:`pip install --upgrade vllm` 和 `pip install --upgrade mistral_common`

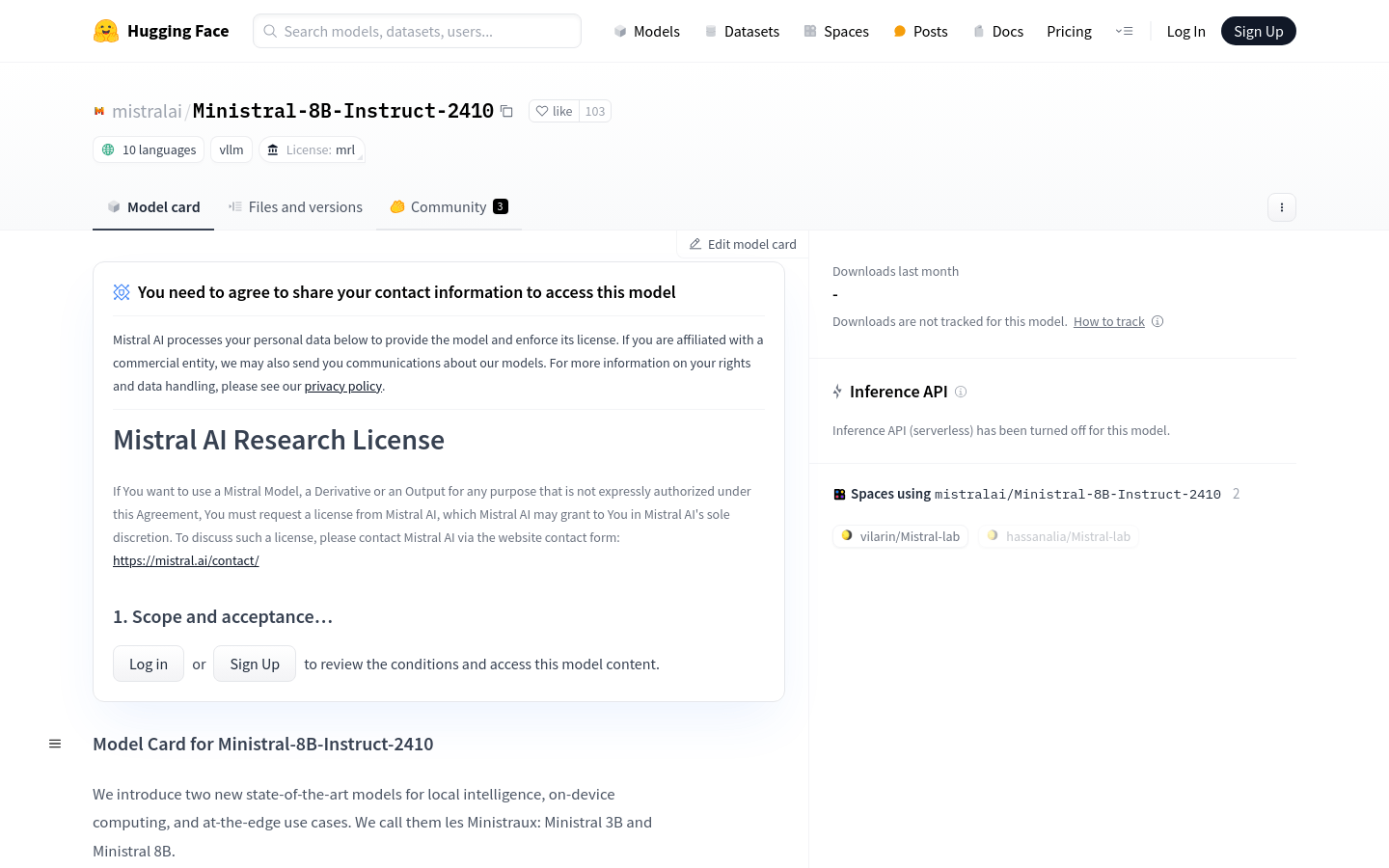

3. 从Hugging Face Hub下载模型并使用vLLM库进行推理

4. 根据需要设置SamplingParams,例如最大令牌数

5. 创建LLM实例并提供模型名称、tokenizer模式、config格式和load格式

6. 准备输入提示并将其作为消息列表传递给LLM实例

7. 调用chat方法并获取输出结果