使用场景

研究人员使用Meta Lingua训练自定义的大型语言模型以进行文本生成任务

开发者利用该库在多GPU环境下优化模型性能和资源利用

学生通过Meta Lingua学习如何构建和训练大型语言模型

产品特色

使用PyTorch组件构建模型,易于修改和实验新架构

支持多种并行策略,如数据并行、模型并行和激活检查点

提供分布式训练支持,可以在多个GPU上进行模型训练

包含用于预训练LLM的dataloader

集成了性能分析工具,帮助计算模型的内存和计算效率

支持模型检查点管理,可以在不同数量的GPU上保存和加载模型

提供配置文件和命令行参数,方便实验设置和迭代

使用教程

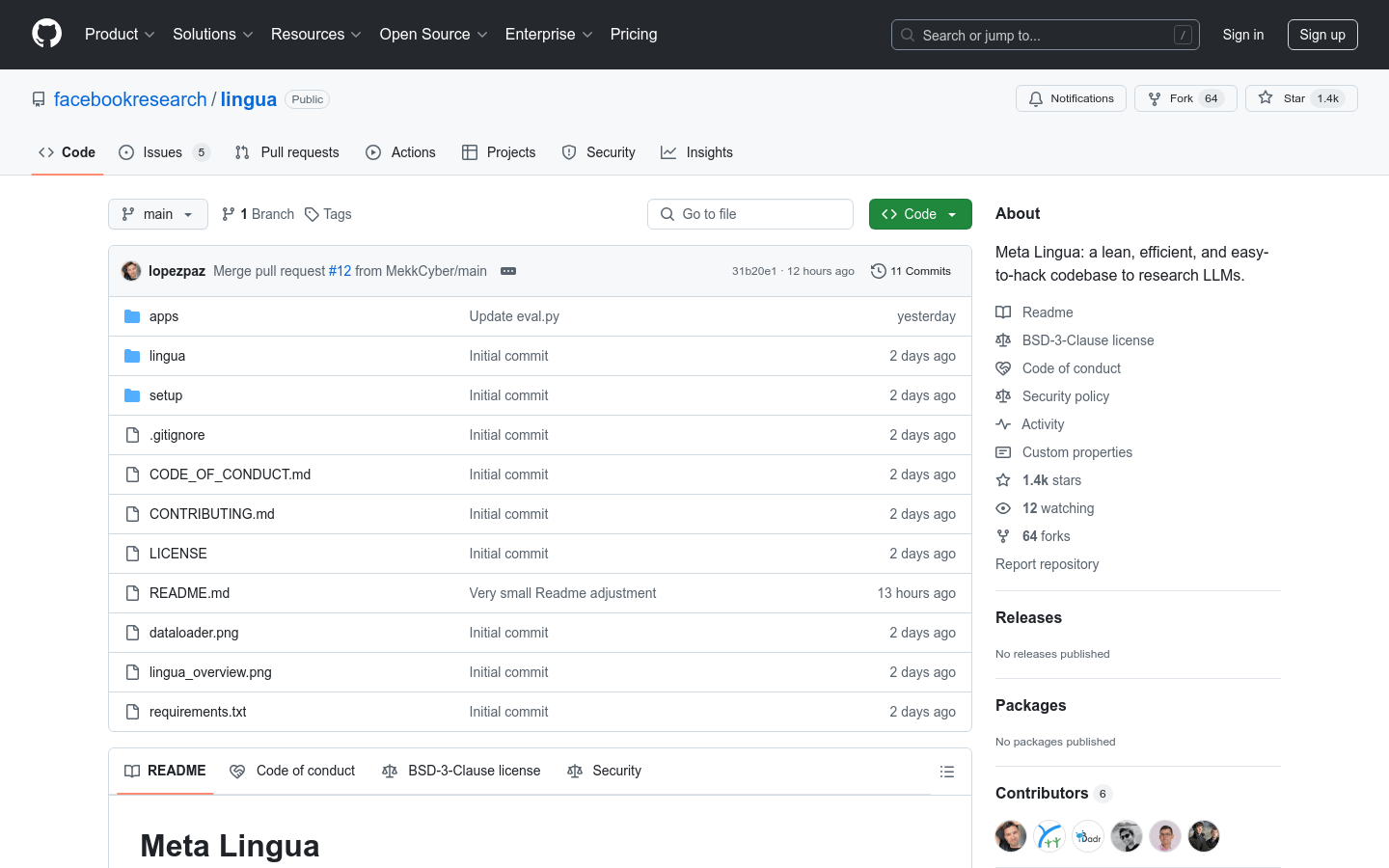

1. 克隆Meta Lingua的代码库到本地

2. 进入代码库目录并运行设置脚本创建环境

3. 激活创建的环境

4. 使用提供的配置文件或自定义配置启动训练脚本

5. 监控训练过程并根据需要调整配置参数

6. 使用评估脚本在给定的检查点上进行模型评估

7. 通过分析工具检查模型的性能和资源使用情况