使用场景

研究人员使用BitNet在个人电脑上运行100B参数的BitNet b1.58模型,进行自然语言理解任务。

开发者利用BitNet框架在ARM架构的移动设备上部署语言模型,实现实时语音识别功能。

企业使用BitNet优化其语言处理应用,提高服务的响应速度和降低运营成本。

产品特色

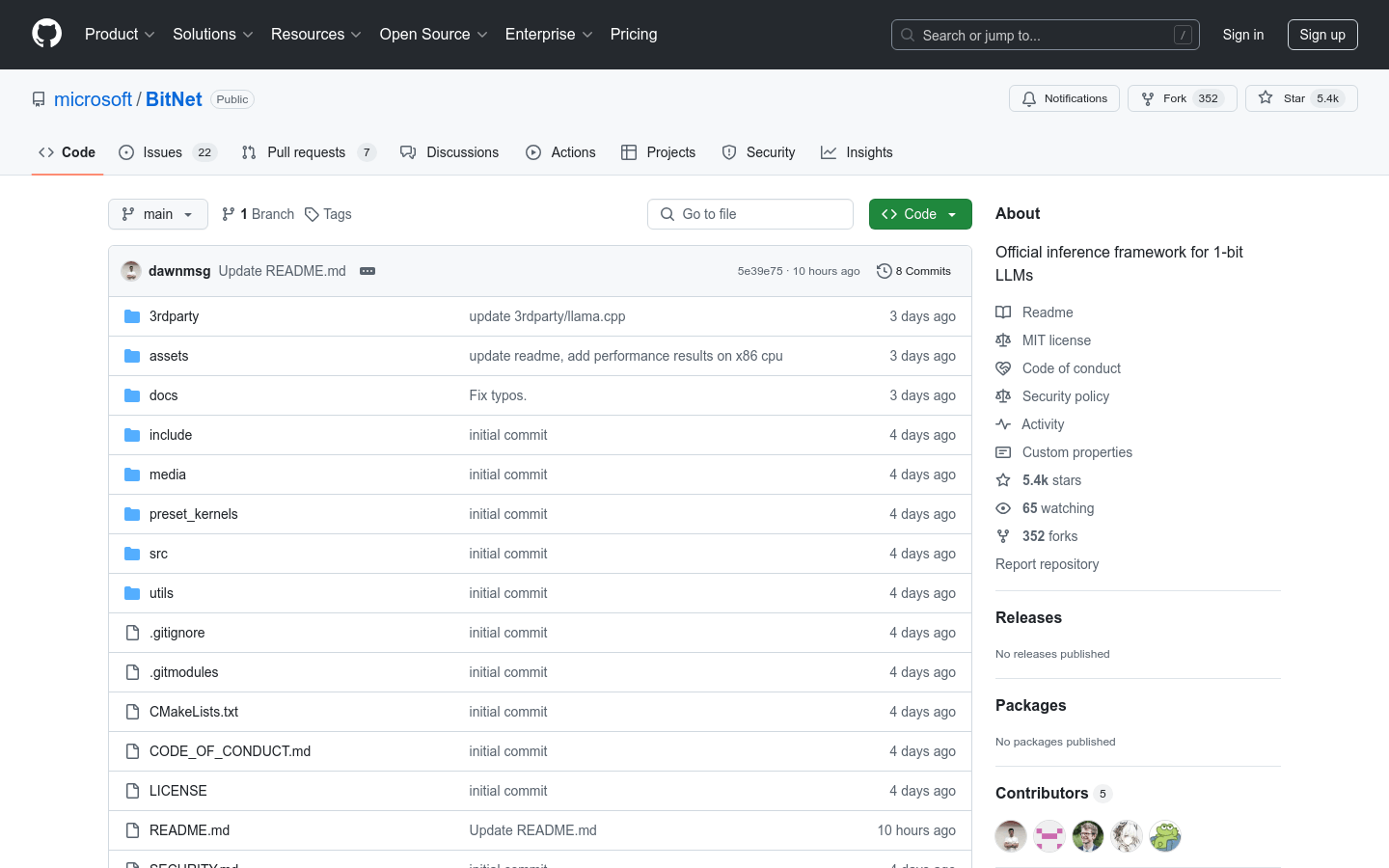

专为1位大型语言模型设计的推理框架

在CPU上实现快速且无损的模型推理

支持ARM和x86架构的CPU,未来将支持NPU和GPU

显著提高推理速度和能效比

能够在单个CPU上运行大型模型,如100B参数的BitNet b1.58

提供详细的安装和使用指南,方便开发者快速上手

基于开源社区的贡献,推动1位LLMs的发展和应用

使用教程

1. 克隆BitNet仓库到本地环境

2. 安装所需的依赖项,包括Python、CMake和Clang

3. 根据指南下载模型,并将其转换为量化的gguf格式

4. 使用setup_env.py脚本设置环境,指定模型路径和量化类型

5. 使用run_inference.py脚本运行推理,输入模型路径、提示文本等参数

6. 根据需要调整线程数量和其他配置,以优化推理性能

7. 分析推理结果,并根据应用场景进行后续处理