使用场景

艺术家使用Stable Diffusion 3.5根据文本提示创作出独特的艺术作品。

研究人员使用该模型来研究图像生成技术的最新进展。

开发者将该模型集成到他们的应用程序中,提供给用户生成个性化图像的功能。

产品特色

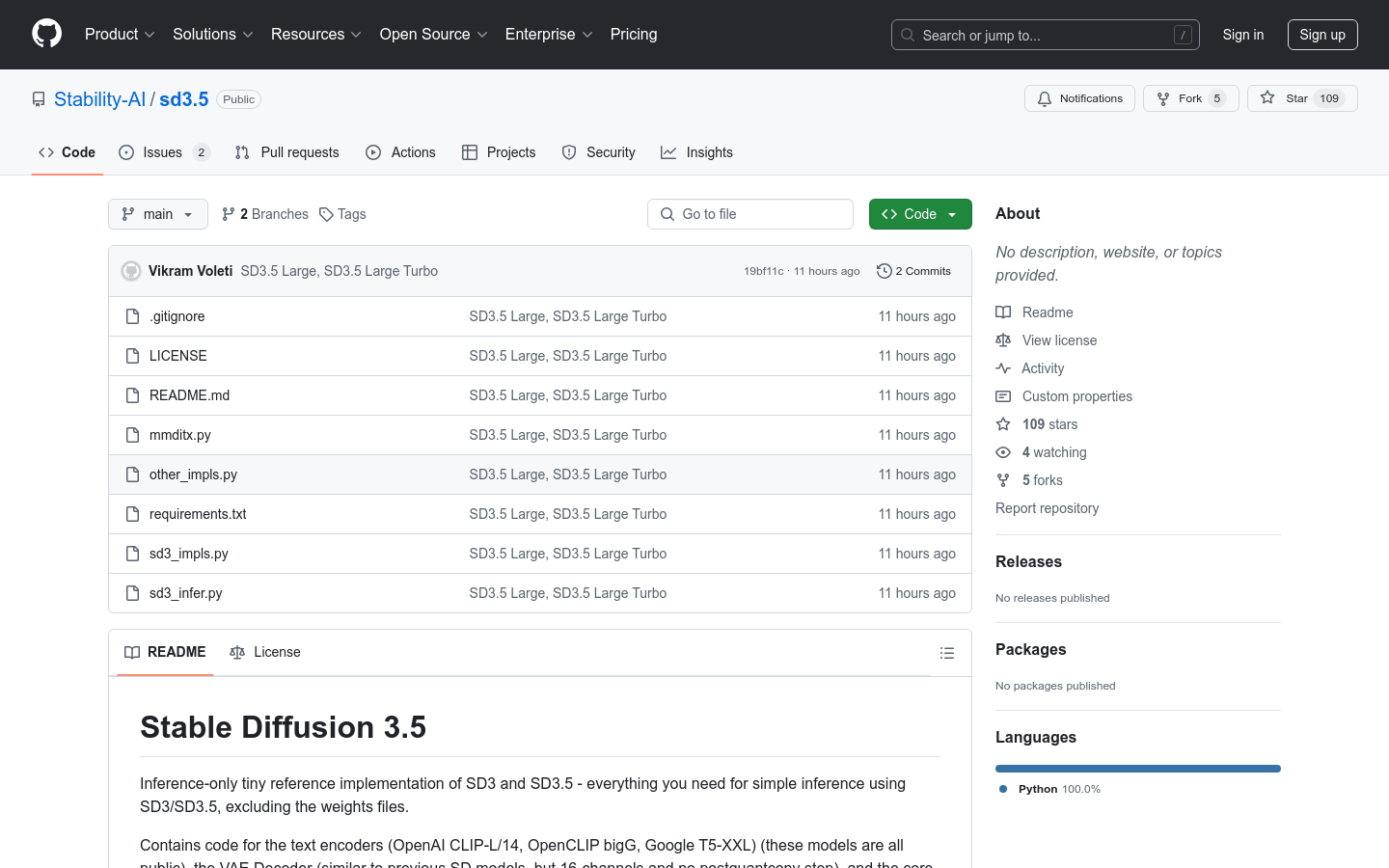

支持多种文本编码器,包括OpenAI CLIP-L/14、OpenCLIP bigG和Google T5-XXL。

使用16通道的VAE解码器,无需后量化卷积步骤。

核心MM-DiT技术提供了高效的图像生成能力。

可以生成不同尺寸和分辨率的图像。

支持从文本提示生成图像。

允许用户通过命令行参数自定义生成设置。

兼容SD3 Medium模型,提供多样化的图像生成选择。

模型和代码遵循Stability AI Community License Agreement。

使用教程

1. 从HuggingFace下载所需的模型文件到本地的`models`目录。

2. 安装Python虚拟环境并激活。

3. 使用pip安装requirements.txt中列出的依赖。

4. 使用命令行运行`sd3_infer.py`脚本,并提供相应的文本提示。

5. 通过命令行参数定制生成的图像的尺寸、步骤数等设置。

6. 模型将根据提供的文本提示生成图像,并保存到指定的输出目录。