使用场景

开发者可以利用 Moonshine 为移动应用添加实时语音识别功能。

企业可以在客服系统中集成 Moonshine,以提供语音转文本服务。

个人用户可以使用 Moonshine 来转录会议或讲座的音频记录。

产品特色

实时转录:适用于现场转录和语音命令识别。

优化的词错误率:在多个数据集上优于 Whisper 模型。

快速处理:对于较短的输入音频,处理速度比 Whisper 快 5 倍。

多平台支持:支持 Torch、TensorFlow 和 JAX 后端。

灵活部署:可以在资源受限的边缘设备上运行。

易于安装:提供详细的安装指南和虚拟环境设置。

模型选择:提供 'moonshine/tiny' 和 'moonshine/base' 两种模型选择。

使用教程

1. 安装 uv 用于 Python 环境管理。

2. 创建并激活虚拟环境:uv venv env_moonshine 和 source env_moonshine/bin/activate。

3. 安装 Moonshine 包,选择适合的后端(Torch、TensorFlow 或 JAX)。

4. 设置环境变量以指示 Keras 使用特定的后端。

5. 使用提供的 .transcribe 函数测试 Moonshine,传入音频文件路径和模型名称。

6. 如果需要使用 ONNX 运行时进行推理,使用 moonshine.transcribe_with_onnx 函数。

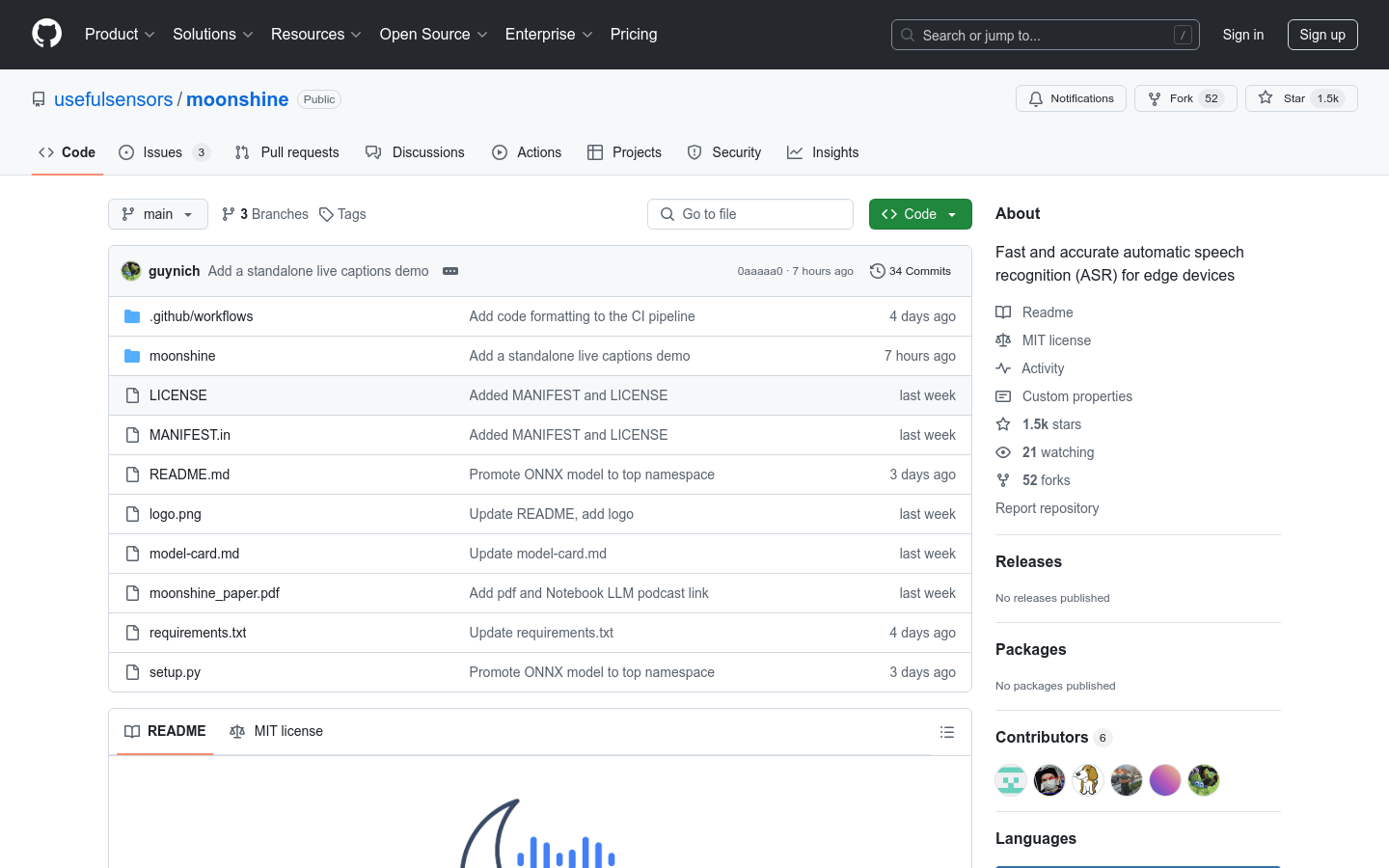

7. 参考 GitHub 仓库中的文档和示例代码进行进一步的开发和集成。