使用场景

案例一:使用LongRAG模型在HotpotQA数据集上进行问答任务,展示了模型在多跳问答中的优势。

案例二:LongRAG在2WikiMultiHopQA数据集上的应用,处理涉及两个 Wikipedia 页面的复杂问答。

案例三:在MusiQue数据集上的应用,LongRAG展现了对音乐领域长文本问答任务的处理能力。

产品特色

• 双视角理解:LongRAG从全局和细节两个角度增强对长文本的理解。

• 检索增强:结合检索技术,提升模型对长文本问答任务的处理能力。

• 多跳推理:适用于需要多步骤推理的复杂问答任务。

• 长文本处理:特别优化以处理超出模型处理长度的长文本。

• 开源免费:模型代码开源,研究者和开发者可以免费使用和修改。

• 灵活配置:支持不同的参数配置,以适应不同的问答任务和数据集。

• 性能优异:在多个长文本问答数据集上展示了优秀的性能。

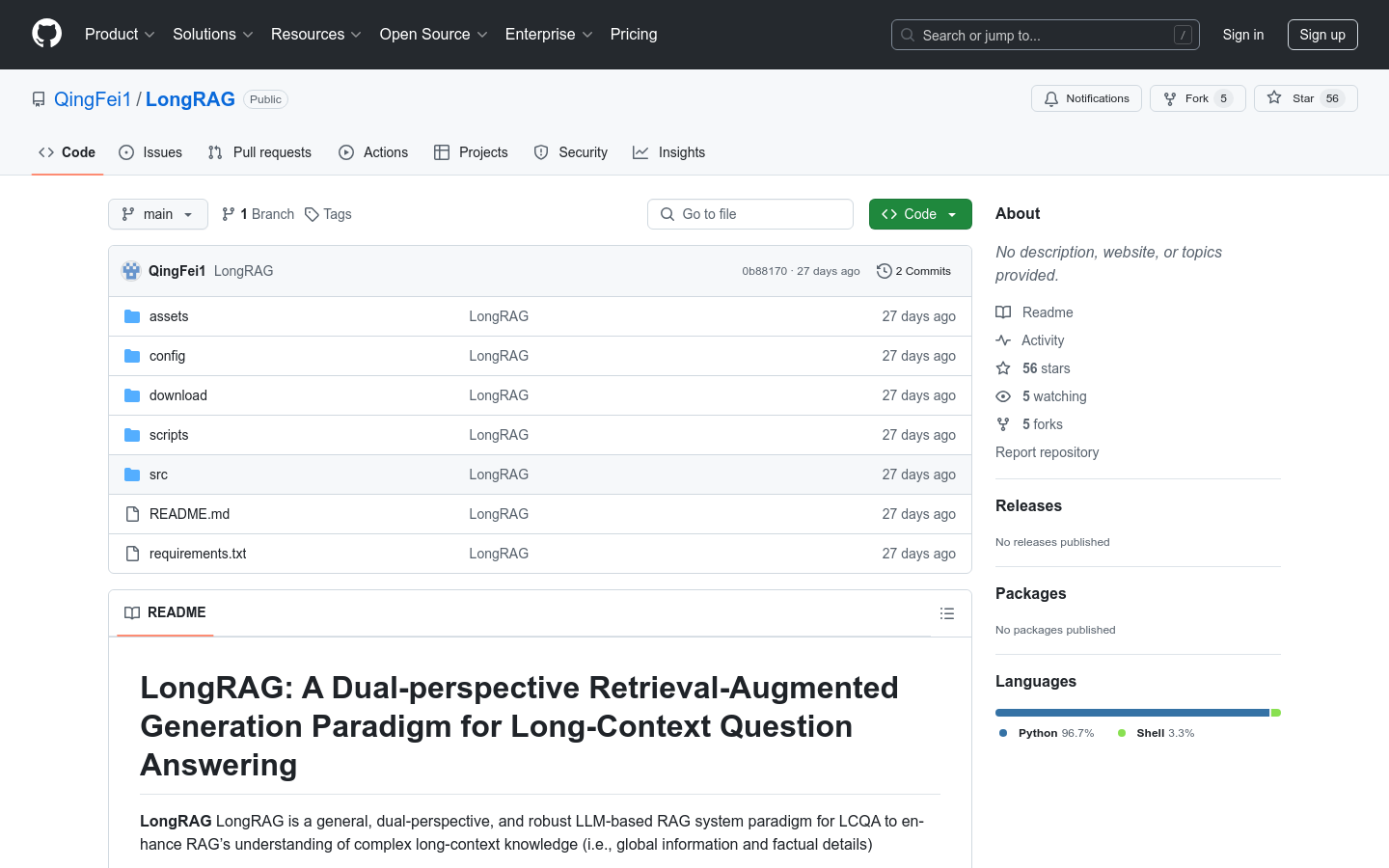

使用教程

1. 安装依赖:使用pip安装requirements.txt中的依赖。

2. 数据准备:下载并标准化所需的训练和评估数据集。

3. 构建数据集:运行gen_instruction.py和gen_index.py脚本来构建用于SFT和检索的数据处理。

4. 模型训练:下载LLaMA-Factory并将构建的指令数据放入其数据目录,修改dataset_info.json后,运行sft.sh脚本开始微调。

5. 模型评估:在src目录下运行main.py脚本来执行推理和评估,使用不同的参数配置以适应不同的模型和任务。

6. 结果分析:评估结果将保存在log目录中,可以分析模型在各个数据集上的性能。