使用场景

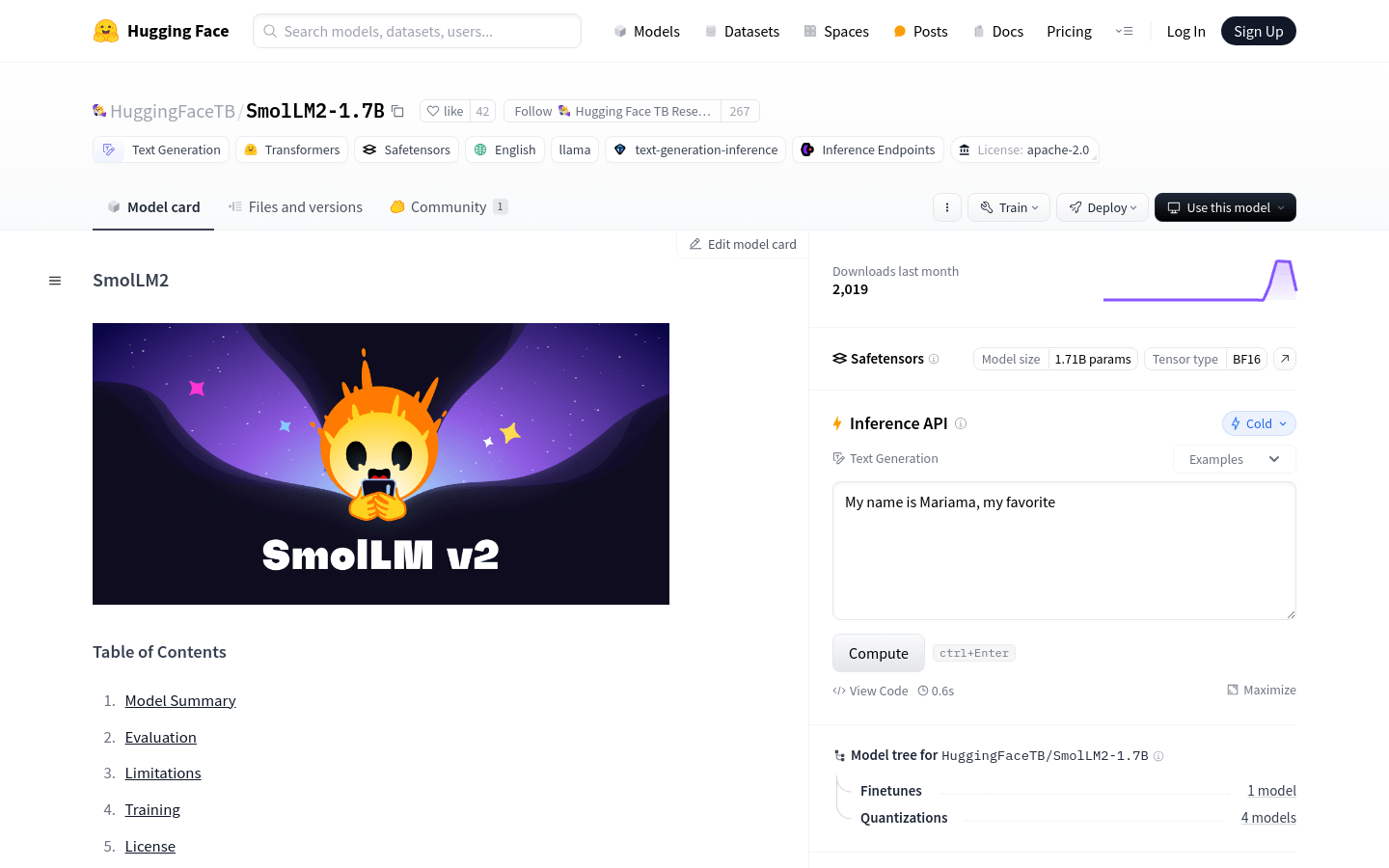

使用SmolLLM2-1.7B生成特定主题的文本内容。

在教育应用中,利用模型进行数学问题的解答和推理。

在商业智能中,使用模型进行数据摘要和报告生成。

产品特色

支持文本生成:能够处理广泛的文本生成任务。

指令遵循:特别优化以遵循指令,提高任务执行的准确性。

知识推理:在知识推理方面表现出色,能够处理复杂的逻辑问题。

数学能力:新增的数学和编程数据集使其在数学问题上表现更好。

文本重写和总结:利用特定数据集支持文本重写和总结任务。

跨平台兼容性:能够在不同的硬件和软件平台上运行。

优化的内存占用:相较于其他大型模型,具有更优的内存占用。

使用教程

1. 安装transformers库:在终端或命令提示符中运行`pip install transformers`。

2. 导入必要的模块:在Python代码中导入AutoModelForCausalLM和AutoTokenizer。

3. 加载模型和分词器:使用`AutoTokenizer.from_pretrained`和`AutoModelForCausalLM.from_pretrained`加载模型和分词器。

4. 准备输入数据:将文本编码为模型可以理解的格式,使用`tokenizer.encode`方法。

5. 生成输出:使用`model.generate`方法生成文本。

6. 解码输出:将模型生成的编码文本转换回可读文本,使用`tokenizer.decode`方法。

7. 优化性能:如果需要在GPU上运行模型,可以将模型和输入数据转移到GPU上,并使用适当的精度(如bfloat16)。