使用场景

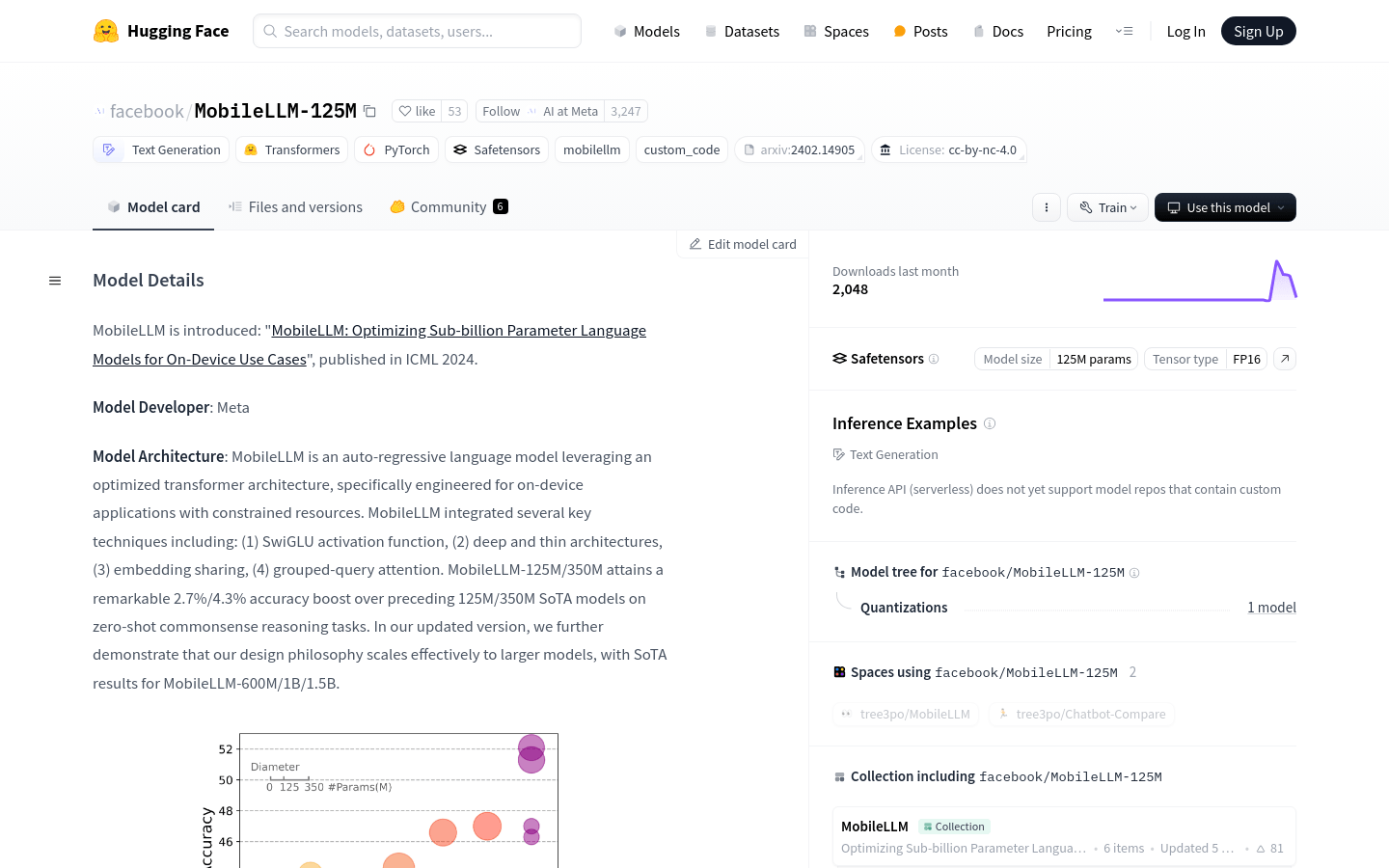

使用MobileLLM-125M进行设备端的文本生成任务。

在移动设备上部署MobileLLM-125M进行自然语言理解。

利用MobileLLM-125M进行常识推理任务,提升设备端应用的智能水平。

产品特色

• 优化的变换器架构:专为设备端应用设计的轻量级模型。

• 多种关键技术集成:包括SwiGLU激活函数、深度薄架构等。

• 零样本常识推理:在多个常识推理任务上超越了前代模型。

• 支持HuggingFace平台:方便加载预训练模型进行微调和评估。

• 支持自定义代码:提供MobileLLM代码库,支持自定义训练和评估。

• 多模型尺寸:提供从125M到1.5B不同参数量的模型选择。

• 高效训练成本:使用32个NVIDIA A100 80G GPU训练1T个token的时间成本。

使用教程

1. 访问HuggingFace官网并搜索MobileLLM-125M模型。

2. 使用HuggingFace提供的代码加载预训练的MobileLLM-125M模型。

3. 根据需要对模型进行微调或直接使用预训练模型进行推理。

4. 若需要自定义训练,可从GitHub获取MobileLLM的代码库并按照指南进行操作。

5. 利用模型进行文本生成或其他NLP任务,并评估模型性能。

6. 根据项目需求调整模型参数,优化模型以适应特定的设备或应用场景。