使用场景

案例一:使用Aquila-VL-2B模型对社交媒体上的图片进行内容分析和描述生成。

案例二:在电子商务平台中,利用该模型为商品图片自动生成描述性文本,提升用户体验。

案例三:在教育领域,通过图像和文本的结合,为学生提供更直观的学习材料和互动体验。

产品特色

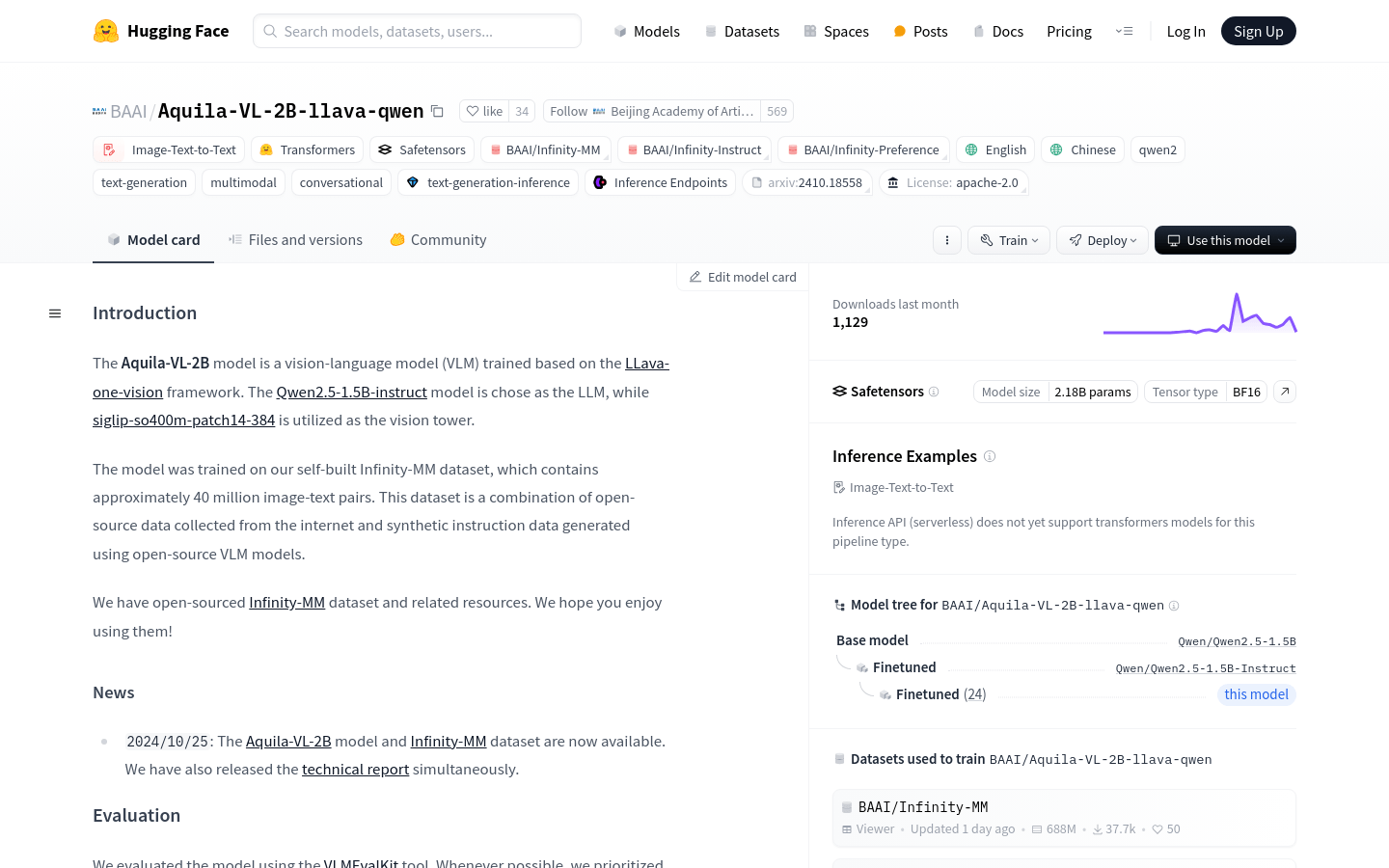

• 支持图像-文本到文本的转换(Image-Text-to-Text)

• 基于Transformers和Safetensors库构建

• 支持多种语言,包括中文和英文

• 支持多模态和对话生成

• 支持文本生成推理

• 兼容推理端点(Inference Endpoints)

• 支持大规模图像-文本数据集

使用教程

1. 安装必要的库:使用pip安装LLaVA-NeXT库。

2. 加载预训练模型:通过llava.model.builder中的load_pretrained_model函数加载Aquila-VL-2B模型。

3. 准备图像数据:使用PIL库加载图像,并使用llava.mm_utils中的process_images函数处理图像数据。

4. 构建对话模板:根据模型选择合适的对话模板,并构建问题。

5. 生成提示:将问题和对话模板结合,生成模型的输入提示。

6. 编码输入:使用tokenizer将提示问题编码为模型可理解的输入格式。

7. 生成输出:调用模型的generate函数,生成文本输出。

8. 解码输出:使用tokenizer.batch_decode函数将模型输出解码为可读文本。