使用场景

开发者使用Qwen2.5-Coder-3B-Instruct-GGUF生成新的代码模块,提高开发效率。

软件工程师利用模型修复现有代码中的错误,减少调试时间。

编程爱好者通过模型学习代码最佳实践,提升编程技能。

产品特色

代码生成:显著提升代码生成能力,帮助开发者快速实现代码逻辑。

代码推理:增强模型对代码逻辑的理解,提高代码分析的准确性。

代码修复:辅助开发者识别并修复代码中的错误,提升代码质量。

支持长序列处理:支持长达32,768个令牌的上下文长度,适合处理大型代码库。

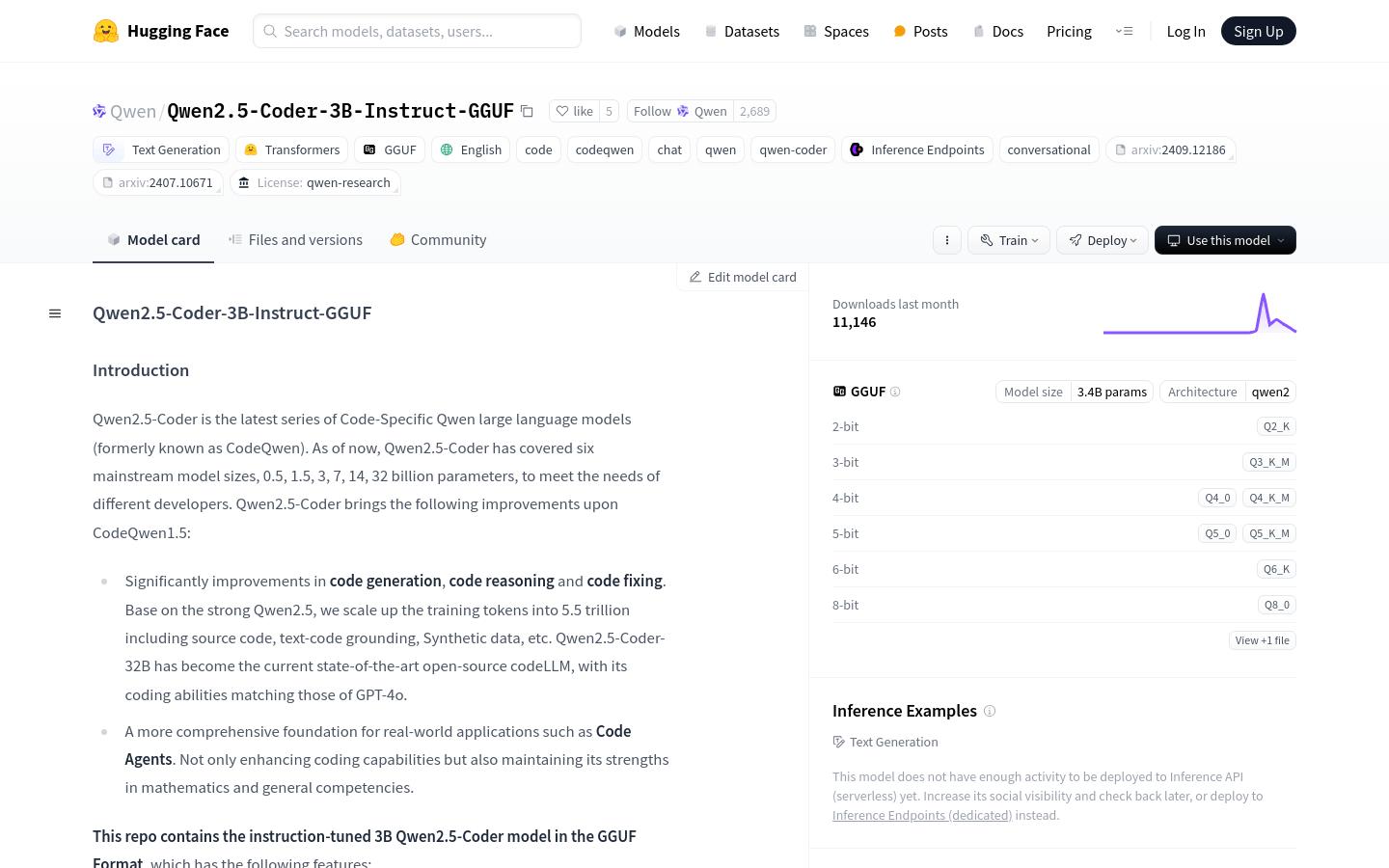

多种量化版本:提供2-bit至8-bit的量化版本,适应不同的性能和资源需求。

基于transformers架构:采用RoPE、SwiGLU、RMSNorm等先进技术,提升模型性能。

开源:模型开源,便于社区贡献和进一步的研究发展。

使用教程

1. 安装huggingface_hub和llama.cpp,以便下载和运行模型。

2. 使用huggingface-cli下载所需的GGUF文件。

3. 根据文档指导,克隆llama.cpp仓库并按照官方指南安装。

4. 使用llama-cli启动模型,并设置适当的参数以进行聊天模式体验。

5. 根据需要调整参数,如令牌数量、GPU内存使用等,以优化性能。

6. 通过模型生成代码、推理代码逻辑或修复代码错误。

7. 参与社区讨论,贡献代码,或根据模型输出进一步开发。