使用场景

开发者使用Qwen2.5-Coder自动补全代码,提高编码效率。

在代码审查过程中,利用Qwen2.5-Coder识别潜在的代码缺陷和错误。

教育环境中,Qwen2.5-Coder作为教学工具,帮助学生理解和学习编程概念。

产品特色

代码生成:显著提升代码生成能力,包括源代码生成、文本代码基础和合成数据。

代码推理:增强模型对代码逻辑和结构的理解能力。

代码修复:提高模型识别和修复代码中错误和缺陷的能力。

全面应用:适用于实际应用场景,如代码代理,不仅增强编码能力,还保持数学和通用能力。

模型参数:1.54B参数,其中非嵌入参数为1.31B,28层,12个注意力头用于Q,2个用于KV。

上下文长度:支持完整的32,768个token,是目前支持长序列处理的模型之一。

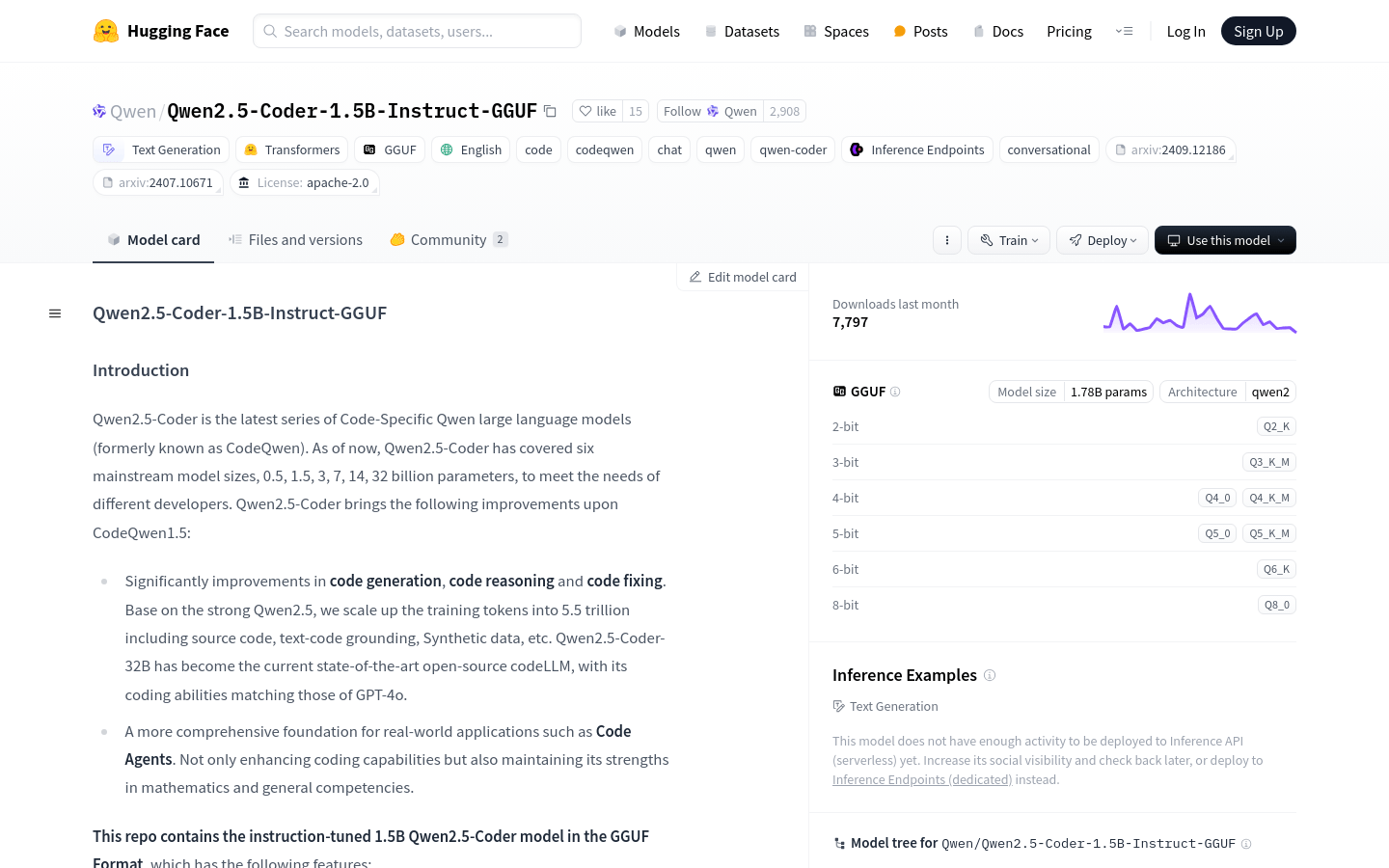

量化:支持多种量化级别,如q2_K, q3_K_M, q4_0, q4_K_M, q5_0, q5_K_M, q6_K, q8_0。

使用教程

1. 安装huggingface_hub和llama.cpp,以便下载和运行模型。

2. 使用huggingface-cli下载所需的GGUF文件。

3. 根据官方指南安装llama.cpp,并确保跟随最新版本。

4. 使用llama-cli启动模型,并通过指定的命令行参数进行配置。

5. 在聊天模式下运行模型,以实现类似聊天机器人的交互体验。

6. 根据需要调整参数,如GPU内存和吞吐量,以适应不同的使用场景。