使用场景

案例一:跨国公司使用WhisperNER处理多语言会议记录,实现自动化的语音转文字和关键信息提取。

案例二:研究机构利用WhisperNER进行语音数据的预处理,为后续的机器学习模型训练提供准确的输入。

案例三:开发者将WhisperNER集成到移动应用中,为用户提供实时语音识别和实体推荐功能。

产品特色

- 零样本能力:无需训练即可识别多种语言和实体。

- 统一模型:结合ASR和NER,提高处理效率。

- 微调能力:可以在特定数据集上进行微调,以获得更好的性能。

- 多语言支持:适用于多种语言的语音和实体识别。

- 高准确性:基于先进的深度学习技术,提供高精度的识别结果。

- 易于集成:提供代码示例和API,方便开发者集成到自己的项目中。

- 开源:代码开源,社区可以共同参与模型的改进和优化。

使用教程

1. 创建虚拟环境并激活:使用conda或pip安装所需环境和依赖。

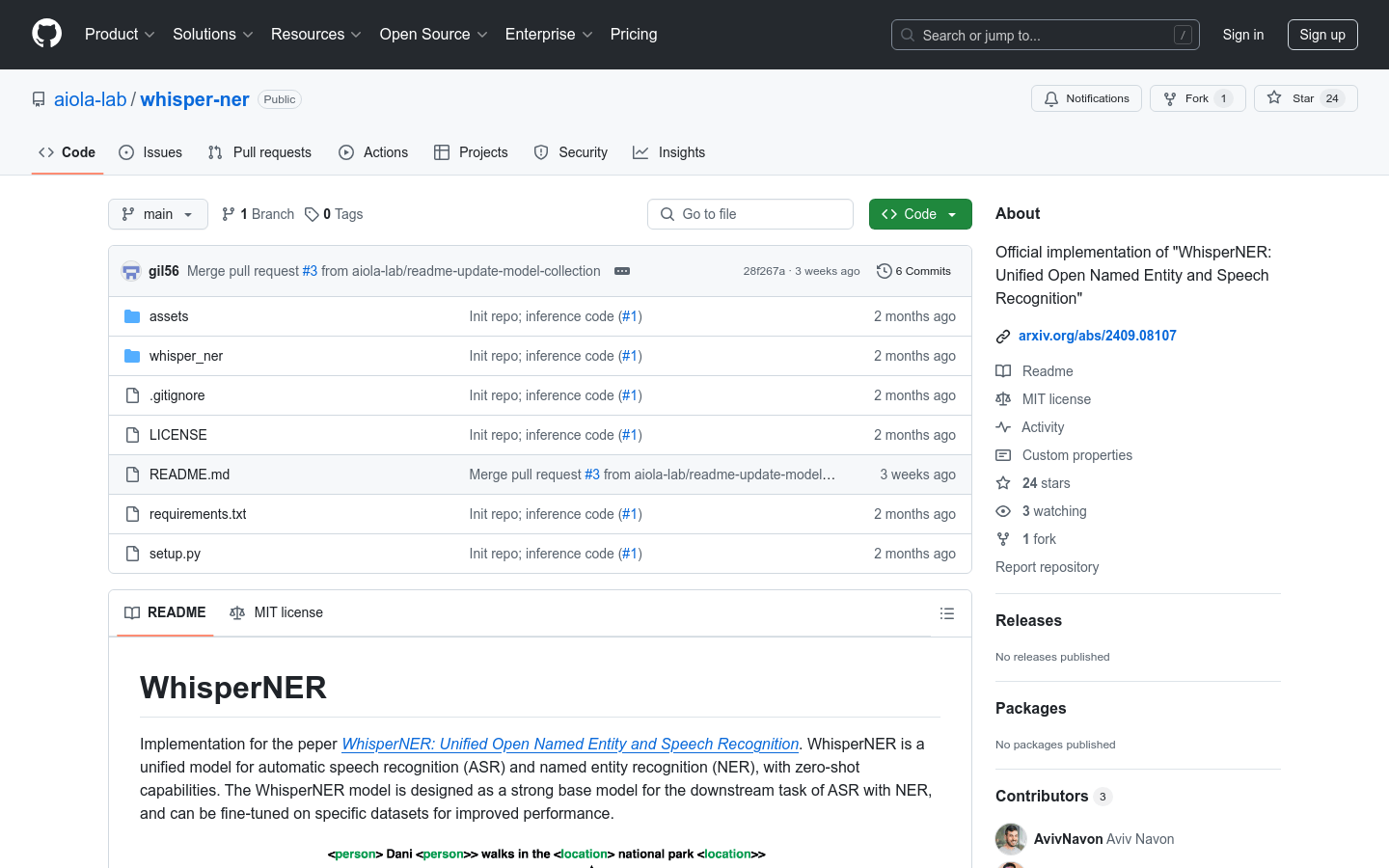

2. 克隆代码库:通过git clone命令将WhisperNER的代码克隆到本地。

3. 安装依赖:根据项目提供的requirements.txt文件,使用pip安装所有依赖。

4. 加载模型和处理器:使用transformers库中的WhisperProcessor和WhisperForConditionalGeneration加载预训练模型。

5. 音频预处理:使用项目提供的audio_preprocess函数对音频文件进行预处理。

6. 运行模型:将预处理后的音频输入到模型中,生成token ids。

7. 后处理:将生成的token ids转换为文本,并去除prompt部分,得到最终的语音识别和实体识别结果。