使用场景

用于生成连贯的文本续写,如故事创作、文章撰写等。

在问答系统中,用于理解和生成问题的答案。

作为文本分类器,对大量文档进行分类和标签化。

产品特色

支持高达4096的上下文长度,适用于长文本处理。

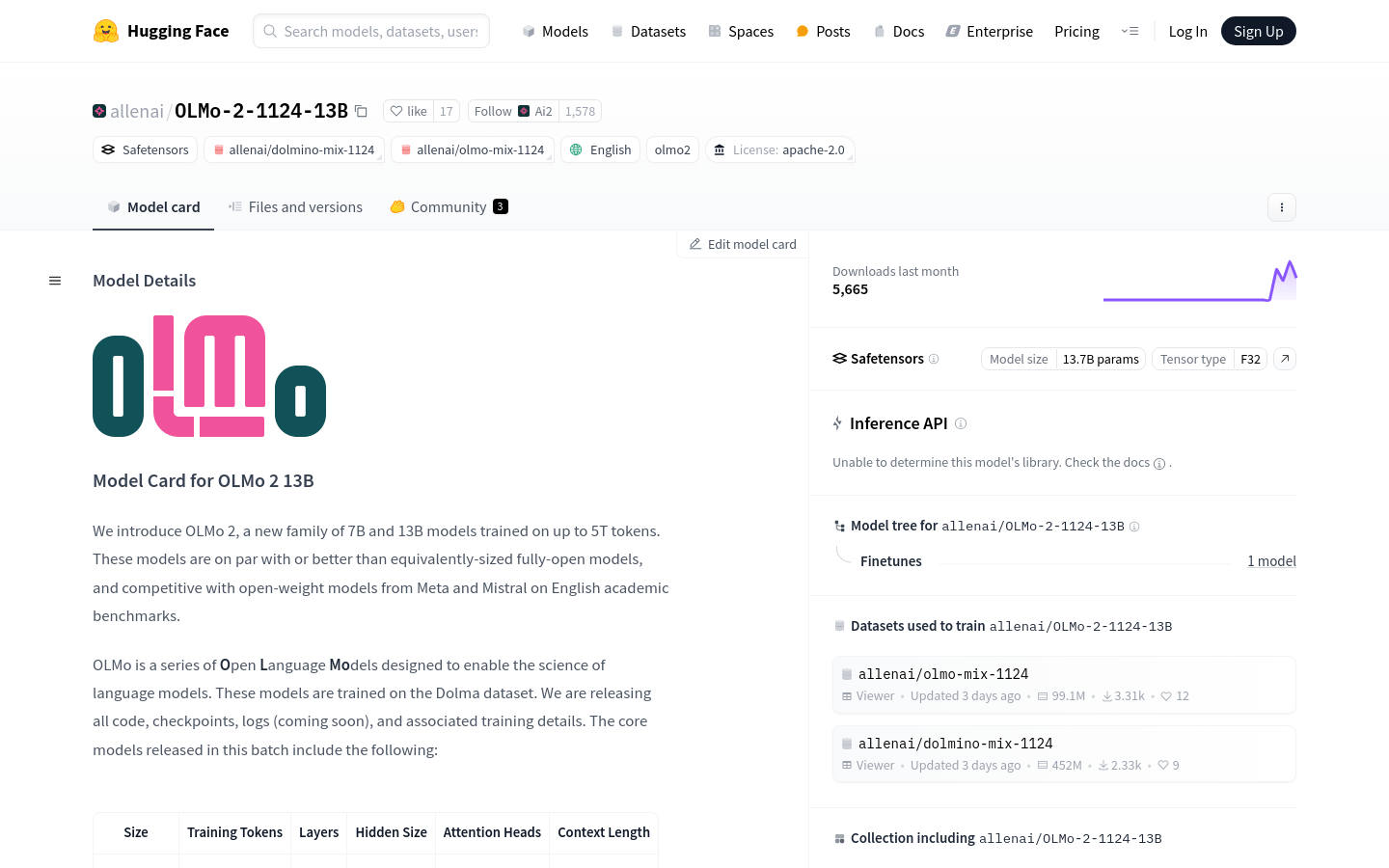

模型经过5万亿个token的训练,具有强大的语言理解和生成能力。

提供多种fine-tuning选项,包括SFT、DPO和PPO。

模型支持量化,以提高推理速度和降低资源消耗。

可通过HuggingFace的Transformers库轻松集成和使用。

模型在多个英文学术基准测试中表现优异,如ARC/C、HSwag、WinoG等。

使用教程

1. 安装Transformers库:使用pip命令安装最新版本的Transformers库。

2. 加载模型和分词器:通过AutoModelForCausalLM和AutoTokenizer从HuggingFace加载OLMo 2 13B模型及其分词器。

3. 准备输入文本:将要处理的文本通过分词器转换为模型可理解的格式。

4. 生成文本:使用模型的generate方法生成文本,可设置参数如max_new_tokens、do_sample等来控制生成过程。

5. 解码输出:将模型生成的token序列解码为可读文本。

6. 可选的模型量化:为了提高推理速度,可以选择对模型进行量化处理。

7. 模型微调:根据具体需求,可以选择对模型进行fine-tuning以适应特定任务。