使用场景

研究人员使用该工具来评估不同语言模型生成的科学文献的准确性和可靠性。

教育工作者可以利用该工具来教授学生如何评估AI生成的内容。

开发者可以利用该工具来测试和改进他们自己的语言模型。

产品特色

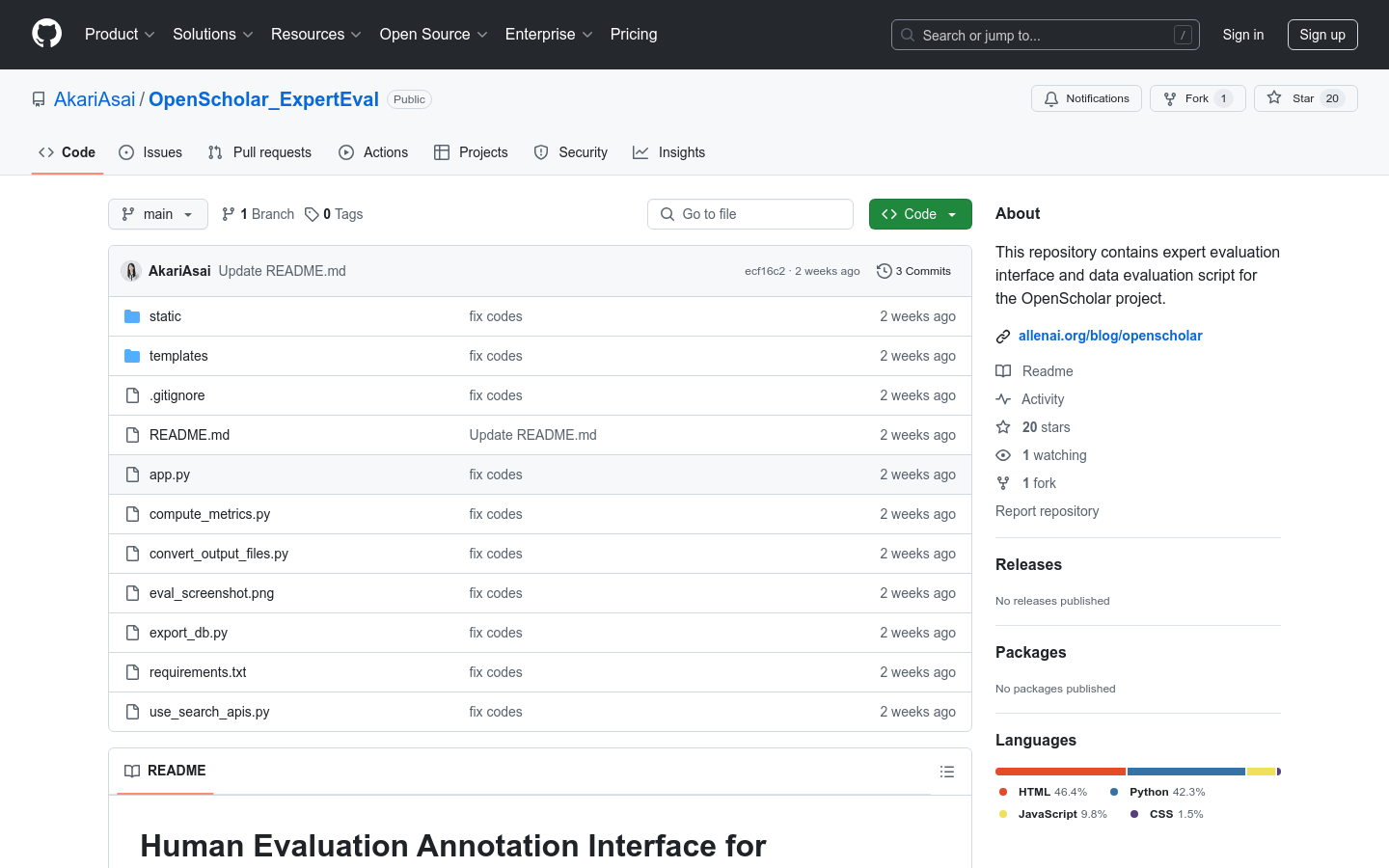

提供人工评估标注界面:用于专家对模型生成的文本进行评估。

支持RAG评估:能够对检索增强型生成模型进行评估。

细粒度评估:允许专家进行更细致的评估。

数据准备:需要将评估实例放入指定文件夹,支持JSONL格式。

结果数据库存储:评估结果默认存储在本地数据库文件中。

结果导出:支持将评估结果导出为Excel文件。

评估指标计算:提供脚本计算评估指标和一致性。

界面分享:支持在云服务上部署,以便分享评估界面。

使用教程

1. 安装环境:按照README中的指南创建并激活虚拟环境,并安装依赖。

2. 准备数据:将评估实例放入`data`文件夹中,每个实例应包含提示和两个模型的完成结果。

3. 运行应用:使用`python app.py`命令启动评估界面。

4. 访问界面:在浏览器中打开`http://localhost:5001`来访问评估界面。

5. 评估结果:评估完成后,可以在`http://localhost:5001/summary`查看进度。

6. 结果导出:使用`python export_db.py`命令将评估结果导出为Excel文件。

7. 计算指标:使用`python compute_metrics.py`命令计算评估指标和一致性。