使用场景

案例一:研究人员使用OLMo-2-1124-7B-DPO模型进行聊天机器人的开发,以提供更自然和准确的对话。

案例二:教育机构利用该模型生成教学材料,如数学问题和解答,以辅助教学。

案例三:开发者将模型集成到他们的应用程序中,以提供自动内容生成功能,增强用户体验。

产品特色

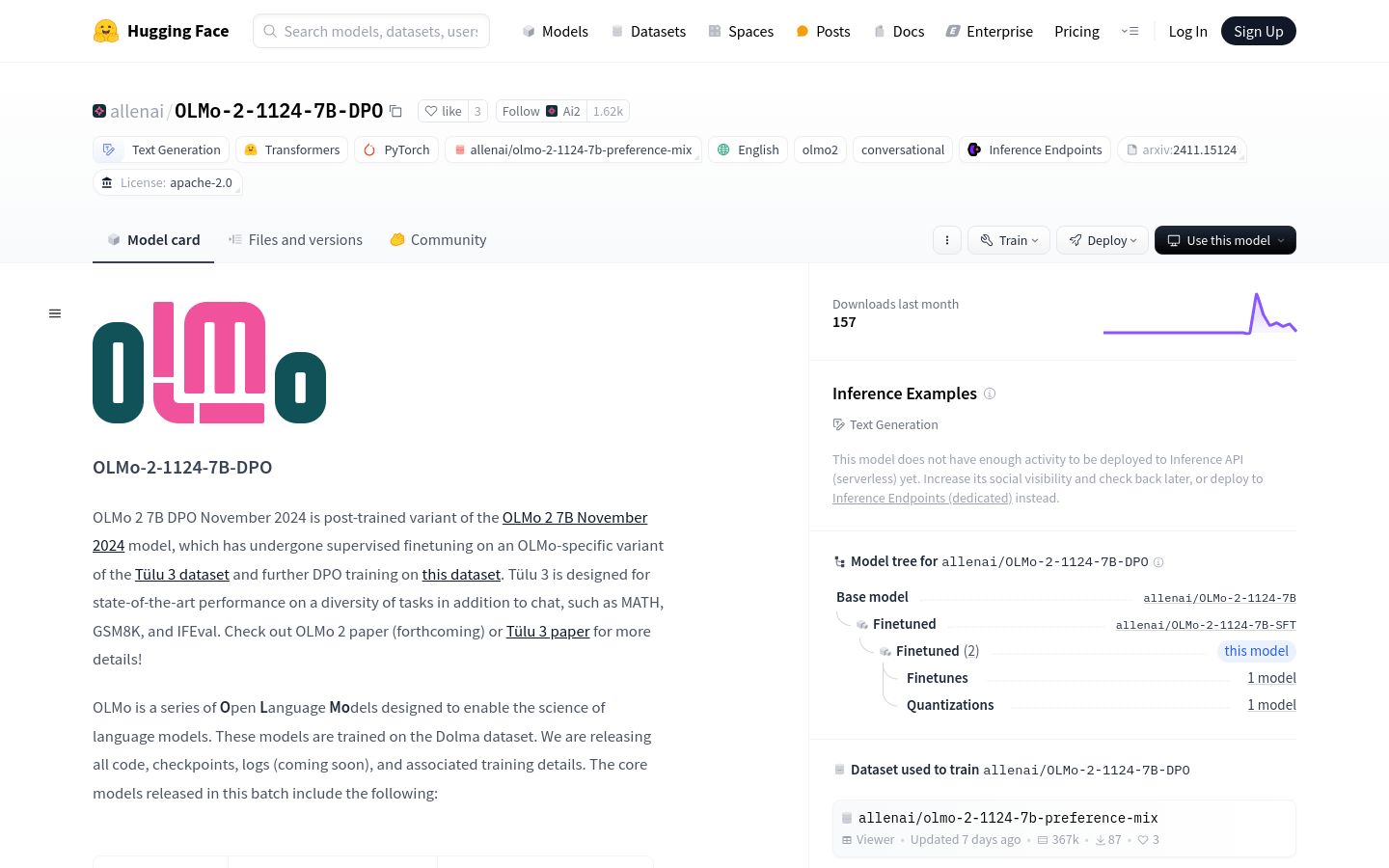

- 支持文本生成:能够生成连贯且相关的文本内容。

- 多样化任务处理:除了聊天,还能处理数学问题、GSM8K、IFEval等任务。

- 微调训练:在特定数据集上进行微调,提升模型在特定任务上的表现。

- 支持PyTorch:方便与现有的PyTorch项目集成。

- 遵循Apache 2.0许可:允许研究和教育用途的自由使用。

- 模型性能数据:提供详细的性能数据,帮助用户了解模型在不同任务上的表现。

- 易于部署:可通过Hugging Face平台轻松加载和使用模型。

使用教程

1. 安装Transformers库:使用pip命令安装最新版本的Transformers库。

2. 加载模型:通过Hugging Face提供的代码片段加载OLMo-2-1124-7B-DPO模型。

3. 使用聊天模板:按照提供的聊天模板格式输入用户和助手的对话。

4. 系统提示设置:根据需要设置系统提示,以指导模型的行为。

5. 生成文本:利用模型的文本生成能力,输入提示并获取生成的文本。

6. 评估性能:参考模型在不同任务上的性能数据,评估模型的表现。

7. 微调模型:如果需要,可以在特定数据集上对模型进行进一步的微调。