使用场景

用于训练大规模语言模型,如BERT或GPT。

在医学图像分析中,用于训练跨多个数据中心的深度学习模型。

在金融领域,用于风险评估模型的全球分布式训练。

产品特色

ElasticDeviceMesh:支持容错训练,动态管理全球进程组。

异步分布式检查点:减少模型保存的时间,提高计算利用率。

实时检查点恢复:允许节点在训练中途加入,快速获取模型状态。

自定义Int8 All-Reduce Kernel:减少通信负载,提高带宽利用率。

最大化带宽利用:通过分片技术提高网络带宽利用率。

PyTorch FSDP2 / DTensor ZeRO-3实现:支持模型权重、梯度和优化器状态的分片。

CPU Off-Loading:将Diloco优化器所需的所有张量卸载到CPU内存,减轻GPU负担。

使用教程

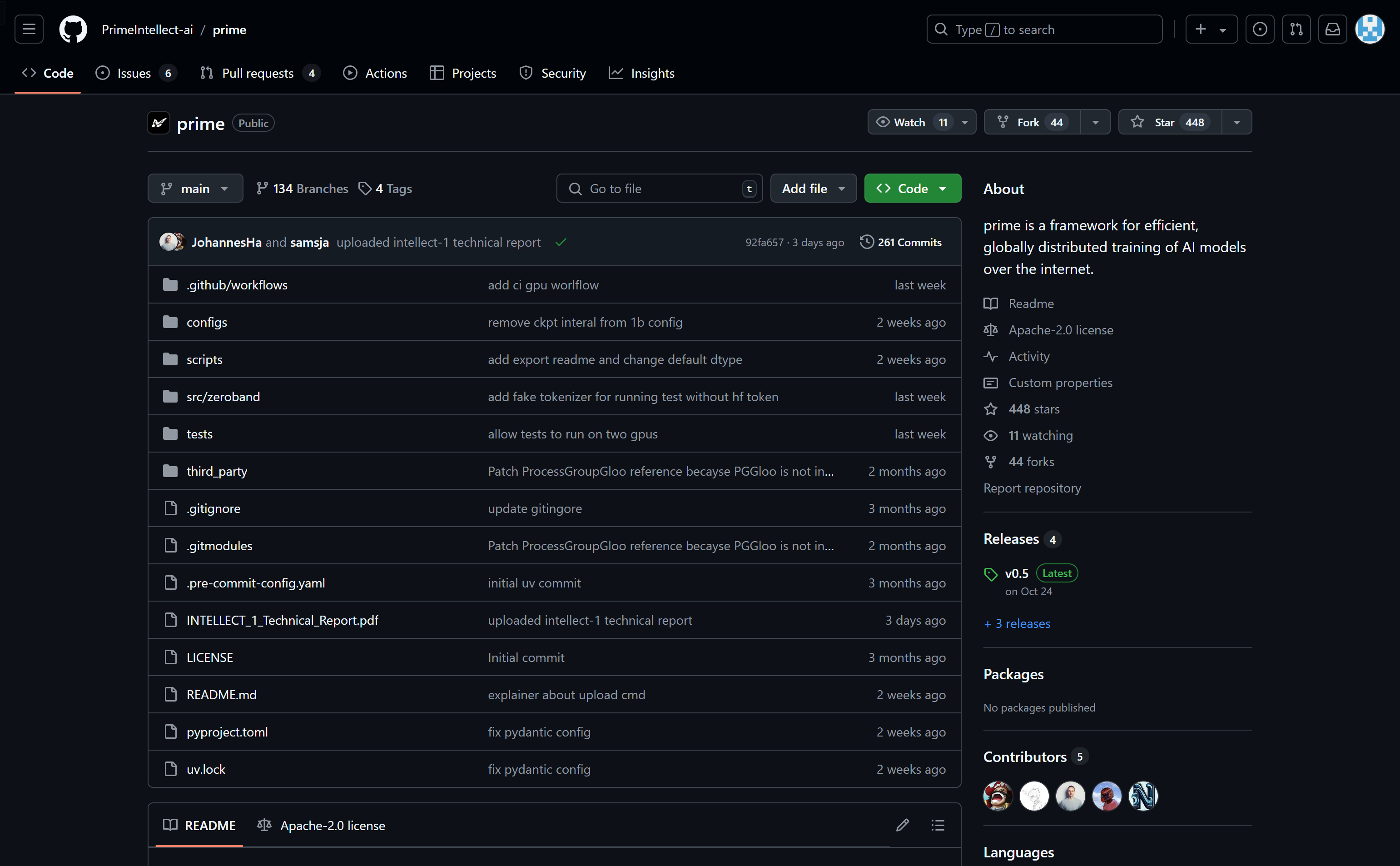

1. 克隆仓库:使用git clone命令克隆PrimeIntellect-ai/prime项目到本地。

2. 安装uv:按照项目页面提供的指令安装uv工具。

3. 设置环境:安装iperf工具,创建虚拟环境并激活,同步依赖。

4. 登录Hugging Face:使用huggingface-cli命令登录Hugging Face平台。

5. 运行测试:使用提供的命令运行测试,验证设置是否正确。

6. 运行DiLoCo:使用helper脚本在本地测试DiLoCo。

7. 运行完整测试套件:确保至少有两个GPU,然后运行pytest命令。

8. 导出检查点:使用提供的export_dcp.py脚本将训练脚本保存的检查点转换为Hugging Face兼容模型。