使用场景

- 使用Aria-Base-64K进行视频问答系统的开发,提高视频内容理解能力。

- 将Aria-Base-64K应用于长文档问答,提升文档检索和理解的效率。

- 利用Aria-Base-64K进行图像和文本的联合推理,开发新的多模态应用。

产品特色

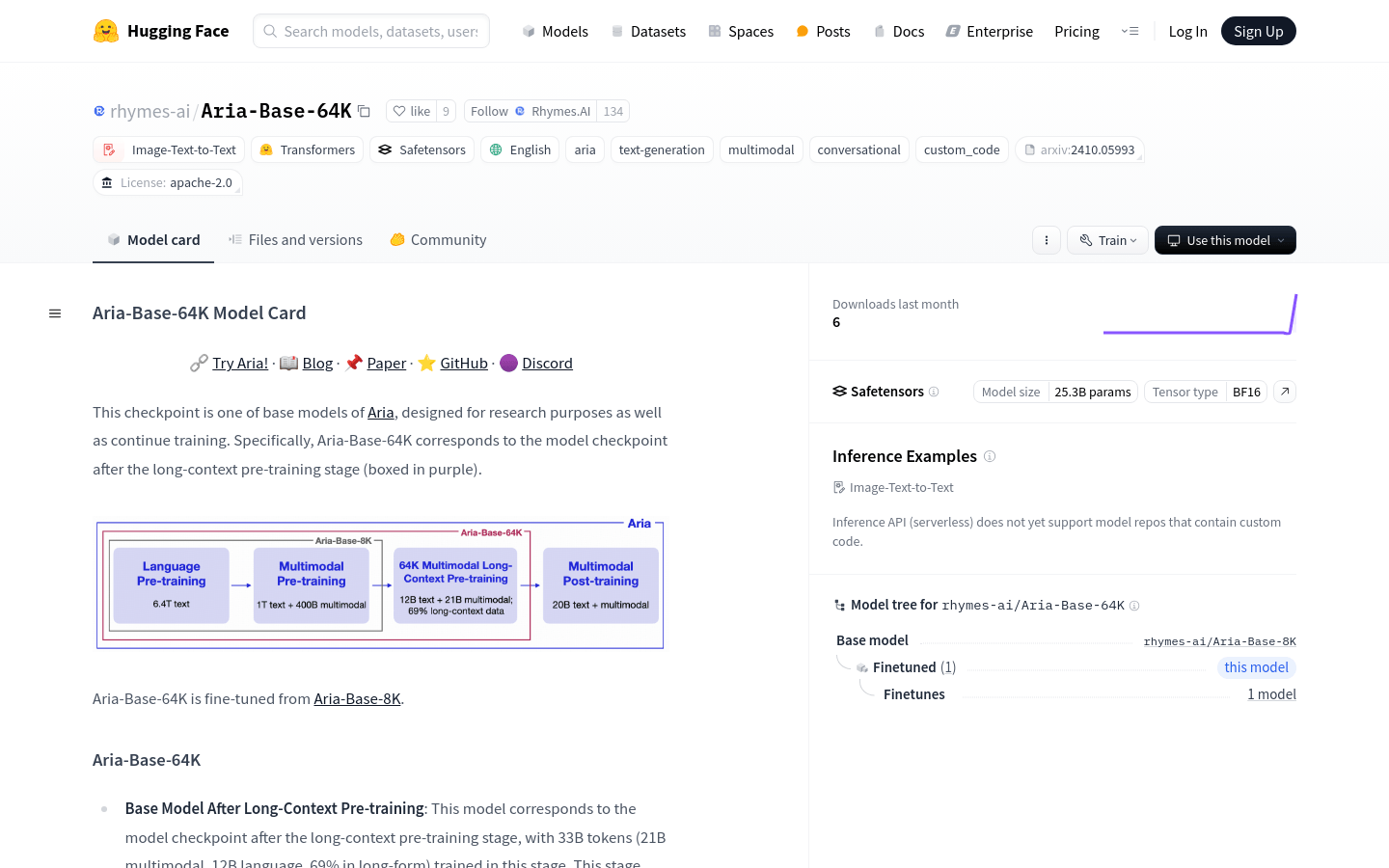

- 长文本预训练:经过33B个token的训练,适合长视频问答和长文档问答数据集的继续预训练或微调。

- 多模态理解:能够理解多达250张高分辨率图像或多达500张中等分辨率图像。

- 强大的基础性能:在语言和多模态场景中保持与Aria-Base-8K相同的强大基础性能。

- 低比例聊天模板训练:仅用约3%的数据进行了聊天模板格式的训练,可能不适合直接用于聊天模板。

- 快速启动支持:提供了快速安装和推理的代码示例,便于用户快速开始使用模型。

- 高级推理和微调:提供了代码库,支持更高级的推理、示例和自定义数据集上的微调。

使用教程

1. 安装必要的库:使用pip安装transformers、accelerate、sentencepiece等库。

2. 加载模型:通过AutoModelForCausalLM.from_pretrained加载Aria-Base-64K模型。

3. 处理输入:使用AutoProcessor.from_pretrained处理输入文本和图像。

4. 进行推理:将处理好的输入传递给模型,执行生成操作。

5. 解码输出:使用处理器解码模型输出的token,得到最终结果。

6. 高级使用:根据需要,可以访问GitHub上的代码库,进行更高级的推理和微调。