使用场景

视频内容创作者使用HunyuanVideo生成具有特定风格和主题的短视频。

研究人员利用HunyuanVideo进行视频生成模型的性能对比研究。

教育机构使用HunyuanVideo作为教学工具,向学生展示视频生成技术的实际应用。

产品特色

统一的图像和视频生成架构:引入Transformer设计,使用全注意力机制进行图像和视频生成。

MLLM文本编码器:使用预训练的多模态大型语言模型作为文本编码器,提高图像-文本对齐和复杂推理能力。

3D VAE压缩:通过Causal 3D VAE压缩像素级视频和图像到紧凑的潜在空间,减少后续扩散变换模型的令牌数量。

提示重写模型:针对用户提供的提示的变异性,微调Hunyuan-Large模型以适应模型偏好的提示。

高效的视频生成:支持多种分辨率和帧率的视频生成,满足不同场景的需求。

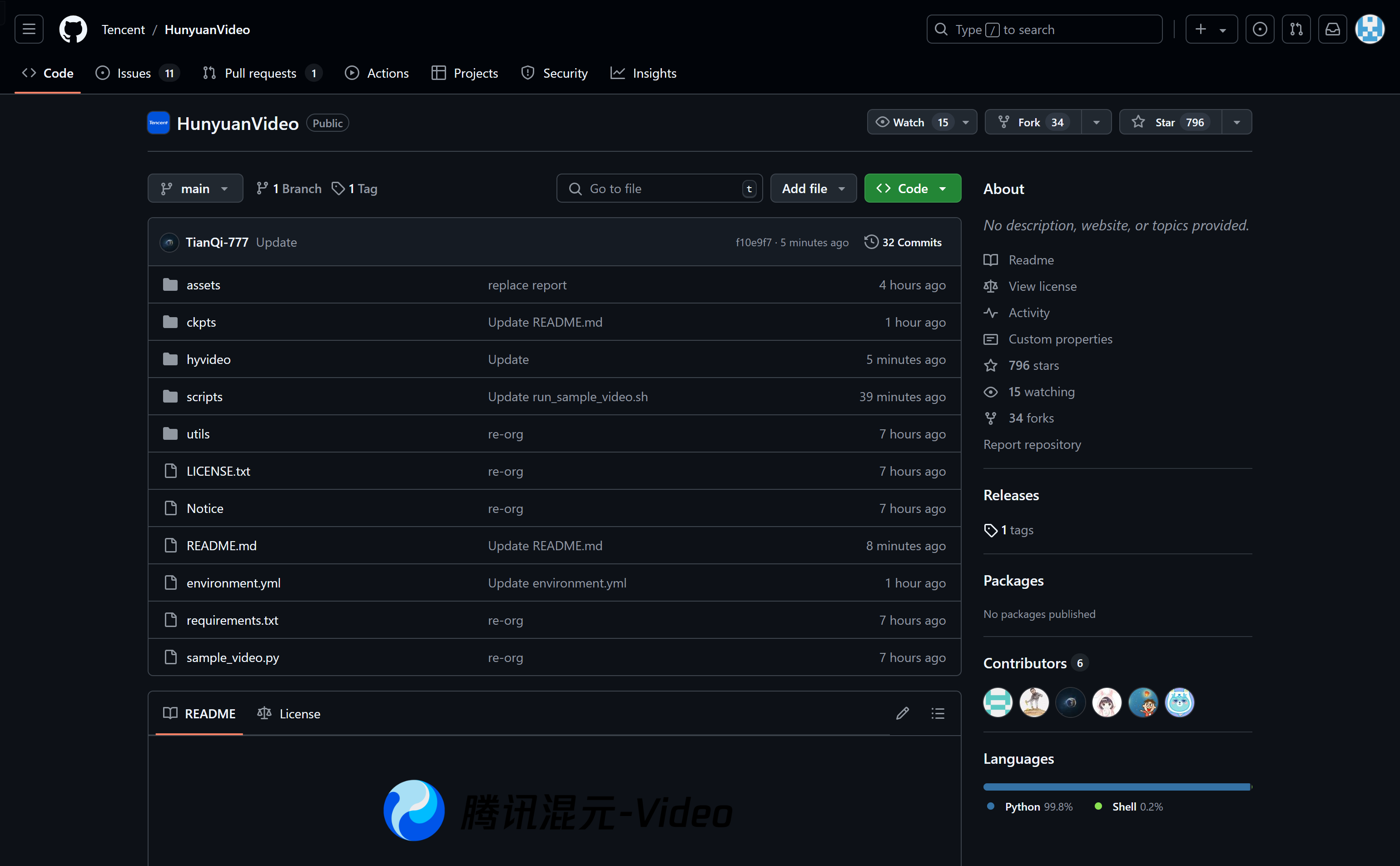

开源代码和模型权重:便于社区成员进行实验和创新。

使用教程

1. 克隆HunyuanVideo仓库到本地。

2. 根据提供的`environment.yml`文件设置Conda环境,并激活环境。

3. 安装所需的pip依赖项。

4. 安装flash attention v2以加速模型运行。

5. 下载预训练模型。

6. 使用命令行工具`sample_video.py`进行视频生成,指定视频大小、长度、采样步数和文本提示等参数。

7. 运行命令并等待视频生成完成,检查指定的保存路径获取结果。