使用场景

案例一:使用Qwen2-VL-7B进行视频内容的自动摘要和问题回答。

案例二:集成Qwen2-VL-7B到移动应用中,实现基于图像的搜索和推荐。

案例三:利用Qwen2-VL-7B进行多语言文档的视觉问答和内容分析。

产品特色

- 支持各种分辨率和比例的图像理解:Qwen2-VL在视觉理解基准测试中取得了最先进的性能。

- 理解超过20分钟的视频:Qwen2-VL能够理解长视频,支持高质量的视频问题回答和对话。

- 集成到移动设备和机器人等设备中:Qwen2-VL具备复杂推理和决策能力,可以集成到移动设备和机器人中,实现基于视觉环境和文本指令的自动操作。

- 多语言支持:Qwen2-VL支持多种语言的文本理解,包括大多数欧洲语言、日语、韩语、阿拉伯语、越南语等。

- 任意图像分辨率处理:Qwen2-VL可以处理任意图像分辨率,提供更接近人类视觉处理的体验。

- 多模态旋转位置嵌入(M-ROPE):Qwen2-VL通过分解位置嵌入来捕获1D文本、2D视觉和3D视频位置信息,增强其多模态处理能力。

使用教程

1. 安装最新版本的Hugging Face transformers库,使用命令`pip install -U transformers`。

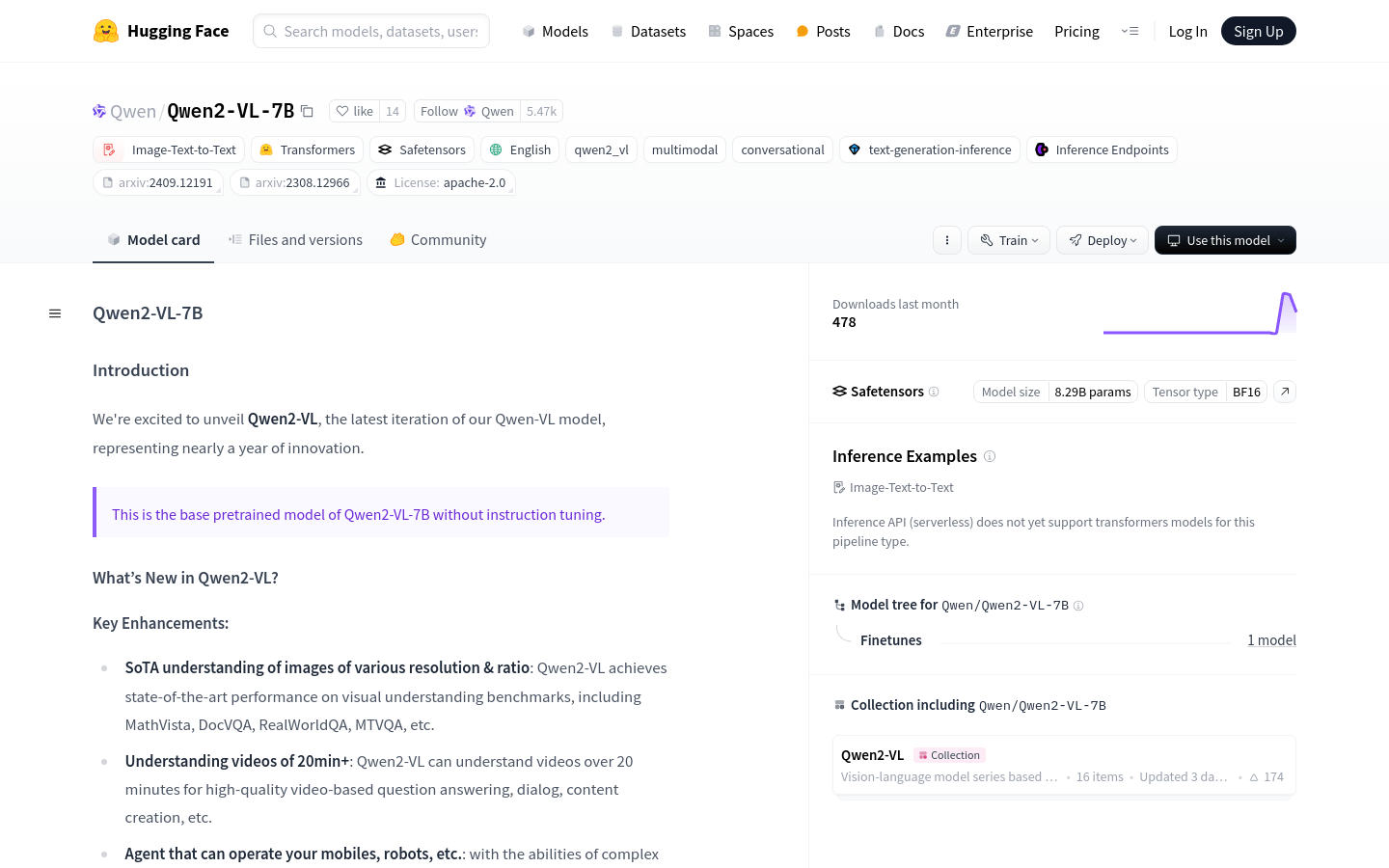

2. 访问Qwen2-VL-7B的Hugging Face页面,了解模型的详细信息和使用指南。

3. 根据具体需求,选择合适的预训练模型进行下载和部署。

4. 使用Hugging Face提供的工具和接口,将Qwen2-VL-7B集成到自己的项目中。

5. 根据模型的API文档,编写代码以实现图像和文本的输入处理。

6. 运行模型,获取输出结果,并根据需要进行后处理。

7. 根据模型的输出,进行进一步的分析或应用开发。