使用场景

利用EXAONE-3.5-32B-Instruct-GGUF进行长篇文章的生成和内容理解。

在多语言环境下,使用该模型进行跨语言的文本翻译和信息检索。

在对话系统和聊天机器人中,应用该模型以提供更自然和准确的语言交互。

产品特色

支持长上下文处理,上下文长度可达32K令牌。

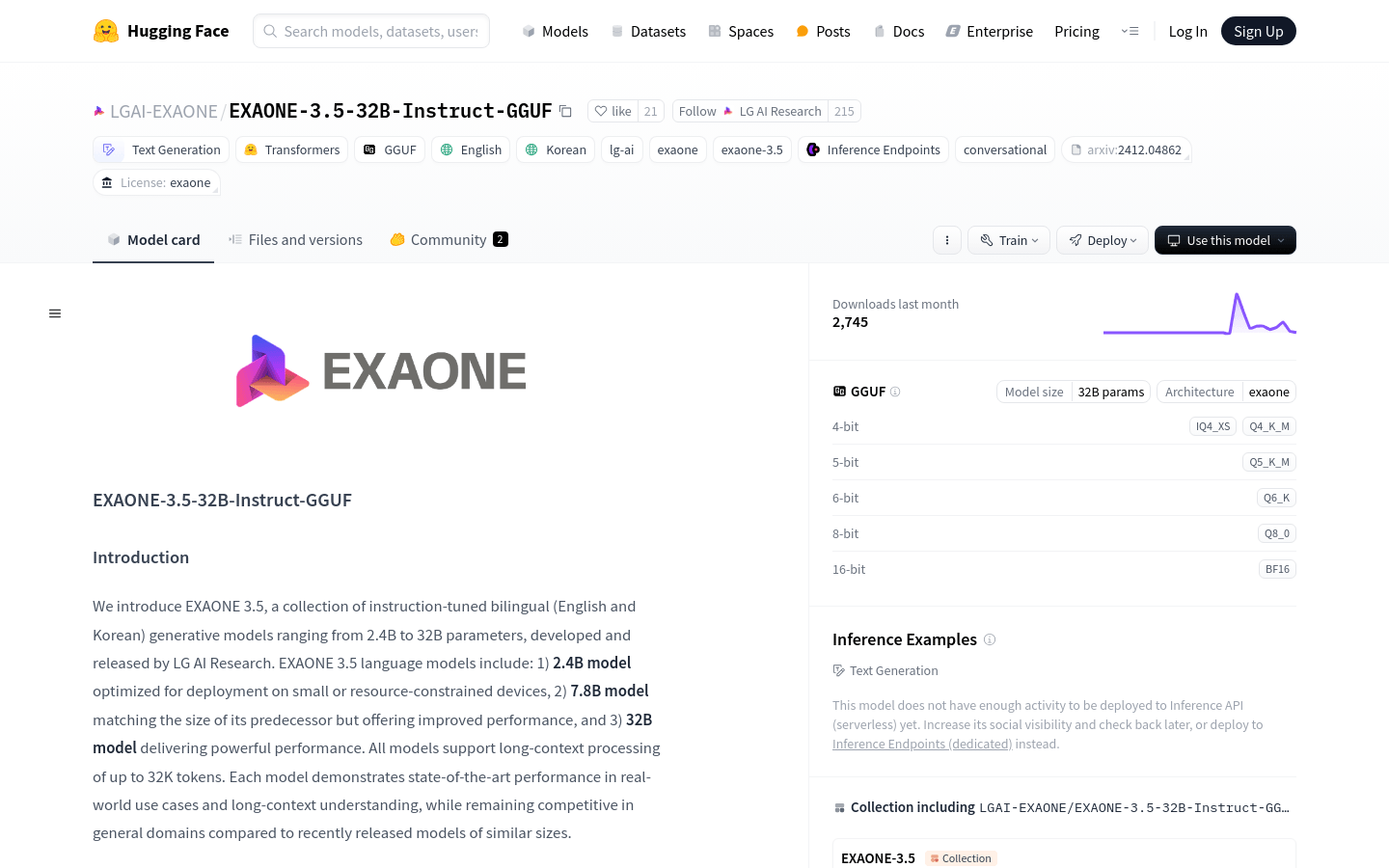

包含不同精度的模型,如Q8_0、Q6_0、Q5_K_M、Q4_K_M、IQ4_XS和BF16。

优化了模型部署,包括2.4B模型针对小型或资源受限设备优化。

提供预量化模型,使用AWQ和多种量化类型。

支持多种部署框架,如TensorRT-LLM、vLLM、SGLang、llama.cpp和Ollama。

模型训练考虑了系统提示的使用,提高了对话和交互的效率。

模型生成的文本不反映LG AI Research的观点,确保了内容的中立性。

使用教程

1. 安装llama.cpp,具体安装指南请参考llama.cpp的GitHub仓库。

2. 下载EXAONE 3.5模型的GGUF格式文件。

3. (可选)如果使用BF16精度,可能需要合并分割的文件。

4. 使用llama.cpp运行模型,并在对话模式下进行测试。

5. 遵循系统提示的使用建议,以获得最佳的模型性能。