使用场景

研究人员使用EXAONE 3.5模型进行长文本的语义理解和分析。

开发者利用EXAONE 3.5模型开发多语言对话系统。

企业使用EXAONE 3.5模型优化其客户服务自动化流程。

产品特色

支持长达32K令牌的长上下文处理能力。

在真实世界用例和长上下文理解方面展现出最先进的性能。

与近期发布的类似大小模型相比,在通用领域保持竞争力。

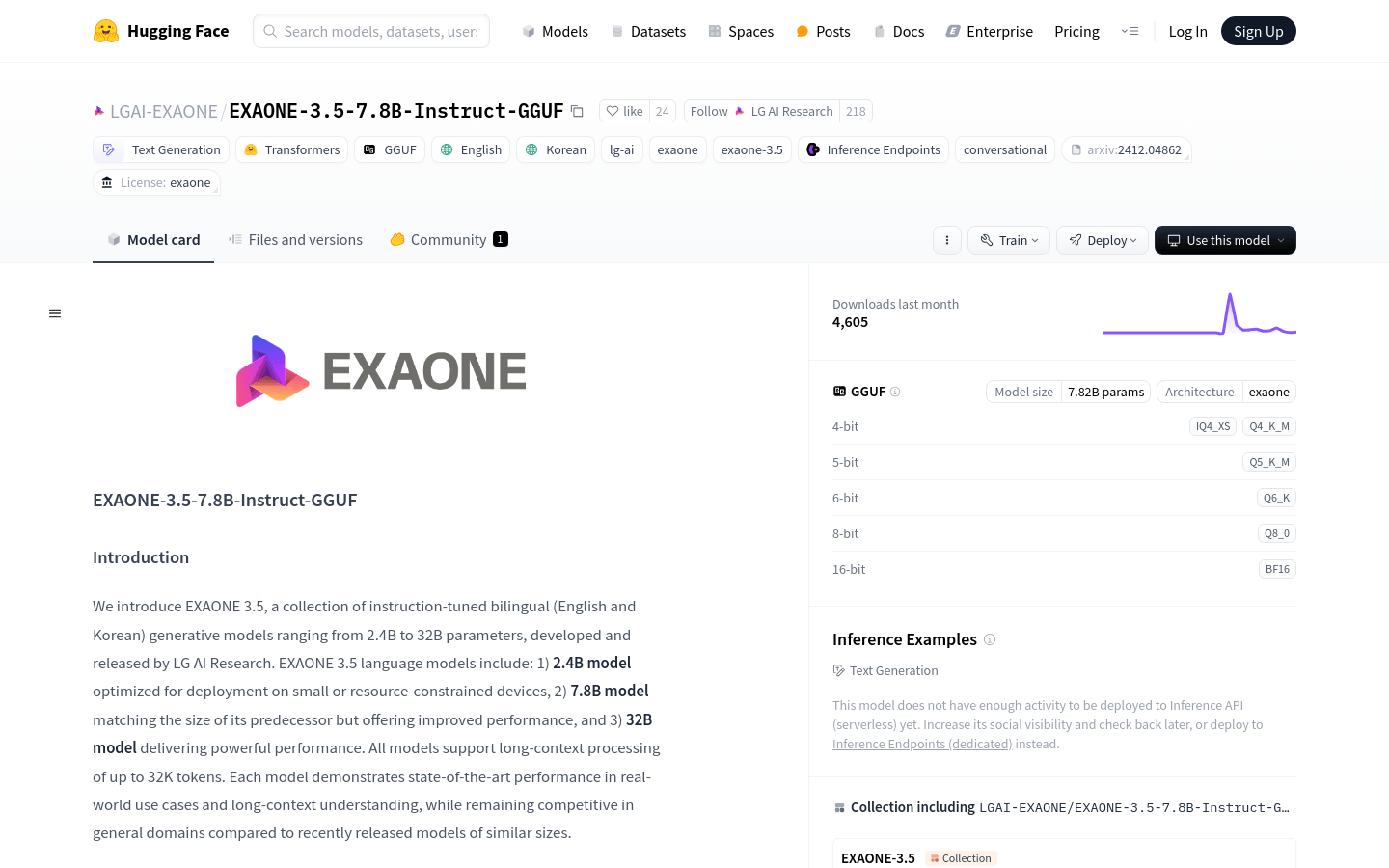

提供多种精度的指令调优7.8B语言模型,包括Q8_0、Q6_0、Q5_K_M、Q4_K_M、IQ4_XS等量化类型。

支持多种部署框架,如TensorRT-LLM、vLLM、SGLang、llama.cpp和Ollama。

模型经过优化,适用于小或资源受限的设备。

提供预量化的EXAONE 3.5模型,使用AWQ和多种量化类型。

使用教程

1. 安装llama.cpp,具体安装指南请参考llama.cpp的GitHub仓库。

2. 下载EXAONE 3.5模型的GGUF格式文件。

3. 使用huggingface-cli下载指定的EXAONE 3.5模型文件,例如:'huggingface-cli download LGAI-EXAONE/EXAONE-3.5-7.8B-Instruct-GGUF --include "EXAONE-3.5-7.8B-Instruct-BF16*.gguf" --local-dir .'

4. 使用llama-cli运行模型进行对话模式的推理,例如:'llama-cli -cnv -m ./EXAONE-3.5-7.8B-Instruct-BF16.gguf -p "You are EXAONE model from LG AI Research, a helpful assistant."'