使用场景

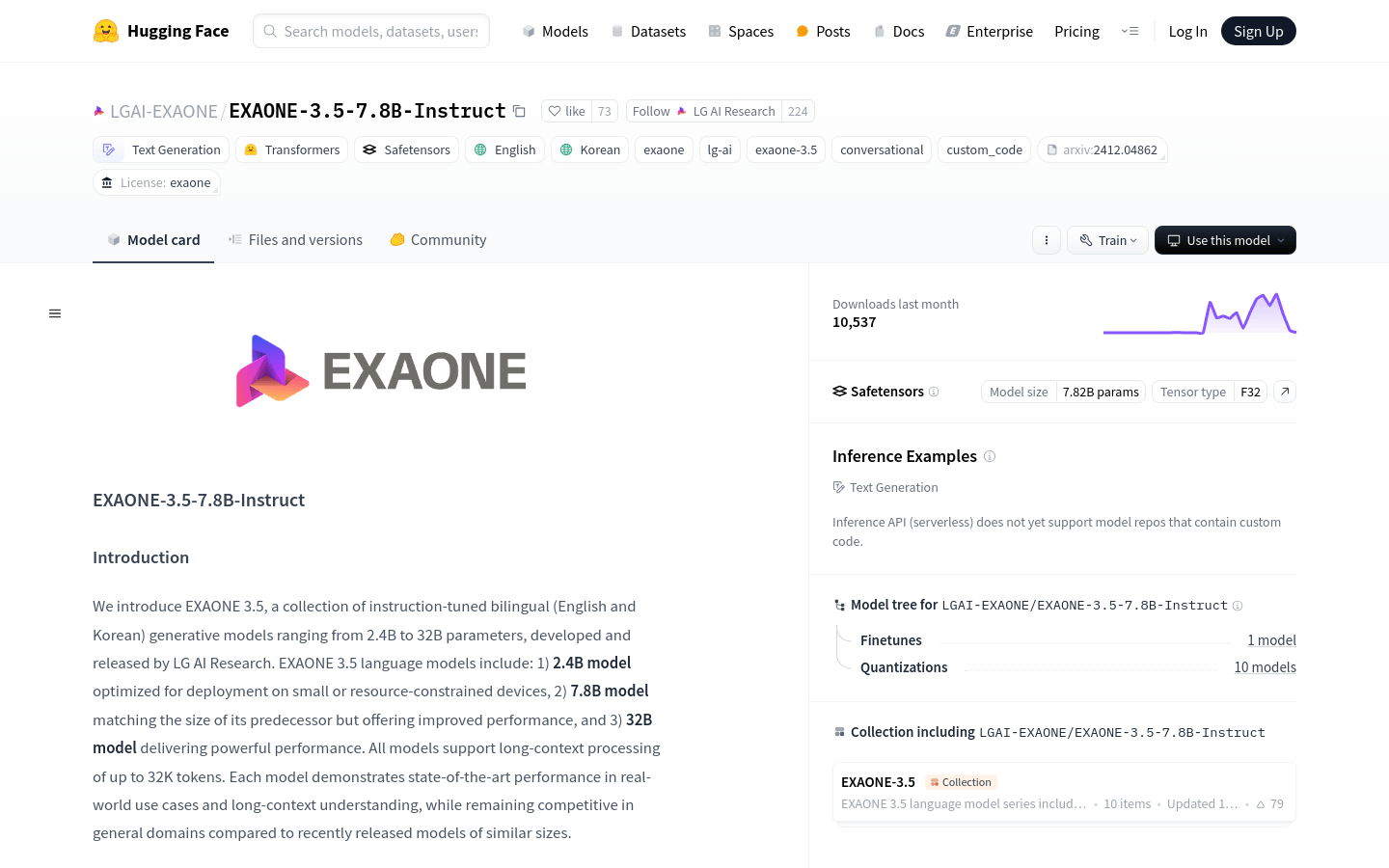

用于生成高质量的英语和韩语文本

在长上下文理解任务中提供先进的性能

在多种真实世界用例中展现出竞争力

产品特色

参数数量(不包括嵌入):6.98B

层数:32

注意力头数:GQA,32个Q头和8个KV头

词汇量:102,400

上下文长度:32,768令牌

支持长上下文处理,最长达32K令牌

在真实世界用例中展现出最先进的性能

使用教程

1. 安装transformers库v4.43或更高版本

2. 使用AutoModelForCausalLM和AutoTokenizer从Hugging Face加载模型和分词器

3. 选择或编写提示(prompt)

4. 使用tokenizer.apply_chat_template方法处理消息并生成输入ID

5. 使用模型的generate方法生成文本

6. 使用tokenizer.decode方法将输出的令牌解码为文本